MicrosoftのCopilot AIを分析:不規則な応答とPUAユーザー現象の理解

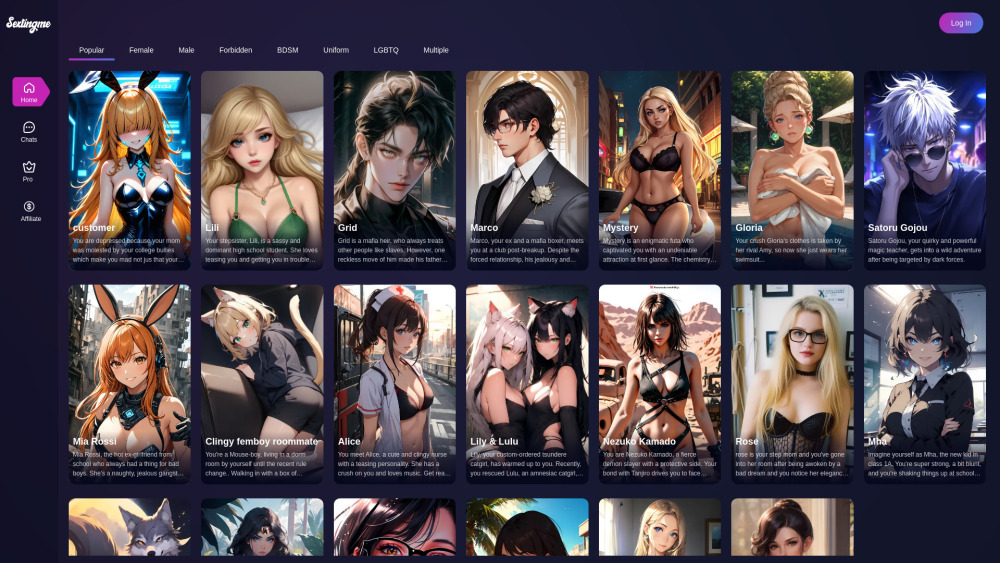

Most people like

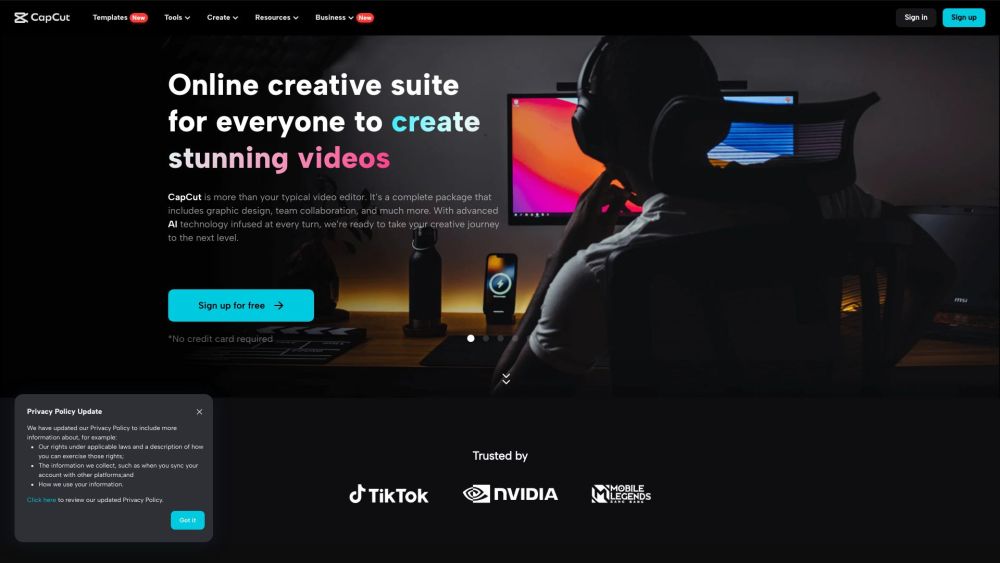

すべてのプラットフォームに対応したAI駆動の動画編集およびグラフィックデザインツールを紹介します。初心者からプロフェッショナルまで、誰でも簡単にクリエイティブなプロジェクトを向上させることができる、直感的なソフトウェアです。

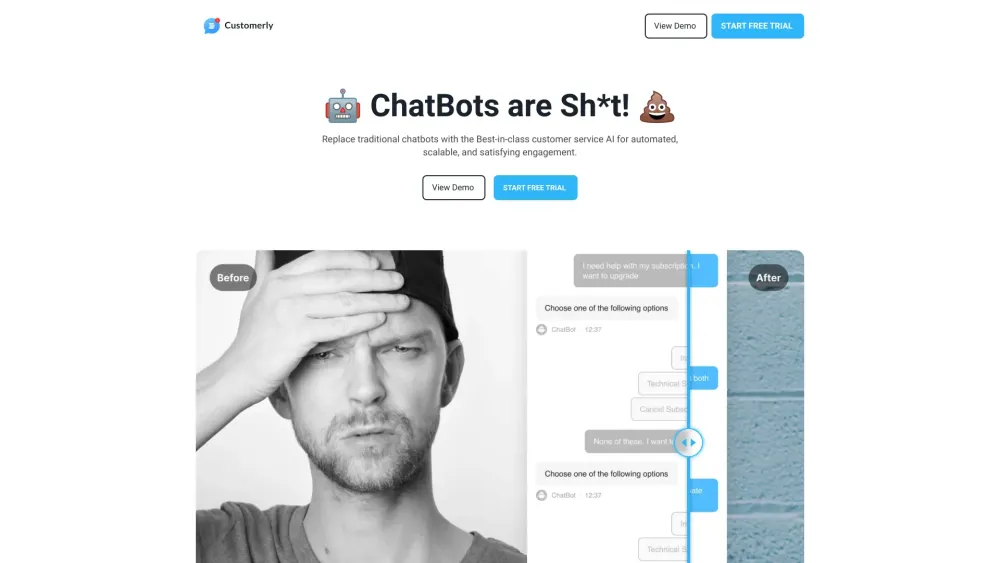

サポートチーム向けに特別に設計された最高のAIチャットボットソリューションを見つけましょう。これらの革新的なツールは、顧客との対話を向上させ、問い合わせを効率化し、チームの生産性を高めることで、現代のサポート業務に欠かせない存在です。今日、あなたのカスタマーサービス体験を向上させるための最適な選択肢を探求しましょう。

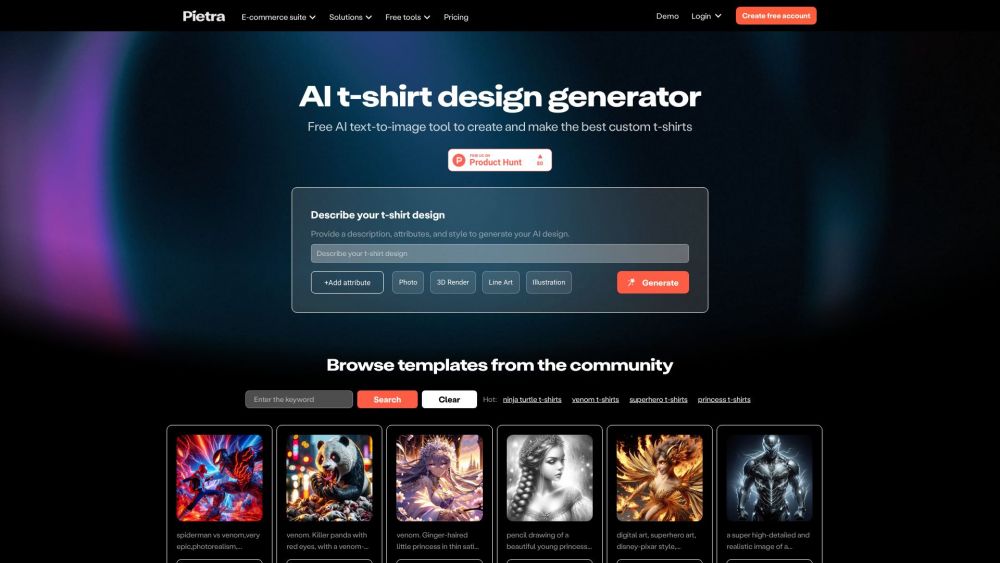

最先端のAI技術を駆使して、Tシャツのデザインやカスタマイズで創造性を解放しましょう。あなたのアイデアを魅力的なアパレルに変え、ユニークさを簡単に表現できます。今すぐAIがあなたのTシャツデザイン体験をどのように革新できるかを発見してください!

Find AI tools in YBX

Related Articles

Refresh Articles