NvidiaとMicrosoftが提携し、Copilot+で重大な課題に挑む

Most people like

最先端のAI動画作成プラットフォームで、魅力的なビジュアルの動画コンテンツを変革しましょう。人工知能の力を活用して、高品質な動画を制作し、観客と共鳴し、あなたのブランドを引き上げます。マーケター、教育者、またはコンテンツクリエイターであっても、当プラットフォームは動画制作プロセスを効率化し、効果的なストーリーテリングを手の届くところで実現します。

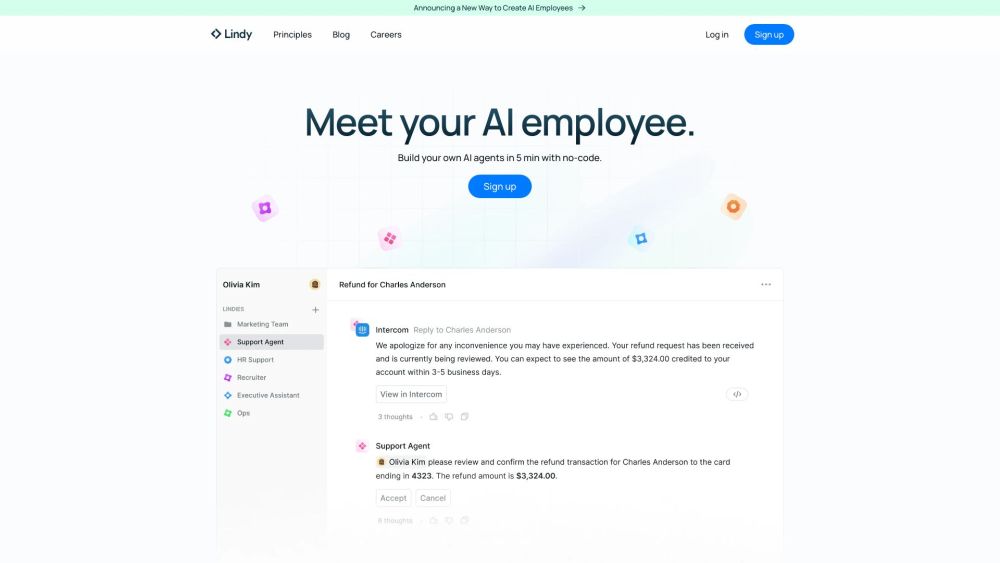

コーディング不要で自分だけのAIエージェントを簡単に作成!

プログラミング知識がなくても、パーソナライズされたAIエージェントを構築して、人工知能の力を最大限に引き出しましょう。ビジネスオーナー、開発者、またはAIに興味がある方であれば、私たちのプラットフォームを利用して、特定のニーズに合わせたインテリジェントなエージェントを設計・展開できます。コーディング不要のソリューションの世界に飛び込み、簡単にAIアイデアを実現しましょう!

BookAI.topへようこそ。ここは、多様なAI技術に関する洞察に満ちたチュートリアルを提供するために設計されたあなたのためのAI学習プラットフォームです。私たちの使命は、急速に進化する人工知能の分野における最先端の知識で、あなたの仕事と学びの体験を向上させることです。

Find AI tools in YBX