OpenAI研究者が「警告する権利」を要求 - 人類滅亡を防ぐための安全リスクへの行動を促す

Most people like

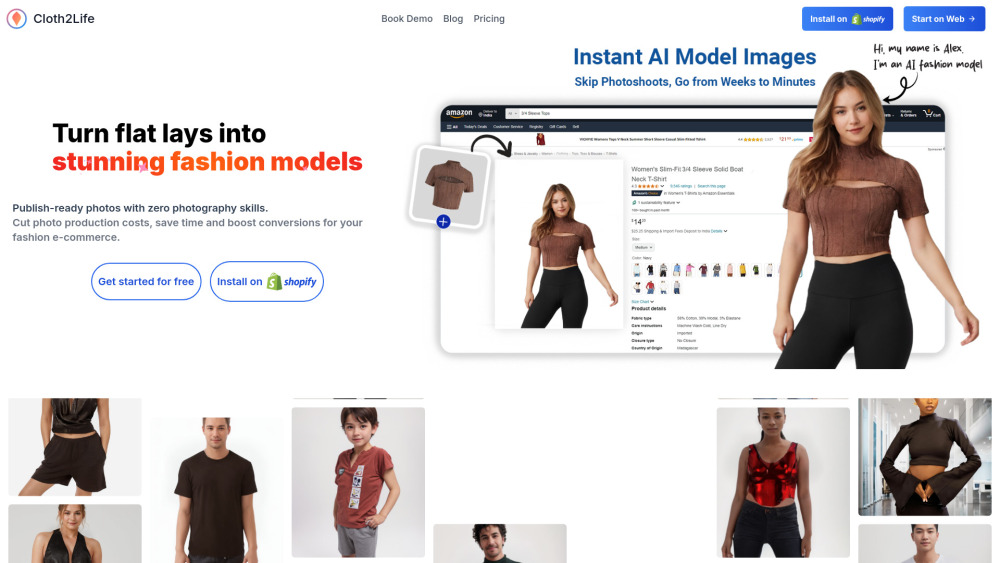

フラットレイデザインから直接、美しいファッションモデルの画像を作成するために設計された革新的なAIプラットフォームを発見してください。この画期的なツールは人工知能の力を活用し、ファッションコンセプトを生き生きと具現化します。動的で魅力的な方法で衣服を視覚化でき、デザイナーや小売業者に最適です。このプラットフォームは、静的な画像を鮮やかで目を引くモデルビジュアルへと変換し、マーケティング戦略を一段と引き上げます。

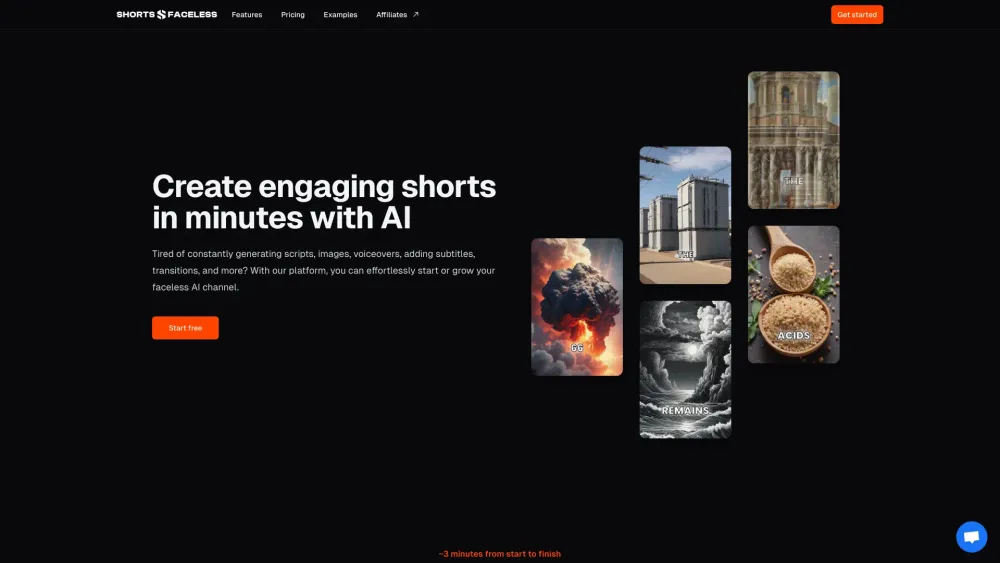

簡単に魅力的なAIショートを作成しよう

手軽にAI生成ショートの可能性を引き出そう!わずか数クリックで、あなたの創造的なアイデアを魅力的なコンテンツに変えます。私たちの使いやすいプラットフォームを利用すれば、人工知能の力を活かして高品質なショートを制作し、観客を引き込むことができます。ストーリーテリングを向上させつつ、時間と労力を節約できる効率的なプロセスをお楽しみください。今日からあなたのユニークなAIショートを生成し始めましょう!

Find AI tools in YBX

Related Articles

Refresh Articles