アップルの研究者が発表した画期的なAIシステム:GPT-4を超える革新技術とは

Most people like

AI駆動のプラットフォームによる動画アクセシビリティの向上

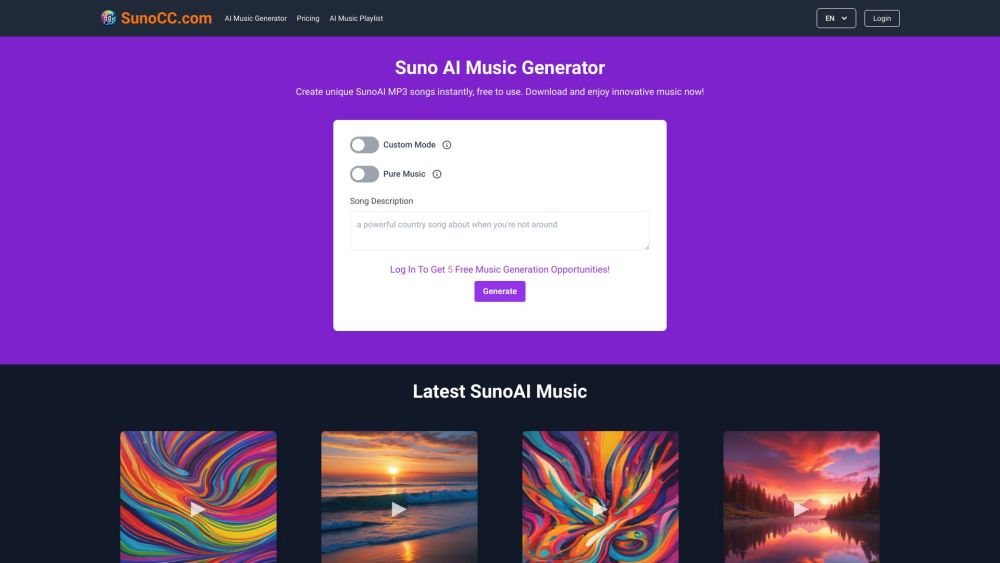

今日のデジタル社会では、動画のアクセシビリティを確保することが多様な視聴者の関与にとって重要です。私たちの革新的なAIプラットフォームは、動画コンテンツを自動的にキャプション、トランスクリプト、翻訳を生成することで変革し、聴覚障害者や非母国語話者を含むすべての人々にアクセス可能にします。全ての視聴者のためにメディアの可能性を解き放ち、動画コンテンツを普遍的にアクセス可能にする取り組みにご参加ください。

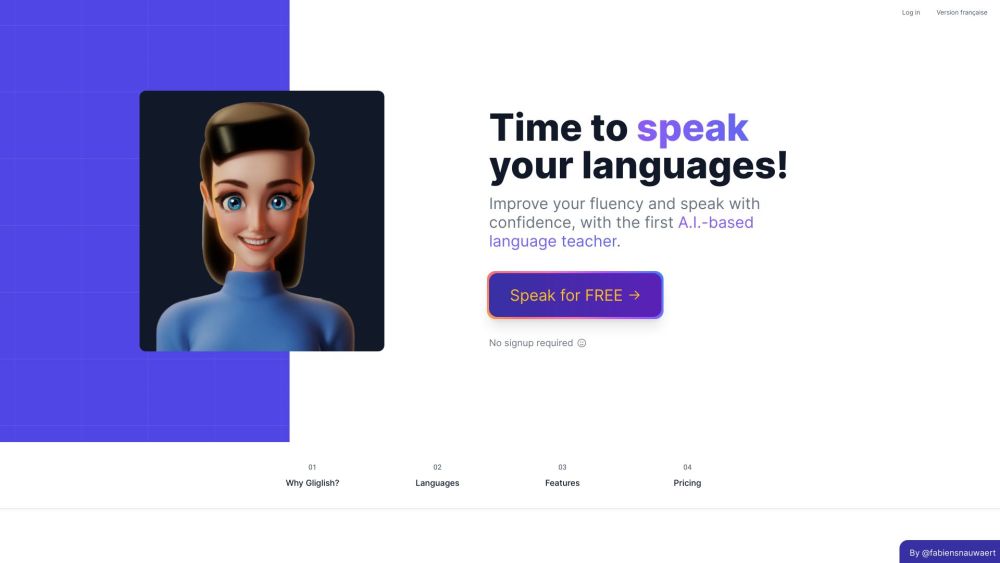

Gliglishは、手頃な価格で会話力とリスニング力を向上させるために設計された革新的なAI語学教師です。Gliglishで効果的な言語学習を体験し、あなたの可能性を今日から解き放ちましょう!

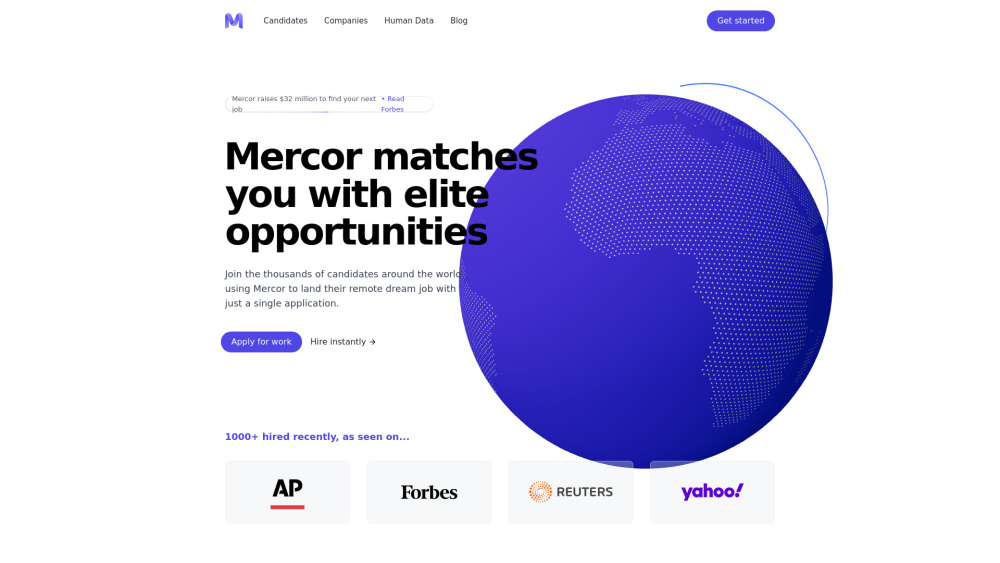

私たちの高度なAIプラットフォームをご紹介します。これは、従業員の調達、審査、支払いをシームレスに行うために特別に設計されています。最先端の技術で採用プロセスを向上させ、効率的かつ労力をかけずに適切な人材を見つけることができます。革新的なソリューションを活用することで、従業員の支払い管理がこれまでになく簡単になり、競争の激しい市場でビジネスを成功させることができます。

Find AI tools in YBX

Related Articles

Refresh Articles