サマ、生成AIと大規模言語モデル向けのAI安全対策「レッドチーミングソリューション」を発表

Most people like

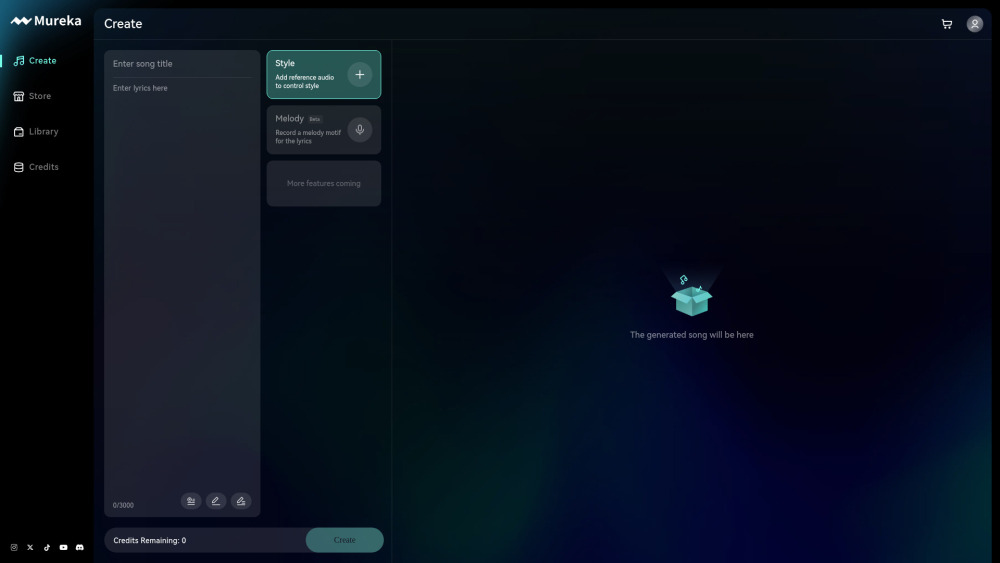

近年、AI音楽制作プラットフォームは、音楽の作曲、制作、体験の方法を革新しています。これらの革新的なツールは、高度なアルゴリズムを駆使して、ミュージシャンやクリエイターが独自の音やメロディを生成するのを支援します。経験豊富なミュージシャンであれ、期待のアーティストであれ、AI音楽制作プラットフォームは芸術的探求と創造性の興奮を提供します。これらの最先端技術が音楽業界をどのように再構築し、世界中のクリエイターに力を与えているのかを発見してください。

私たちの革新的なAIキャラクターチャットプラットフォームを探索し、魅力的で安全な対話をお楽しみください。他のプラットフォームとは異なり、私たちはファミリー向けの環境を最優先し、すべての話題がNSFWコンテンツから自由であることを保証します。あらゆる年齢層のユーザーに最適な、安全な空間でキャラクターとつながるユニークな体験にご参加ください!

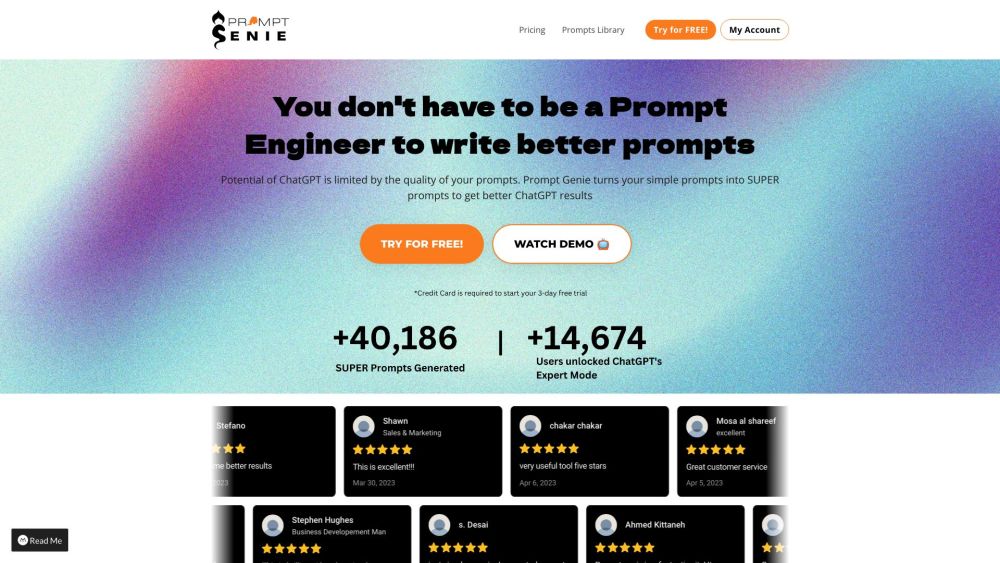

Prompt Genieを使って、ChatGPTの体験を向上させましょう。AI駆動のこのツールは、プロンプトを強化し、卓越した結果をもたらすように設計されています。質問を洗練させたい方や、より創造的な応答を生成したい方に、Prompt GenieはChatGPTの最大の可能性を引き出し、最適なパフォーマンスを実現するお手伝いをします。

Find AI tools in YBX