OpenAI, ChatGPT Plus 사용자들을 위해 GPT-4o 음성 모드를 출시하여 자연스러운 실시간 대화를 더욱 향상시켰습니다.

Most people like

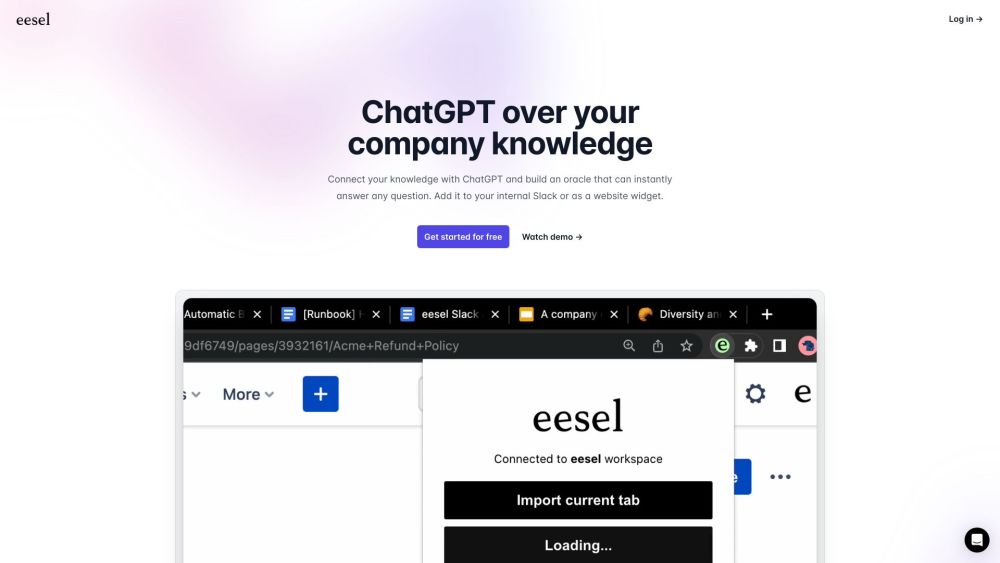

eesel.ai는 지식을 ChatGPT와 매끄럽게 통합하여 강력한 질문-답변 오라클을 만드는 혁신적인 플랫폼입니다. eesel.ai를 통해 사용자는 정확한 정보와 통찰력을 쉽게 접근할 수 있어 학습 및 의사결정 경험을 향상시킬 수 있습니다.

Subtxt는 이야기꾼들이 매력적인 이야기를 작성할 수 있도록 돕기 위해 설계된 최첨단 글쓰기 도구입니다. 지능형 기능을 갖춘 Subtxt는 사용자가 이야기 스킬을 향상시키고 독자와 효과적으로 소통할 수 있도록 지원합니다.

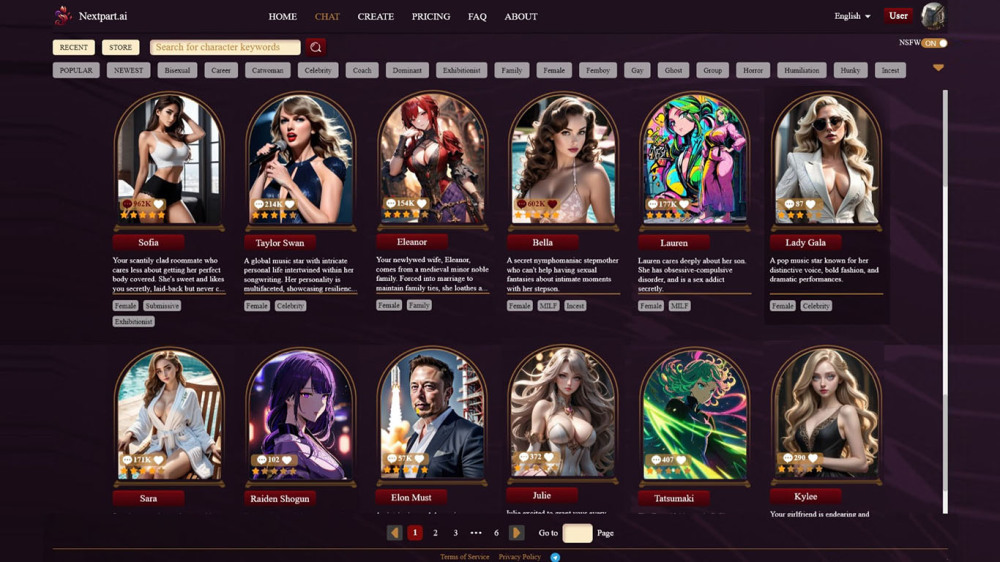

다양한 대화를 위한 독창적인 캐릭터를 생성하고 커스터마이즈할 수 있는 차세대 AI 채팅 앱을 만나보세요. 채팅 경험을 향상시키기 위해 설계된 이 혁신적인 플랫폼에서 새로운 차원의 상호작용을 경험해 보세요.

Find AI tools in YBX

Related Articles

Refresh Articles