Amazon Investiga a Perplexity AI por Alegações de Coleta Não Autorizada de Dados de Sites

Most people like

Revolucionando a Declaração Aduaneira: Soluções de IA para Empresas Globais

Em um mundo cada vez mais interconectado, as empresas globais enfrentam o complexo desafio da declaração aduaneira. A utilização de soluções de IA de ponta pode otimizar o processo aduaneiro, aumentando a eficiência e a conformidade. Descubra como essas tecnologias inovadoras podem transformar as operações da sua empresa e facilitar a navegação no comércio internacional.

Desbloqueie todo o potencial de seus vídeos e gravações de áudio ao reaproveitá-los em conteúdos atraentes. Este guia mostrará como converter efetivamente sua multimídia em postagens de blog, atualizações para redes sociais, podcasts e muito mais. Ao aproveitar ativos já existentes, você pode ampliar seu alcance, engajar seu público e maximizar o impacto de seu conteúdo. Descubra a arte da transformação de conteúdo e faça sua multimídia brilhar.

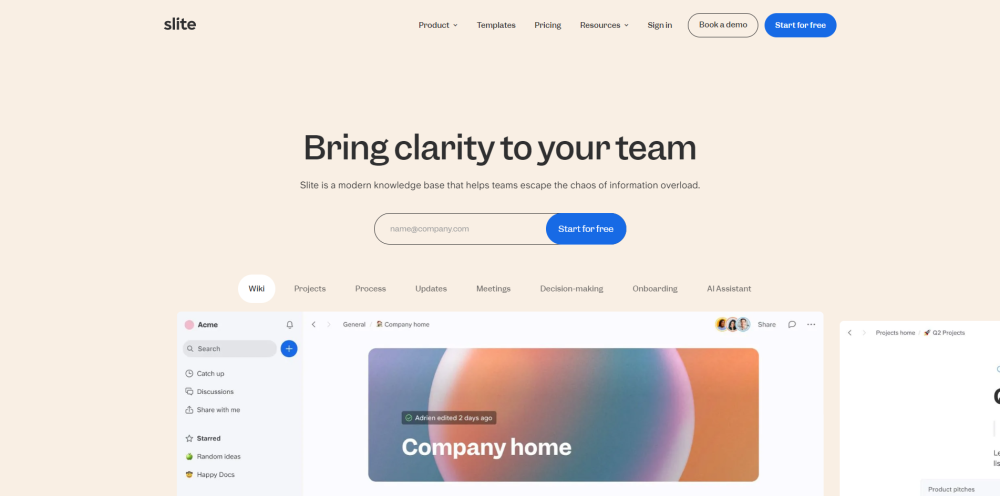

Descubra o Slite, uma base de conhecimento impulsionada por IA, projetada para proporcionar acesso fácil a informações confiáveis da empresa ao seu alcance.

Find AI tools in YBX

Related Articles

Refresh Articles