Hoje, a Snowflake anunciou o Arctic, um modelo de linguagem grande (LLM) desenvolvido para tarefas complexas em empresas, como geração de SQL, criação de código e aderência a instruções. Comercializado como o "LLM empresarial mais aberto", o Arctic utiliza uma arquitetura de especialista misto (MoE), alcançando de forma eficiente os melhores benchmarks para cargas de trabalho empresariais. Ele demonstra um desempenho competitivo em comparação com modelos padrão da Databricks, Meta e Mistral, em áreas como conhecimento geral, senso comum, raciocínio e capacidades matemáticas.

“Este é um momento decisivo para a Snowflake, com nossa equipe de pesquisa em IA na vanguarda da inovação”, afirmou o CEO Sridhar Ramaswamy. “Ao fornecer inteligência e eficiência de liderança da indústria de forma aberta, estamos expandindo o potencial da IA de código aberto. Nossa pesquisa com o Arctic aprimorará significativamente nossa capacidade de oferecer IA confiável e eficiente aos nossos clientes.”

O lançamento representa um movimento estratégico da Snowflake para competir com a Databricks, que tem sido agressiva em suas iniciativas de IA. O foco da Snowflake em IA se intensificou recentemente após a aquisição da Neeva e a nomeação de Ramaswamy como CEO.

Arctic: Projetado para Cargas de Trabalho Empresariais

À medida que as empresas modernas adotam a IA generativa, há um aumento no desenvolvimento de aplicações como chatbots de geração aumentada por recuperação (RAG), copilotos de dados e assistentes de código. Embora existam numerosos modelos, poucos atendem especificamente às necessidades empresariais—é aqui que o Arctic se destaca.

“Acreditamos que a IA irá aprimorar o desenvolvimento de produtos de IA de ponta a ponta. Nossa visão é criar uma API que permita aos usuários de negócios interagir diretamente com os dados, democratizando-os em toda a empresa. O Arctic é um passo vital para concretizar essa visão”, disse Ramaswamy em um briefing recente.

O Arctic utiliza uma arquitetura híbrida Dense MoE, segmentando parâmetros em 128 subgrupos de especialistas especializados. Esses especialistas processam apenas os tokens de entrada que estão melhor preparados para lidar, ativando apenas 17 bilhões dos 480 bilhões de parâmetros ao responder a uma consulta. Essa abordagem direcionada garante alto desempenho com poder computacional mínimo.

Os benchmarks indicam que o Arctic aborda efetivamente tarefas empresariais, alcançando uma pontuação média de 65% em diversos testes. Esse desempenho está próximo da pontuação média de 70% do Llama 3 70B e apenas atrás do Mixtral 8X22B, que também teve 70%.

No benchmark Spider para geração de SQL, o Arctic obteve 79%, superando o DBRX da Databricks e o Mixtral 8X7B, e se aproximando do Llama 3 70B e Mixtral 8X22B. Para tarefas de codificação, o Arctic alcançou 64,3%, superando a Databricks e o modelo menor da Mixtral, embora tenha ficado atrás do Llama 3 70B e do Mixtral 8X22B.

Notavelmente, no benchmark IFEval para capacidades de seguimento de instruções, o Arctic marcou 52,4%, superando a maioria dos concorrentes, exceto pelo mais recente modelo da Mixtral.

Eficiência e Custo-Benefício

A Snowflake afirma que o nível de inteligência empresarial do Arctic foi alcançado com eficiência inovadora, utilizando um orçamento de treinamento de computação abaixo de US$ 2 milhões — significativamente menos do que outros modelos como o Llama 3 70B, que usou 17 vezes mais recursos computacionais. Além disso, o uso de apenas 17 parâmetros ativos melhora ainda mais seu custo-benefício.

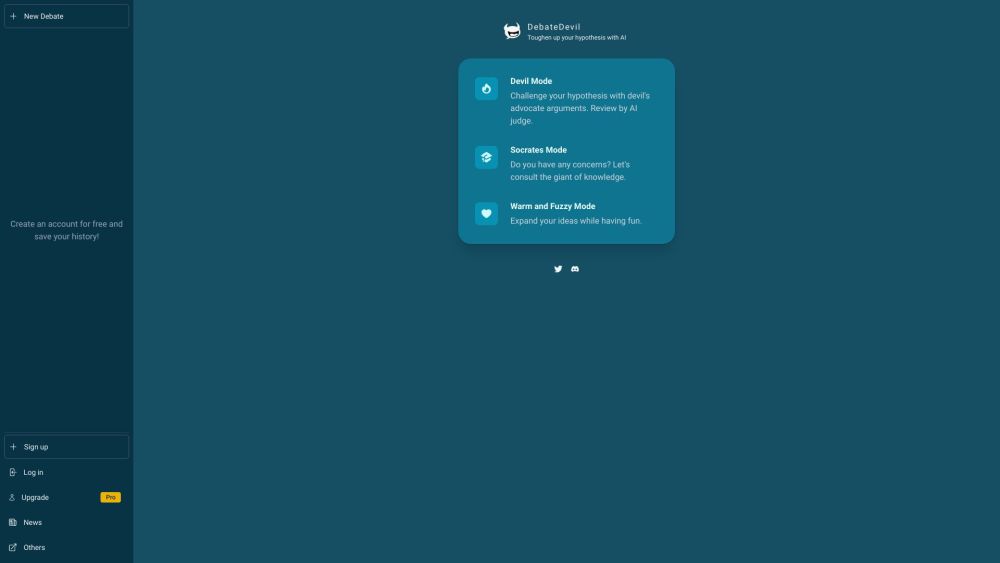

Disponibilidade Sob a Licença Apache 2.0

A Snowflake está tornando o Arctic acessível por meio do Cortex, seu serviço de desenvolvimento de aplicações LLM, e em vários catálogos de modelos, incluindo Hugging Face, Lamini, Microsoft Azure, catálogo da API da Nvidia, Perplexity e Together. Os usuários podem baixar os pesos e o código do modelo Arctic no Hugging Face sob licença Apache 2.0, facilitando o uso pessoal, comercial ou de pesquisa sem restrições.

Juntamente com o lançamento do modelo, a Snowflake está fornecendo uma receita de dados para ajuste fino eficiente em uma única GPU e livros de receitas abrangentes, detalhando o design e os processos de treinamento do modelo.

“O livro de receitas foi elaborado para acelerar a curva de aprendizagem de quem estiver interessado em modelos MoE de classe mundial, oferecendo tanto insights de alto nível quanto especificações técnicas detalhadas para capacitar os usuários a construir LLMs eficientes e econômicos como o Arctic”, afirmou Baris Gultekin, chefe de IA da Snowflake, durante o briefing à imprensa.