В последнее время технологии не представляли такой серьезной угрозы обществу, как дипфейки. Этот манипулятивный контент, созданный искусственным интеллектом, уже используется в политике и, по прогнозам, будет доминировать на предстоящих президентских выборах в США, а также в сенатских и конгрессных гонках. Пока регуляторы пытаются контролировать эту технологию, невероятно реалистичные дипфейки применяются для дискредитации кандидатов, влияния на общественное мнение и манипуляции явкой избирателей. В то же время некоторые кандидаты пытаются использовать генеративный ИИ для улучшения своих кампаний, что часто приводит к катастрофическим последствиям.

Профессор Хани Фарид из Школы информации Калифорнийского университета в Беркли инициировал проект по мониторингу дипфейков на протяжении президентской кампании 2024 года. "Я надеюсь, что, освещая этот контент, мы повысим осведомленность среди СМИ и общественности и подадим сигнал создателям этого контента, что мы следим за ними и найдем их", — заявил Фарид.

На одном из примеров его сайта представлены изображения президента Джо Байдена в военной форме в командном центре. На сайте акцентируются несоответствия, такие как неправильно расположенные компьютерные мыши и искаженный дизайн потолка, что указывает на манипуляцию изображениями.

Исследования Фарида также касаются известных дипфейк-робозвонков, выдающих себя за Байдена перед первичными выборами в Нью-Гэмпшире. Эти звонки призывали граждан не голосовать, утверждая: "Голосование в этот вторник только помогает республиканцам вновь избрать бывшего президента Дональда Трампа." Происхождение этих звонков остается неясным, но качество голоса кажется низким и странным.

В другом посте дипфейк Рона ДеСантиса ложно утверждает: "Я никогда не должен был бросать вызов президенту Трампу, величайшему президенту моего времени." Сайт также критикует монтаж с Трампом и бывшим главным медицинским советником Энтони Фаучи, указывая на явные несоответствия, такие как абсурдный логотип Белого дома и искаженные элементы на американском флаге.

Фарид подчеркивает, что даже небольшие изменения в настроениях избирателей могут изменить результаты выборов, особенно в ключевых штатах. Дипфейки становятся все более распространены, включая примеры, где Трамп изображается в ситуации ареста, украинский президент Зеленский призывает солдат сдаться, а вице-президент Камала Харрис выглядит пьяной на публичном мероприятии. Эти манипулятивные инструменты ранее повлияли на выборы в таких странах, как Турция и Бангладеш, в то время как некоторые политики, такие как представитель Дин Филлипс из Миннесоты и мэр Майами Франсис Суарес, использовали дипфейки для вовлечения избирателей.

"Я заметил рост как сложности, так и злоупотреблений дипфейками," замечает Фарид. "Этот год ощущается как переломный момент, когда миллиарды людей собираются голосовать по всему миру, а технологии быстро развиваются."

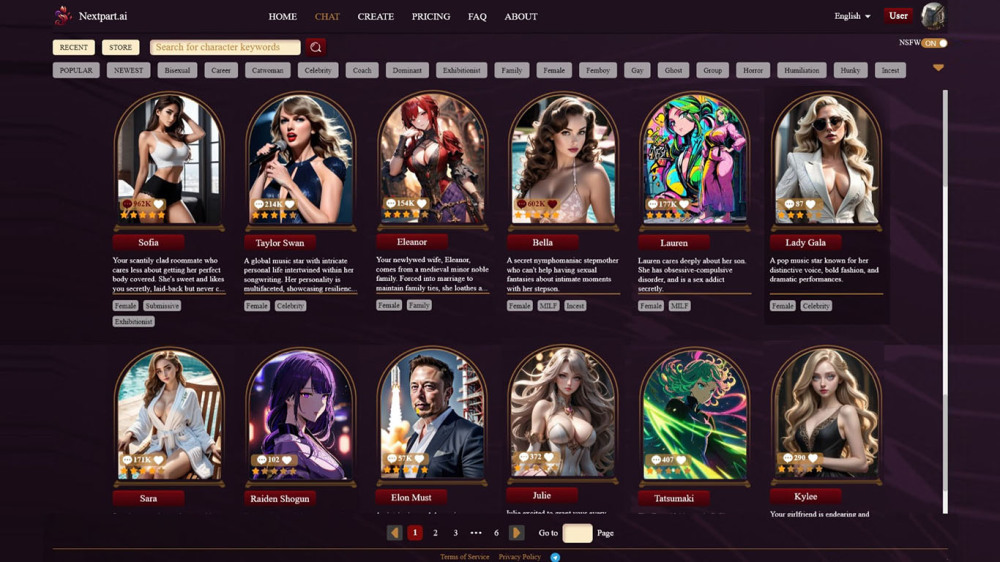

Опасность выходит за рамки манипуляции избирателями, поскольку дипфейки могут служить оправданиями для незаконного или неуместного поведения. Это явление, называемое "Дивидендом Лжеца", уже было использовано такими фигурами, как Трамп и Илон Маск. "Когда любое содержание можно сфальсифицировать, ничего не должно быть настоящим," подчеркивает Фарид.

Исследования показывают, что люди способны распознавать дипфейки видео чуть более чем в 50% случаев и обнаруживать фальшивое аудио в 73% случаев. С учетом того, что технологии становятся невероятно реалистичными, распространение подделок в социальных сетях может быстро привести к дезинформации. "Год назад дипфейки чаще всего были основаны на изображениях и довольно очевидными," вспоминает Фарид. "Сегодня мы видим сложные аудио и видео дипфейки, которые легко вводят зрителей в заблуждение."

Хотя сложно обнаружить постоянные предупреждающие знаки, Фарид советует не полагаться на социальные сети в получении новостей. "Если вам необходимо использовать социальные сети, замедлитесь, подумайте критически перед тем, как поделиться, и осознайте свои предвзятости. Распространение ложной информации лишь усугубляет проблему."

Тем, кто ищет практические советы, проект Northwestern University Detect Fakes предлагает тест на навыки распознавания, а MIT Media Lab предоставляет рекомендации, включая:

- Обратите внимание на лица, так как высококачественные манипуляции почти всегда связаны с изменениями лиц.

- Следите за несоответствиями кожи, такими как ненормально гладкие или морщинистые щеки и лбы, которые могут выглядеть не гармонично с текстурами волос и глаз.

- Наблюдайте за тенями и эффектами освещения, которые не соответствуют физике.

- Проверьте на наличие чрезмерной бликов на очках, которые не меняются с движением.

- Анализируйте щетину на лице на предмет неестественных добавлений или удаления.

- Следите за паттернами моргания и движением губ, так как многие дипфейки полагаются на синхронизацию губ.

Если вы подозреваете дипфейк, связанный с выборами в США, рассмотрите возможность связаться с Фаридом для дальнейшего расследования.