Генеративный ИИ обладает потенциалом значительно повысить продуктивность человека, но лишь немногие организации сегодня имеют необходимые экспертизу и ресурсы для разработки и обучения базовых моделей с нуля. Существующие проблемы двусторонние: во-первых, собрать необходимую обучающую информацию становится все труднее из-за строгих прав интеллектуальной собственности, удерживаемых владельцами контента. Во-вторых, финансовые затраты на обучение могут быть непомерно высокими. Тем не менее, общественные выгоды от широкого доступного использования технологий генеративного ИИ огромны.

Итак, как малые предприятия или индивидуальные разработчики могут интегрировать генеративный ИИ в свои приложения? Решение заключается в создании и внедрении индивидуализированных версий уже существующих базовых моделей.

Учитывая значительные инвестиции, связанные с разработкой новых генеративных ИИ моделей, они должны быть достаточно универсальными, чтобы соответствовать широкому спектру приложений — схожим образом с тем, как в настоящее время используются модели на базе GPT. Однако универсальная модель может не удовлетворить специфические потребности различных сфер деятельности. Использование крупной универсальной модели для специализированного приложения может привести к ненужному расходу вычислительных ресурсов, времени и энергии.

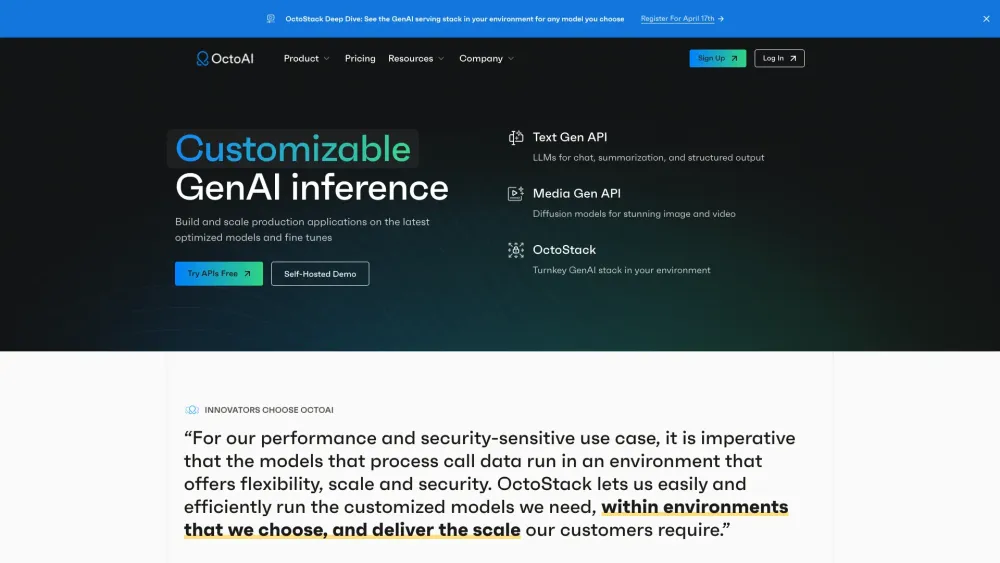

Поэтому большинству предприятий и разработчиков лучше начать с крупной генеративной ИИ модели в качестве фундамента, адаптируя её под свои конкретные нужды с значительно меньшими затратами на разработку. Этот подход также предлагает гибкость инфраструктуры, позволяя использовать доступные процессоры или ускорители ИИ, что позволяет избежать проблем, связанных с нехваткой графических процессоров. Главное — сосредоточиться на конкретном случае использования, сужая область проекта и оптимизируя гибкость с помощью открытого программного обеспечения и широко доступного оборудования.

Подход на основе случая использования для разработки ИИ-приложений

В разработке программного обеспечения случай использования описывает характеристики целевого пользователя, проблему, которую необходимо решить, и способы достижения этого. Это определение формирует требования к продукту, влияет на архитектуру программного обеспечения и предоставляет дорожную карту для жизненного цикла продукта. Более того, оно проясняет, что не входит в сферу проекта.

Для проектов генеративного ИИ установление случая использования может помочь уменьшить размер модели, вычислительные потребности и потребление энергии, одновременно увеличивая точность за счёт сосредоточения на конкретных данных. Такой целенаправленный подход приводит к сокращению усилий и затрат на разработку.

Факторы, определяющие случай использования для генеративного ИИ, могут варьироваться в зависимости от проекта, однако несколько направляющих вопросов могут быть полезны:

- Требования к данным: Какие типы и объемы обучающих данных необходимы и доступны? Данные структурированы (хранилище данных) или неструктурированы (озеро данных)? Каковы ограничения? Как приложение будет обрабатывать данные — через пакетную обработку или потоковую? Какова частота обновлений модели? Обучение крупных языковых моделей (LLM) с нуля занимает много времени, поэтому, если для вашего приложения (например, в здравоохранении) важны актуальные данные, могут потребоваться альтернативные подходы для обеспечения их свежести.

- Требования к модели: Параметры такие, как размер модели, производительность и прозрачность результатов, критически важны при выборе подходящей модели. Производительность LLM может колебаться от миллиардов до триллионов параметров — Llama 2 от Meta предлагает версии от 7 до 70 миллиардов параметров, в то время как GPT-4 от OpenAI сообщает о 1.76 триллиона параметров. Более крупные модели, как правило, обеспечивают более высокую производительность, но меньшие модели могут лучше соответствовать вашим потребностям. Открытые модели позволяют углублённую настройку, тогда как закрытые предоставляют готовые решения с доступом через API. Настройка модели под ваши данные важна для приложений, требующих отслеживаемости, таких как генерация сводок финансовых отчетов для инвесторов, тогда как универсальная модель может подойти для креативных задач, таких как генерация рекламных текстов.

- Требования к приложению: Определите необходимые стандарты для точности, задержки, конфиденциальности и безопасности. Сколько одновременных пользователей должно поддерживать приложение? Как пользователи будут взаимодействовать с приложением? Например, способ работы вашей модели на устройстве с низкой задержкой или в облачной среде большого объёма существенно повлияет на решение о реализации.

- Вычислительные требования: После прояснения вышеперечисленных факторов определите необходимые вычислительные ресурсы. Необходимо ли вам параллелизировать обработку данных с помощью Modin*? Обоснованы ли ваши требования к донастройке и выводу в гибридной облачно-edge-среде? Даже если у вас есть таланты и данные для разработки генеративной ИИ модели с нуля, оцените, может ли ваш бюджет поддержать необходимую реконструкцию вычислительной инфраструктуры.

Эти соображения помогут направить обсуждения по определению и формированию требований к вашему проекту. Финансовые аспекты — охватывающие инженерные данные, первоначальные затраты на разработку и бизнес-модель, поддерживающую затраты на вывод — также диктуют стратегии для данных, обучения и внедрения.

Как технологии генеративного ИИ от Intel могут помочь

Intel предлагает гетерогенные аппаратные решения для ИИ, адаптированные к различным вычислительным нуждам. Для максимизации потенциала вашего оборудования Intel предоставляет оптимизированные версии популярных инструментов для анализа данных и полного цикла ИИ. Недавно Intel представила оптимизированную модель, которая заняла 1-е место среди моделей с 7 млрд параметров на открытой таблице лидеров LLM Hugging Face (по состоянию на ноябрь 2023 года). Эти ресурсы, а также возможности экосистемы разработчиков ИИ от Intel могут удовлетворить требования ваших приложений к точности, задержке и безопасности. Начните с сотен предобученных моделей, доступных на Hugging Face или GitHub, оптимизированных для оборудования Intel. Вы можете предварительно обработать данные с помощью инструментов Intel, таких как Modin, донастроить базовые модели с использованием таких инструментов, как Intel® Extension for Transformers или Hugging Face Optimum, и автоматизировать настройку модели с помощью SigOpt, основанных на оптимизациях, внедрённых в открытые ИИ-рамки, включая TensorFlow, PyTorch и DeepSpeed.

Примеры случаев использования генеративного ИИ

1. Обслуживание клиентов: Случай использования чат-бота

Чат-боты на основе LLM повышают эффективность обслуживания, предоставляя мгновенные ответы на часто задаваемые вопросы, позволяя представителям решать более сложные задачи. Универсальные LLM могут общаться на разных языках, но могут не обладать специфическими знаниями о бизнесе или «галлюцинировать» информацию уверенно, хотя на самом деле это не так. Дообучение обновляет модель постепенно, в то время как методы извлечения, такие как генерация с дополнением извлечения (RAG), извлекают актуальные данные из внешней базы данных, построенной на специфичных для бизнеса документах. Оба подхода приводят к контекстно-специфичным ответам и могут использовать доступные процессоры, такие как Intel® Xeon® Scalable.

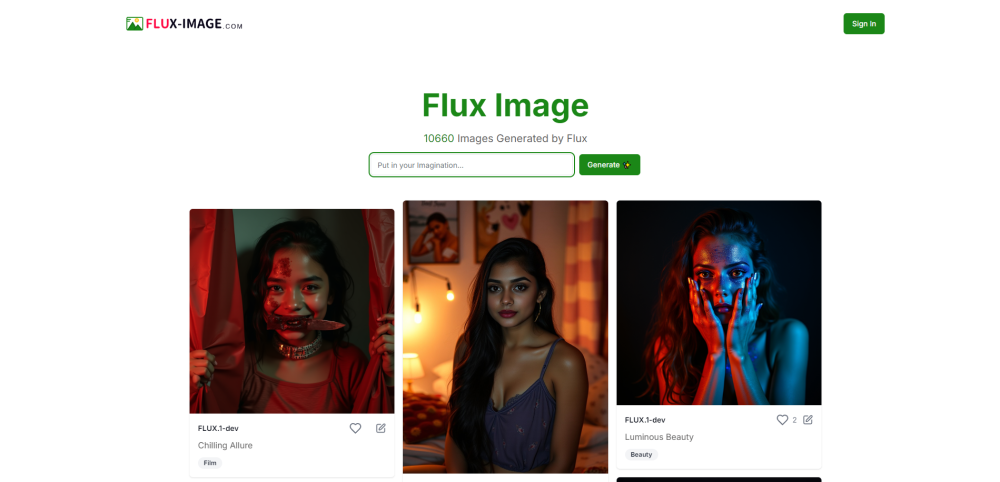

2. Ритейл: Случай использования виртуальной примерки

Генеративный ИИ может предложить иммерсивный опыт онлайн-шопинга, например, виртуальную примерку, повышая удовлетворенность клиентов и оптимизируя эффективность цепочки поставок. Это приложение основывается на генерации изображений и должно сосредоточиться на конкретной линии одежды. Настройка моделей изображений, таких как Stable Diffusion, может потребовать лишь ограниченное количество изображений, обработанных на CPU-платформах. Для обеспечения конфиденциальности клиентов изображения следует хранить локально, возможно, на устройствах потребителей.

3. Здравоохранение: Случай использования мониторинга пациентов

Сочетание генеративного ИИ с мониторингом пациентов в реальном времени может генерировать персонализированные отчёты и планы действий. Этот случай использования требует мультимодального ИИ для обработки различных типов входных данных и генерации отчётов. Обучение моделей в сфере здравоохранения вызывает опасения по поводу конфиденциальности, поэтому необходимо, чтобы данные о пациентах оставались у поставщиков. Федеративное обучение позволяет тренировать модель локально, не передавая чувствительные данные. Хотя локальный вывод предпочтителен, могут потребоваться гибридные решения, включающие компоненты как на edge, так и в облаке, возможным образом требующие оптимизации.

Как начать

Начните с определения вашего случая использования, используя предложенные выше направляющие вопросы для прояснения требований к данным, вычислениям, моделям и приложениям. Затем исследуйте соответствующие базовые модели, примеры реализации и ресурсы сообщества, доступные в экосистеме ИИ. Определите и примените методы донастройки и оптимизации, которые лучше всего подходят вашему проекту.

Понимание вычислительных потребностей может занять время, и они часто эволюционируют на протяжении всего проекта. Intel® Developer Cloud предлагает различные процессоры, графические процессоры и ускорители ИИ, чтобы помочь вам при начале разработки.

Наконец, чтобы облегчить переход между различными вычислительными платформами в процессе разработки и внедрения, выбирайте инструменты и фреймворки ИИ, которые являются открытыми, основанными на стандартных решениях и способны обеспечивать оптимальные показатели производительности на различных устройствах без необходимости обширных переписей кода.