OpenAI共同創辦人伊利亞·蘇茲科夫推出新公司,專注於安全超智能技術的開發

Most people like

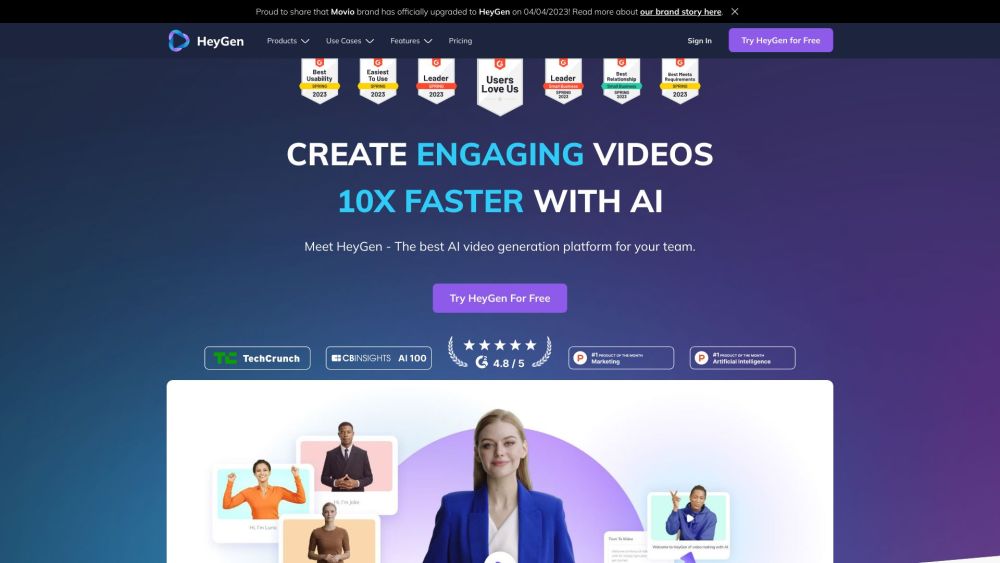

將AI生成的文本轉化為流暢、自然的語言,讓讀者產生共鳴。這一過程提升了可讀性和互動性,確保您的內容有效且真誠地傳達信息。通過專門技術,我們縮短了機械文本與真實人類表達之間的距離,優化您的內容,以便同時吸引觀眾和搜索引擎。

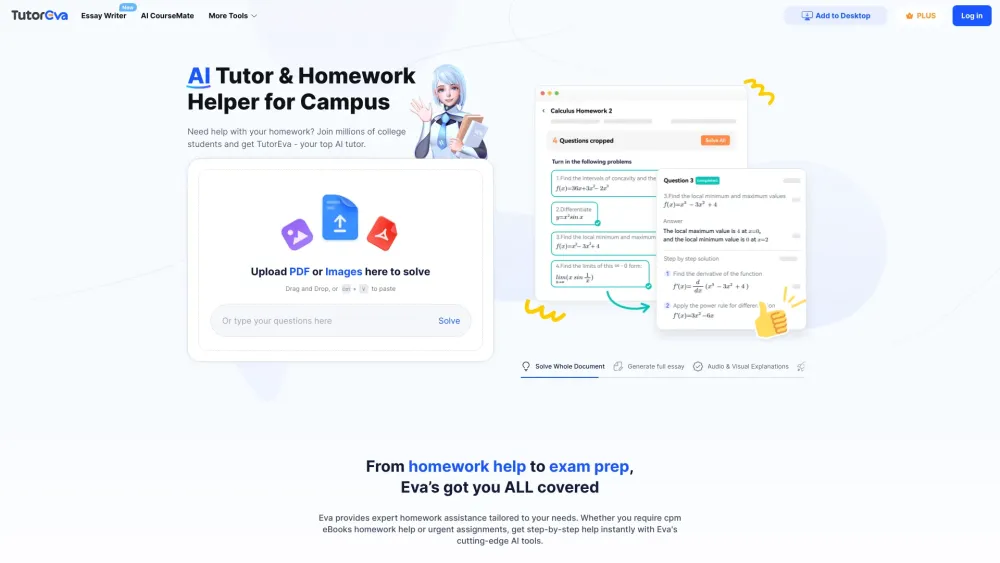

探索專為大學科目設計的終極 AI 學習工具。透過個性化的支持、高效的學習策略以及符合您學術需求的專屬資源,提升您的學習體驗。無論您是在攻克複雜概念還是準備考試,這款創新工具都能助您在教育旅程中邁向成功。

Find AI tools in YBX

Related Articles

Refresh Articles