蘋果推出 MM1.5:價值300億美元的多模態 AI 模型,具備影像識別與自然語言理解功能

Most people like

透過我們的AI驅動工具,將您的創意轉化為引人入勝的影片,該工具能無縫地將文字與圖片轉換為高品質的視覺內容。無論您是在製作吸引人的行銷素材或令人驚豔的社交媒體貼文,我們的創新解決方案簡化了影片製作過程,使其對每個人都易於取得。探索如何輕鬆提升您的故事講述技巧,並吸引您的觀眾。

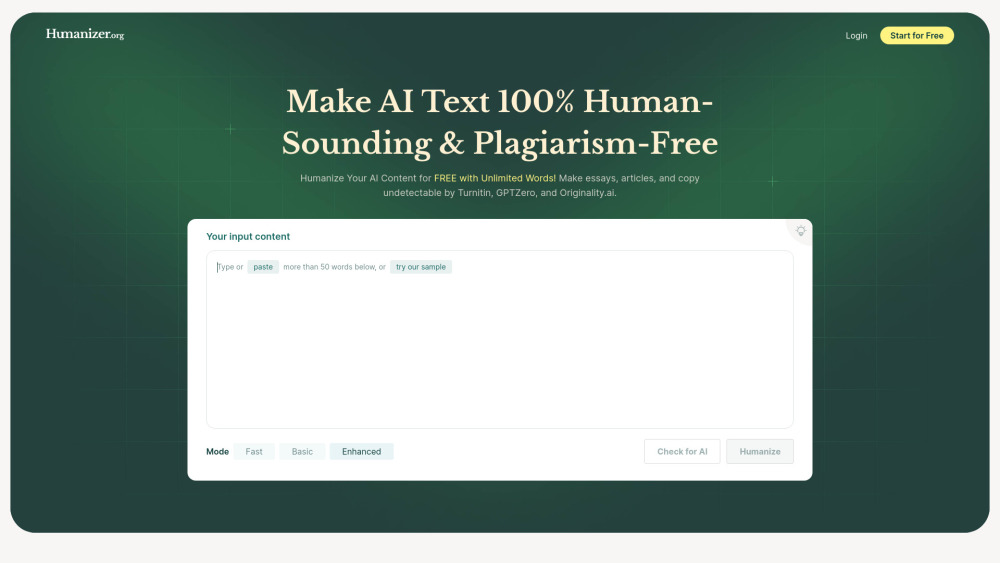

在當今的數位環境中,迅速創造引人注目的內容至關重要。探索我們專為將文本轉化為引人入勝的類人內容而設計的AI驅動工具。憑藉先進的算法和自然語言處理技術,您可以提升寫作水平,確保與受眾產生共鳴,同時節省時間和精力。無論您是在撰寫文章、部落格文章,還是社群媒體更新,釋放AI的潛力,輕鬆增強您的內容。

歡迎來到 RightBlogger,一個專為部落客設計的創新 AI 驅動平臺。擁有超過 40 種強大的工具,您可以輕鬆地在比以往更短的時間內創作高品質內容。今天就與 RightBlogger 一起提升您的部落格體驗和生產力!

Find AI tools in YBX

Related Articles

Refresh Articles