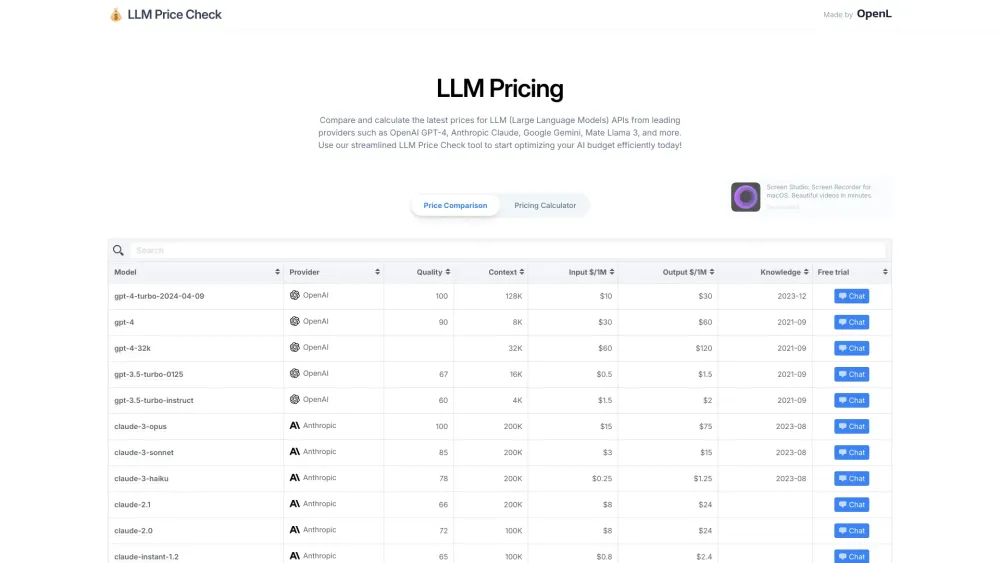

大型語言模型如ChatGPT和Llama-2,以其龐大的記憶體和計算需求而聞名,這使得其運行成本高昂。即使是略微減小其規模,也有可能帶來顯著的成本節省。

為了解決這一挑戰,蘇黎世聯邦理工學院的研究人員提出了一種創新的變壓器(transformer)版本,這種深度學習架構是語言模型的基礎。這一新設計顯著縮小了變壓器的尺寸,同時保持準確性並提升推理速度,顯示出創建更高效語言模型的前景。

了解變壓器區塊

語言模型依賴於變壓器區塊,這些是一致的單元,專為處理序列數據(如文本段落)設計。

經典的變壓器區塊由兩個主要組件組成:注意機制和多層感知器(MLP)。注意機制會有選擇性地突顯輸入數據的部分(如句子中的單詞),捕捉它們之間的上下文和重要性。這種能力使得模型能夠理解即使在文本中距離遙遠的詞之間的關係。

在注意機制之後,MLP—一個較小的神經網絡—進一步精煉突出信息,將其轉化為捕捉複雜關係的更精緻表示。

額外的組件如殘差連接和正則化層增強了學習效果,解決了深度神經網絡中的常見挑戰。隨著這些變壓器區塊的堆疊形成語言模型,它們識別複雜關係的能力也隨之增強,使得現代語言模型能夠執行高級任務。儘管它們的影響革命性,但變壓器區塊的基本設計自誕生以來大致保持不變。

提高變壓器效率

蘇黎世聯邦理工學院的研究人員表示:「考慮到如今訓練和部署大型變壓器模型的高昂成本,任何在變壓器架構訓練和推理管道中獲得的效率提升都代表著顯著的潛在節省。」他們認為,通過去除非關鍵組件來簡化變壓器區塊,可以減少參數數量並提升模型吞吐量。

他們的實驗顯示,簡化變壓器區塊不會妨礙訓練速度或效能。傳統變壓器模型利用多個注意頭,每個頭都有自己的鍵(K)、查詢(Q)和值(V)參數,這些共同促進輸入標記關係的映射。研究人員發現,去除V參數及相關的投影層並未降低效果。此外,他們還去除了通常防止“梯度消失”問題的跳接連接。

新變壓器區塊設計

新設計的變壓器區塊同時處理注意頭和MLP,甩掉了傳統的序列處理方式。為了平衡參數的減少,研究人員調整了其他非可學習參數,改進了其訓練方法,並進行了架構微調。這些創新共同保留了模型的學習能力,儘管其框架更為簡練。

測試改進的變壓器區塊

蘇黎世聯邦理工學院團隊在不同的語言模型深度中評估了他們的緊湊變壓器區塊。他們在不損失準確性的情況下,成功地將傳統變壓器的大小減少約16%,同時也獲得了更快的推理時間。例如,將此架構應用於一個大型模型如GPT-3(1750億個參數)時,可能節省約50 GB的記憶體。

“我們的簡化模型不僅訓練更快,還能更好地利用更大深度所帶來的額外容量,”研究人員指出。雖然這種技術在小規模上已顯示出有效性,但對於大型模型的應用仍待深入探索。進一步增強的潛力,例如為此精簡架構定制AI處理器,可能會顯著放大其影響。

研究人員總結道:「我們相信,我們的工作可以促使更簡單的架構在實際中得到應用,彌合深度學習中的理論與實踐之間的差距,並降低與大型變壓器模型相關的成本。」