Aufkommende Open-Source-KI-Visionsmodelle stellen eine Herausforderung für ChatGPT dar: Wichtige Aspekte zu beachten

Most people like

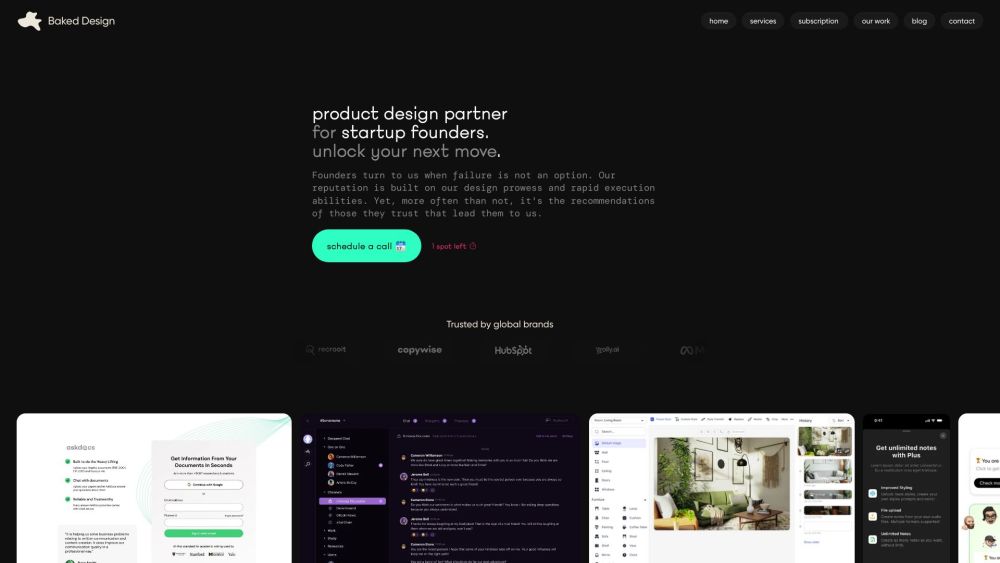

Sind Sie ein Startup, das seine Marke mit herausragendem Design aufwerten möchte? Ein Design-Abonnement bietet Ihnen laufenden Zugang zu professionellen Kreativdiensten, die auf Ihre sich entwickelnden Bedürfnisse zugeschnitten sind. Dieser innovative Ansatz spart nicht nur Zeit und Geld, sondern sorgt auch dafür, dass Ihre Marke in der heutigen dynamischen Marktwelt frisch und wettbewerbsfähig bleibt. Entdecken Sie, wie ein Design-Abonnement der Wendepunkt sein kann, den Ihr Startup benötigt, um Ihr Publikum visuell zu fesseln und Wachstum zu fördern.

Text Neuschreiben ist ein innovatives Werkzeug, das deine Texte in Sekundenschnelle verwandelt und das Umformulieren von Inhalten schnell und effizient gestaltet.

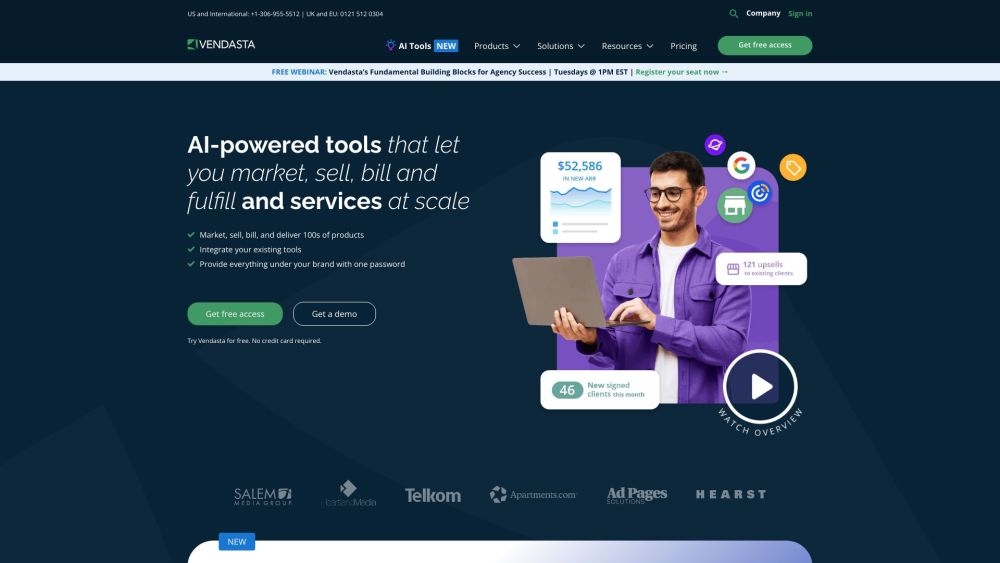

Wir präsentieren eine KI-gesteuerte SaaS-Plattform, die entwickelt wurde, um den Verkauf Ihrer digitalen Produkte effektiv zu steigern und auszubauen.

Präsentation unserer innovativen, KI-gestützten Personal-Training-App, die darauf ausgelegt ist, Ihr Fitnesserlebnis zu Hause oder im Fitnessstudio zu optimieren. Dieses hochmoderne Tool passt die Trainingspläne an Ihre individuellen Ziele an und stellt sicher, dass Sie aus jeder Einheit das Beste herausholen. Egal, ob Sie Anfänger oder erfahrener Sportler sind, unsere App passt sich Ihren Bedürfnissen an und bietet maßgeschneiderte Routinen, die Ergebnisse maximieren und Sie motivieren, auf Kurs zu bleiben. Machen Sie sich bereit für eine transformative Fitnessreise, die Ihnen direkt zur Verfügung steht!

Find AI tools in YBX

Related Articles

Refresh Articles