Cohere stellt Aya 23 vor: Ein Open-Weights-AI-Modell, das über 20 Sprachen unterstützt.

Most people like

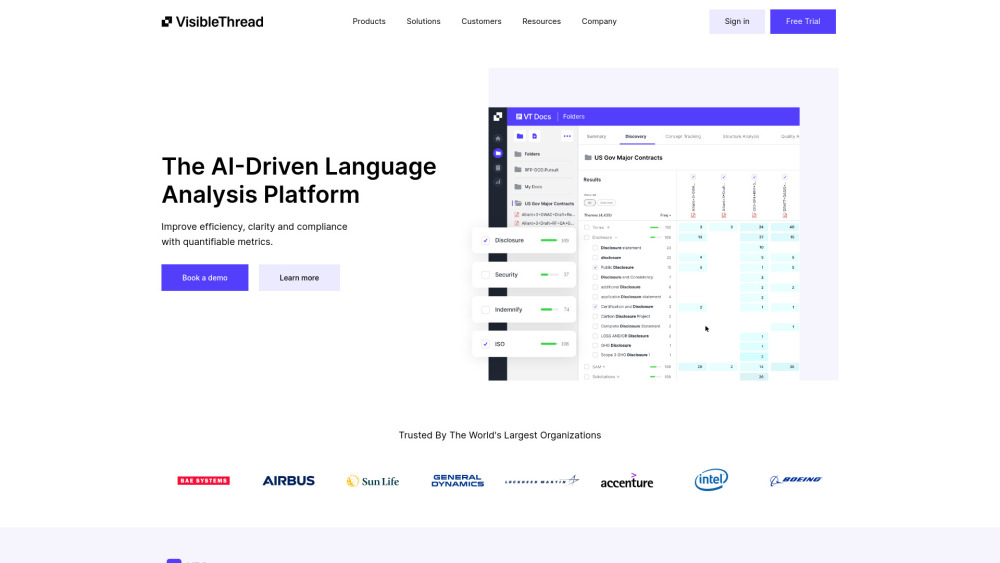

In der heutigen, schnelllebigen Geschäftswelt ist effektive Kommunikation entscheidend. Unsere KI-gesteuerte Plattform revolutioniert Ihren Ansatz beim Schreiben im Geschäftsbereich und bietet Werkzeuge, die Ihren Schreibprozess optimieren und gleichzeitig Klarheit und Engagement verbessern. Egal, ob Sie E-Mails, Berichte oder Präsentationen verfassen, diese Plattform unterstützt Sie dabei, überzeugende Nachrichten zu erstellen, die bei Ihrem Publikum Anklang finden. Entfalten Sie Ihr Schreibpotenzial mit unserer innovativen Technologie, die darauf ausgelegt ist, Ihre professionelle Kommunikation zu verbessern.

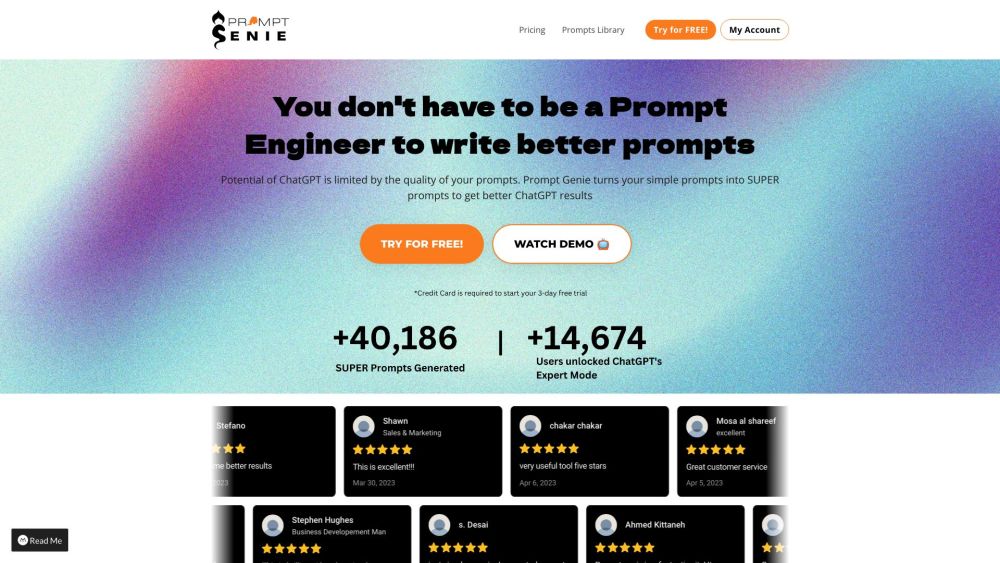

Verbessern Sie Ihr ChatGPT-Erlebnis mit Prompt Genie, einem KI-gestützten Tool, das darauf abzielt, Ihre Eingabeaufforderungen zu optimieren und außergewöhnliche Ergebnisse zu liefern. Egal, ob Sie Ihre Fragen verfeinern oder kreativere Antworten generieren möchten, Prompt Genie kann Ihnen dabei helfen, das volle Potenzial von ChatGPT für optimale Leistung auszuschöpfen.

Entdecken Sie, wie Sie Feng Shui-Energie für ein harmonisches und erfülltes Leben nutzen können. Durch das Verständnis und die Anwendung dieser Prinzipien können Sie Ihren Wohnraum in eine Quelle der Ruhe und positiven Energie verwandeln.

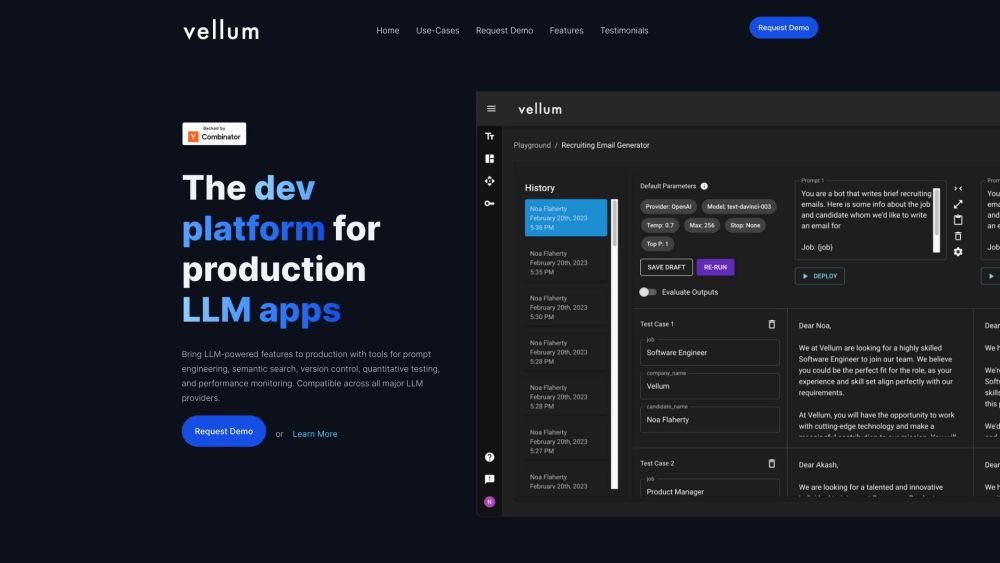

Wir präsentieren eine hochmoderne Entwicklungsplattform, die speziell für die Erstellung von Anwendungen mit großen Sprachmodellen (LLM) entwickelt wurde. Diese innovative Plattform optimiert den Entwicklungsprozess und bietet Entwicklern die benötigten Werkzeuge und Ressourcen, um leistungsstarke LLM-gesteuerte Lösungen effizient zu erstellen, zu testen und bereitzustellen. Egal, ob Sie ein erfahrener Entwickler sind oder gerade erst anfangen, unsere Plattform bietet die Flexibilität und Unterstützung, um Ihre KI-Ideen zum Leben zu erwecken. Schließen Sie sich uns an, um die Entwicklung von LLM-Anwendungen zu revolutionieren!

Find AI tools in YBX

Related Articles

Refresh Articles