Dell Technologies verbessert die AI-Fabrik mit Nvidia und erweitert die Zusammenarbeit mit Hugging Face, Meta und Microsoft.

Most people like

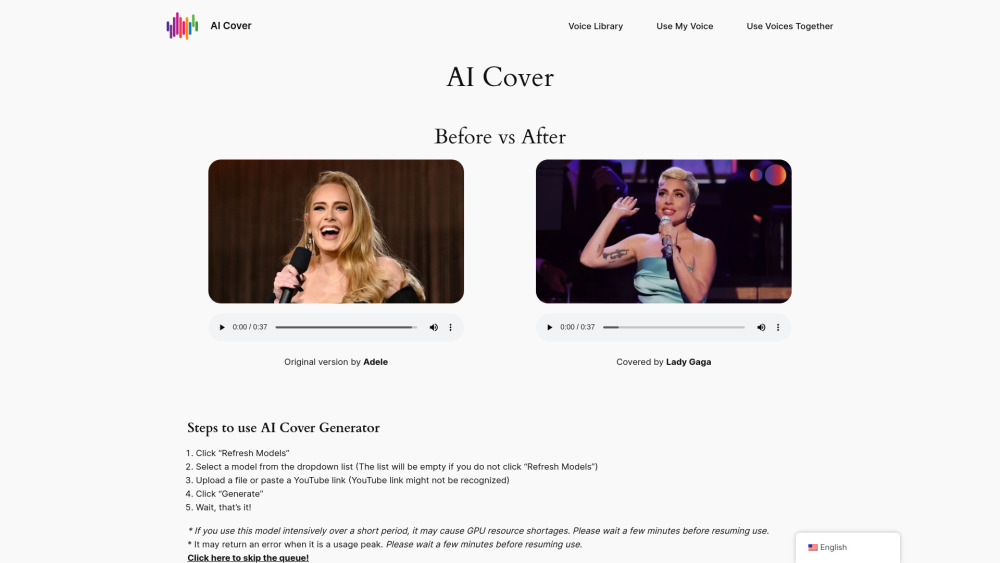

Wir stellen ein innovatives KI-Tool vor, das den Prozess der Erstellung hochwertiger Songcover mühelos vereinfacht. Egal, ob Sie ein erfahrener Musiker oder ein leidenschaftlicher Anfänger sind, unsere Plattform ermöglicht es Ihnen, beeindruckende Cover mit Leichtigkeit zu produzieren.

Entdecken Sie das ultimative, KI-gesteuerte Schreibtool, das für nahtlose Textgenerierung entwickelt wurde. Verwandeln Sie Ihren Schreibprozess mühelos und effizient, während Ihnen dieses innovative Tool hilft, hochwertige Inhalte spielend leicht zu erstellen. Lassen Sie fortschrittliche KI-Technologie Ihre Kreativität und Produktivität steigern, sodass Schreibaufgaben schneller und angenehmer werden.

In der heutigen schnelllebigen digitalen Welt spielen Kundenservicemitarbeiter eine entscheidende Rolle für die Kundenzufriedenheit. Das Bewältigen komplexer Anfragen kann jedoch ohne unmittelbare Unterstützung eine Herausforderung darstellen. Unsere Echtzeit-Begleitplattform befähigt Contact Center, indem sie den Mitarbeitern sofortige, kontextbezogene Hilfe bietet und sicherstellt, dass sie präzise und zeitgerechte Antworten liefern. Durch die Nutzung fortschrittlicher Analysen und KI-gestützter Erkenntnisse verbessert diese Plattform die Leistung der Mitarbeiter, optimiert die Kundeninteraktionen und erhöht letztlich die Produktivität Ihres Contact Centers. Erleben Sie noch heute die Zukunft des Kundenservice!

Nutzen Sie die Kraft der KI-Bildverbesserung, um Ihre Fotos mühelos durch fortgeschrittenes Rauschen reduzieren, effektives Entschwommen und nahtloses Hochskalieren zu optimieren. Diese innovative Technologie schärft nicht nur Ihre Bilder, sondern stellt auch deren Qualität wieder her, wodurch sie visuell fesselnd werden. Entdecken Sie, wie KI Ihr fotografisches Erlebnis verwandeln kann, indem sie die Klarheit und Detailtreue jedes Shots erhöht.

Find AI tools in YBX

Related Articles

Refresh Articles