Ex-Leiter der Superalignment bei OpenAI kritisiert das Unternehmen: „Sicherheitskultur und Prozesse wurden vernachlässigt“

Most people like

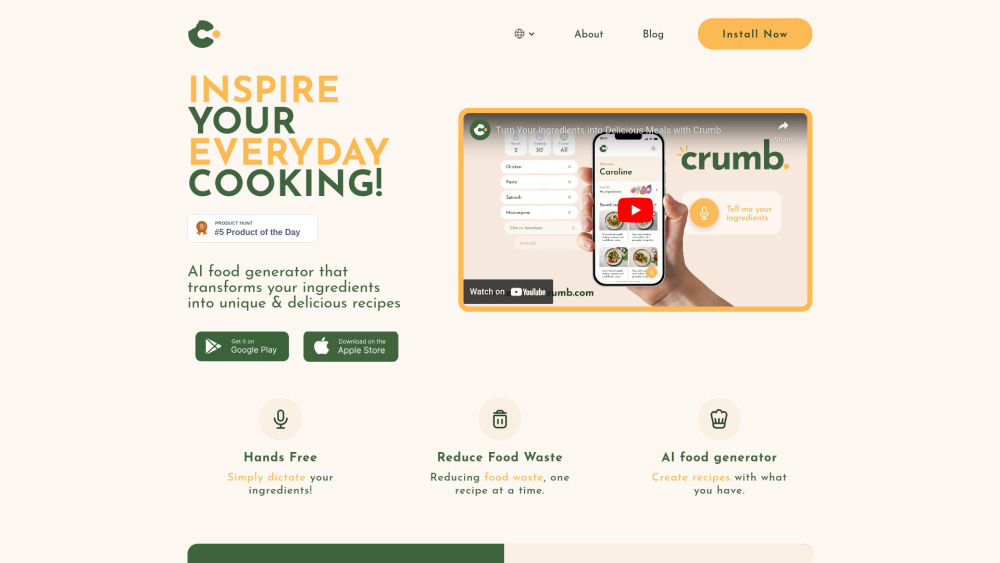

Entdecken Sie unseren KI-Rezeptgenerator, der einzigartige Gerichte basierend auf den Zutaten erstellt, die Sie zur Verfügung haben. Entfalten Sie kulinarische Kreativität und verwandeln Sie Ihre Vorratskammer in eine Gourmetküche mit personalisierten Rezepten, die Ihnen jederzeit zur Verfügung stehen!

Erstellen Sie mühelos No-Code-Chatbots

Möchten Sie einen Chatbot entwickeln, verfügen jedoch nicht über Programmierkenntnisse? Entdecken Sie die Möglichkeiten von No-Code-Plattformen, die es Ihnen ermöglichen, anspruchsvolle Chatbots ganz einfach zu erstellen. In diesem Leitfaden zeigen wir Ihnen, wie Sie Chatbots erstellen können, ohne eine einzige Codezeile zu schreiben, und machen die Entwicklung von Chatbots für jeden zugänglich. Entfalten Sie das Potenzial automatisierter Gespräche und steigern Sie noch heute das Nutzerengagement!

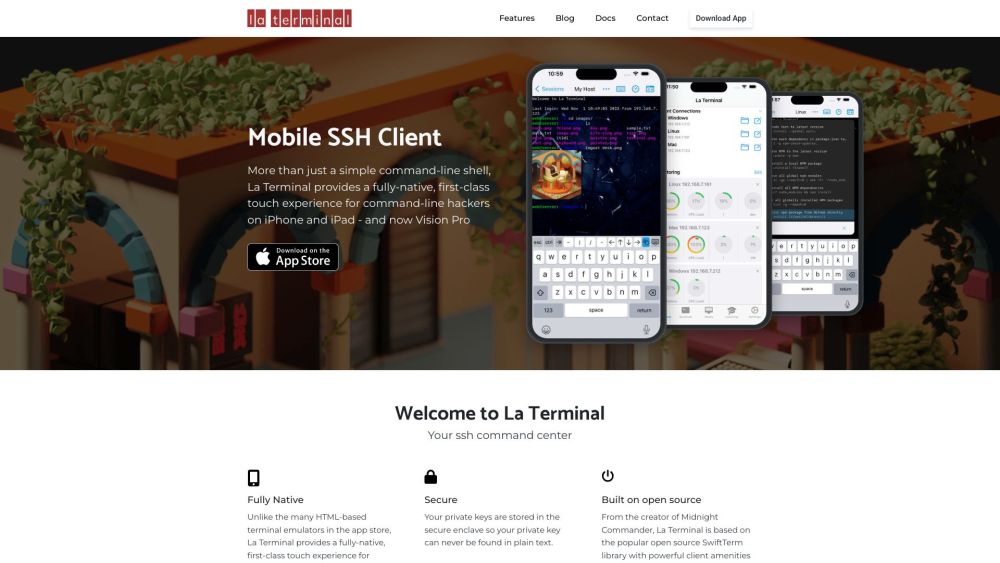

Einführung eines vollständig nativen SSH-Terminals für verbesserte räumliche Computeranwendungen

Entfalten Sie das volle Potenzial der räumlichen Computeranwendungen mit unserem vollständig nativen SSH-Terminal. Erleben Sie nahtlose Integration und gesteigerte Produktivität, während Sie mühelos durch Ihre Remote-Server navigieren und diese verwalten. Unser Terminal ist für optimale Leistung konzipiert und stellt sicher, dass Sie sicher und effizient verbinden, während Sie Ihren Arbeitsablauf maximieren. Egal, ob Sie Entwickler, Systemadministrator oder Technikbegeisterter sind, dieses Tool ist Ihr Schlüssel zum mühelosen und präzisen Meistern räumlicher Computeranwendungen.

Runway entwickelt innovative KI-Systeme, die speziell auf kreative Werkzeuge in der Kunst- und Unterhaltungsbranche zugeschnitten sind. Durch den Einsatz fortschrittlicher Technologie ermöglicht Runway Künstlern und Schöpfern, ihre Arbeit zu verbessern und neue Möglichkeiten in ihren kreativen Bestrebungen zu erschließen.

Find AI tools in YBX

Related Articles

Refresh Articles