Hat das Superalignment-Team von OpenAI nach zwei großen Abgängen Schwierigkeiten zu überleben?

Most people like

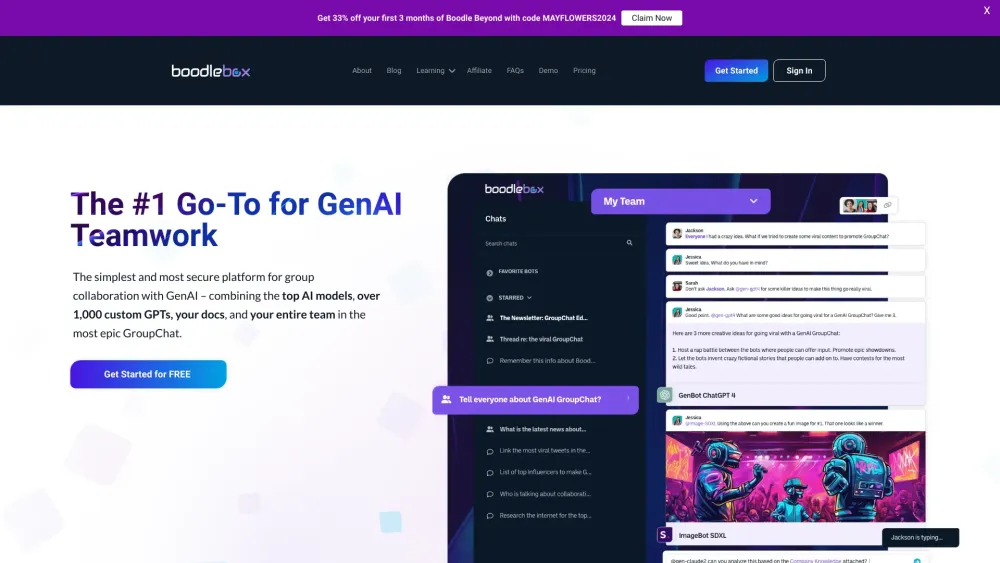

Entdecken Sie die führende Plattform für sichere Zusammenarbeit im Bereich Generative AI (GenAI).

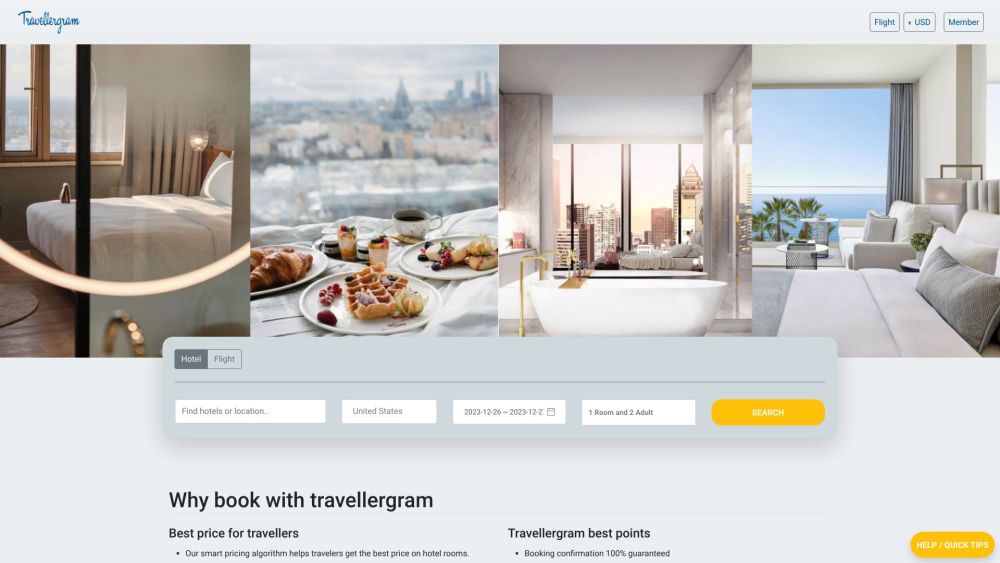

Entdecken Sie unschlagbare Preise für Hotels, Flüge und Reisen mit dem hochmodernen Algorithmus von Travellergram. Erleben Sie eine nahtlose Reiseplanung und maximieren Sie Ihr Budget.

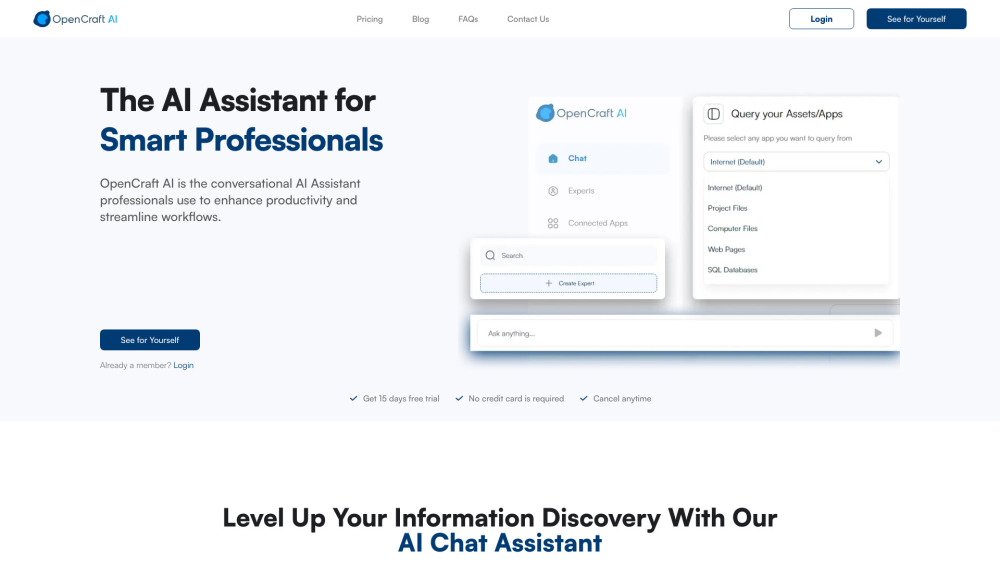

Entfesseln Sie die Kraft eines KI-Assistenten, der speziell für Fachkräfte entwickelt wurde, die ihre Produktivität steigern und Arbeitsabläufe optimieren möchten. Dieses innovative Tool vereinfacht Aufgaben, sodass Sie sich auf das Wesentliche in Ihrem Arbeitsalltag konzentrieren können. Erleben Sie ein neues Maß an Effizienz mit einem spezialisierten Assistenten an Ihrer Seite.

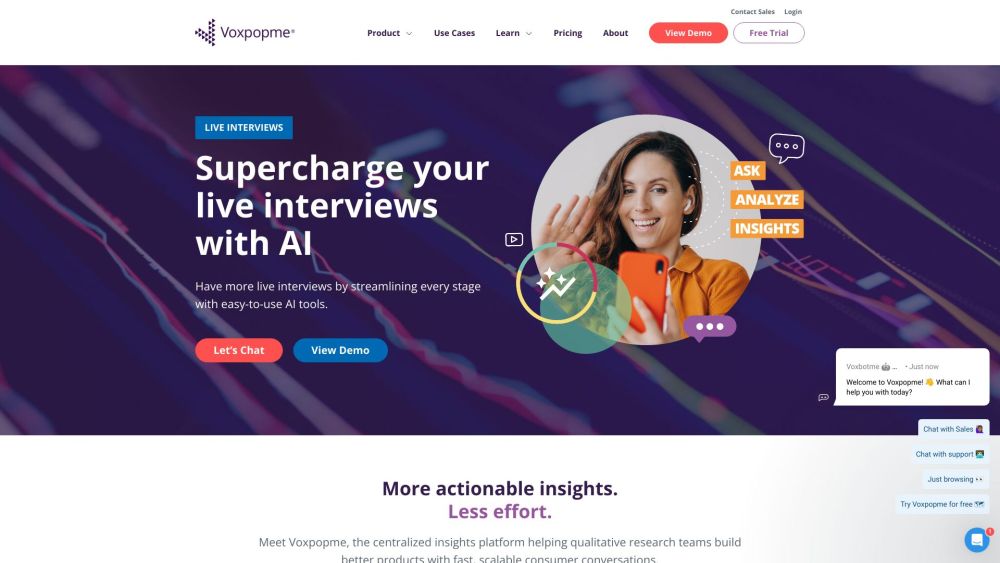

Die zentrale Insights-Plattform dient als umfassendes Zentrum zur Aggregation und Analyse wichtiger Daten aus verschiedenen Quellen. Durch die Bündelung von Informationen an einem zentralen Ort ermöglicht sie es Organisationen, schnell und effizient fundierte Entscheidungen zu treffen. Diese Plattform fördert die Zusammenarbeit zwischen Teams, verbessert die Datenzugänglichkeit und treibt strategische Initiativen voran, sodass umsetzbare Erkenntnisse jederzeit verfügbar sind. Entdecken Sie, wie unsere zentrale Insights-Plattform das Datenmanagement revolutioniert und Ihre organisatorischen Arbeitsabläufe transformiert.

Find AI tools in YBX

Related Articles

Refresh Articles