Meta AI präsentiert ein kompaktes Sprachmodell, das für mobile Geräte optimiert ist.

Most people like

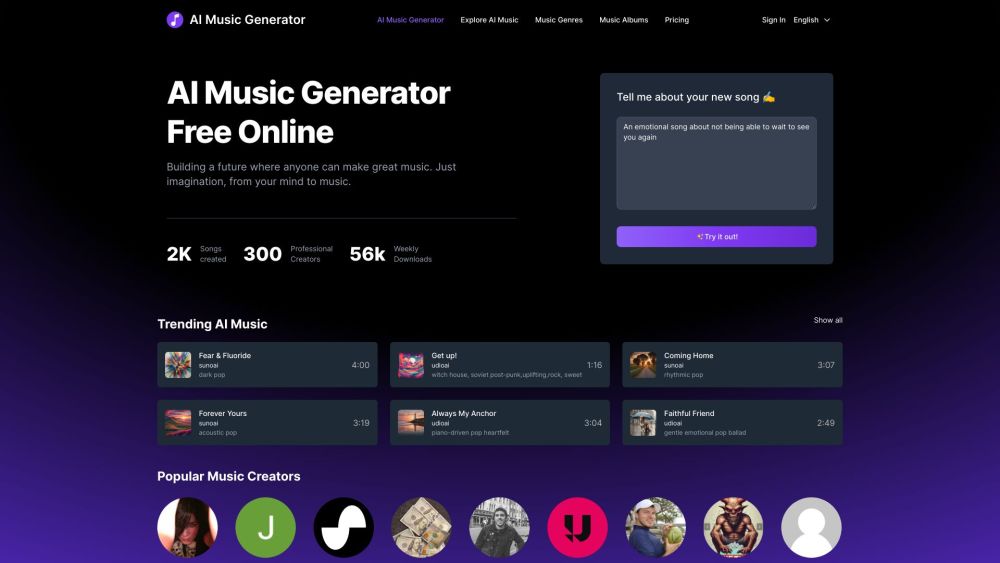

Entfessele deine musikalische Kreativität mit unserer innovativen Plattform, die es dir ermöglicht, einzigartige Songs mit KI-Technologie zu generieren – und das völlig kostenlos! Egal, ob du ein aufstrebender Musiker bist oder einfach die Kunst des Songwritings erkunden möchtest, unser Tool bietet eine einfache und unterhaltsame Möglichkeit, personalisierte Musik zu kreieren, die deinem Stil entspricht. Beginne noch heute deine musikalische Reise und entdecke die grenzenlosen Möglichkeiten des KI-gestützten Songwritings!

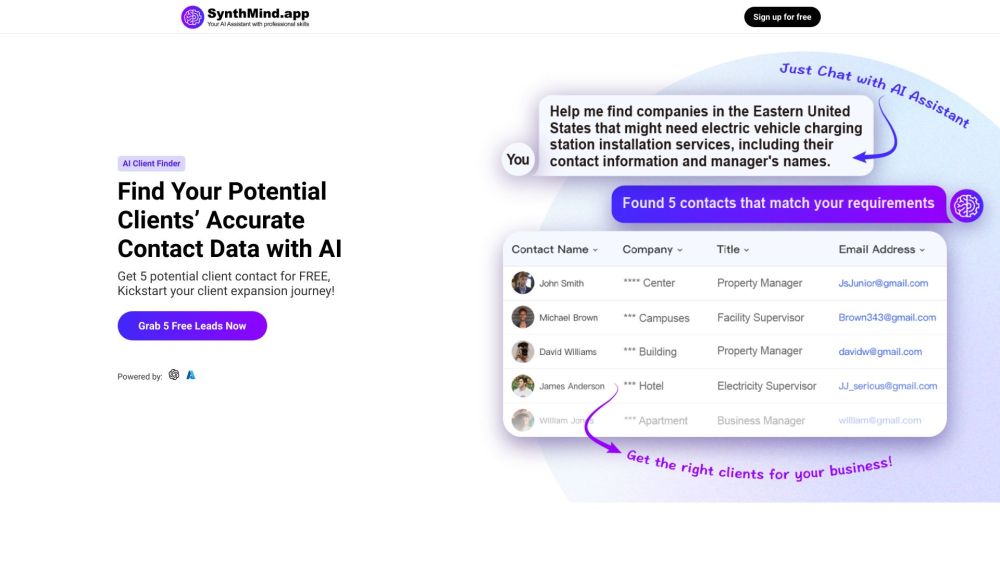

Entdecken Sie unser KI-gestütztes Tool zur Lead-Generierung, das potenzielle Kunden mühelos identifiziert und ihre Kontaktdaten bereitstellt. Diese innovative Lösung optimiert Ihren Outreach-Prozess und unterstützt Sie dabei, effektiver denn je mit Interessenten in Kontakt zu treten.

Entdecken Sie die bemerkenswerte Vielseitigkeit unseres fortschrittlichen LLM, das mit einzigartigen Fähigkeiten entwickelt wurde, um Ihre Projekte zu unterstützen und Ihre Ideen in die Realität umzusetzen.

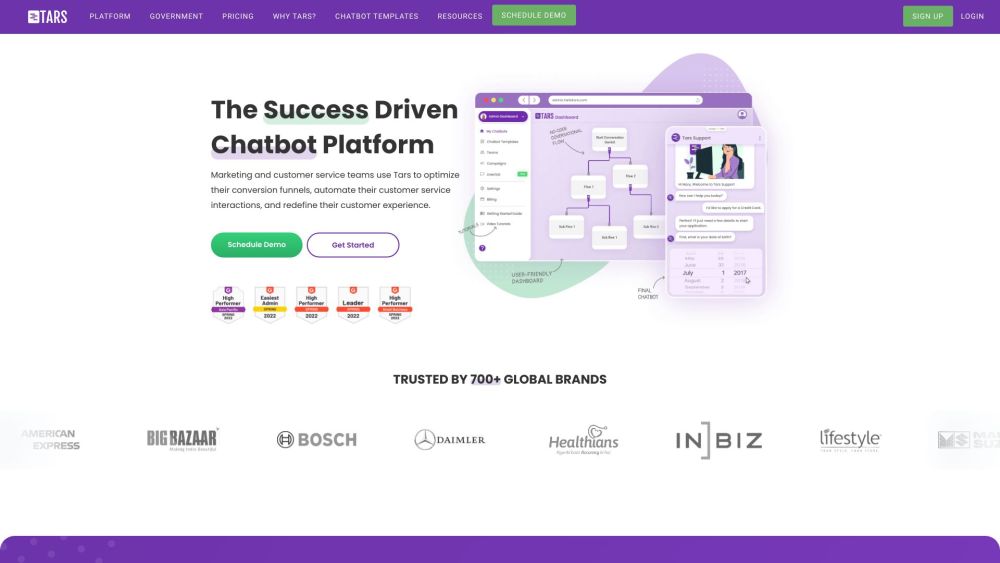

Tars ist eine innovative Plattform, die entwickelt wurde, um das Kundenengagement und den Support mit Hilfe fortschrittlicher KI-gestützter Chatbots zu steigern. Durch die Optimierung der Interaktionen unterstützt Tars Unternehmen dabei, personalisierte Hilfe anzubieten und die Benutzererfahrung zu verbessern.

Find AI tools in YBX

Related Articles

Refresh Articles