Heute hat Microsofts Azure AI-Team ein neues Vision-Foundation-Modell namens Florence-2 auf Hugging Face veröffentlicht. Dieses Modell, das unter einer großzügigen MIT-Lizenz verfügbar ist, besticht durch seine Leistung in verschiedenen Vision- und Vision-Sprach-Aufgaben über ein einheitliches, prompt-basiertes Framework. Erhältlich in zwei Größen – 232M und 771M Parametern – zeigt es herausragende Fähigkeiten in Aufgaben wie Bildbeschriftung, Objekterkennung, visuelles Verankern und Segmentierung und übertrifft oft andere große Vision-Modelle.

Während die reale Leistung von Florence-2 noch bewertet werden muss, zielt es darauf ab, Unternehmen eine kohärente Strategie für diverse Vision-Anwendungen zu bieten. Dies reduziert die Notwendigkeit für mehrere auf bestimmte Aufgaben zugeschnittene Modelle, die oft die Funktionalität einschränken und umfangreiche Feinabstimmungen erfordern.

Was macht Florence-2 besonders?

Große Sprachmodelle (LLMs) spielen derzeit eine entscheidende Rolle im Betrieb von Unternehmen, indem sie Dienstleistungen wie Zusammenfassungen, Erstellung von Marketingtexten und Kundensupport anbieten. Ihre Anpassungsfähigkeit über verschiedene Bereiche hinweg ist bemerkenswert. Das wirft die Frage auf: Können Vision-Modelle, die typischerweise für spezifische Aufgaben entwickelt wurden, ähnliche Vielseitigkeit erreichen?

Vision-Aufgaben sind von Natur aus komplexer als textbasierte natürliche Sprachverarbeitung (NLP), da sie anspruchsvolle Wahrnehmungsfähigkeiten erfordern. Ein universelles Modell muss räumliche Daten auf verschiedenen Ebenen verstehen – von breiten Konzepten wie Objektstandorten bis hin zu detaillierten Pixelinformationen und hochrangigen Beschriftungen.

Microsoft identifizierte zwei Hauptprobleme bei der Erstellung eines einheitlichen Vision-Modells: das Fehlen umfangreich annotierter visueller Datensätze und die Notwendigkeit eines einheitlichen Vortrainingsframeworks, das räumliche Hierarchien und semantische Granularität integrieren kann.

Um diese Herausforderungen zu überwinden, entwickelte Microsoft einen visuellen Datensatz namens FLD-5B, der 5,4 Milliarden Annotationen für 126 Millionen Bilder umfasst, die von allgemeinen Beschreibungen bis hin zu spezifischen Objektregionen reichen. Dieser Datensatz trainierte Florence-2, das eine Sequenz-zu-Sequenz-Architektur nutzt, die einen Bildencoder mit einem multimodalen Encoder-Decoder kombiniert. Dieses Design ermöglicht es Florence-2, verschiedene Vision-Aufgaben ohne erforderliche spezifische Anpassungen der Architektur zu bewältigen.

„Alle Annotationen im FLD-5B-Datensatz sind in standardisierte Textausgaben überführt, was einen einheitlichen Multi-Task-Lernansatz mit konsistenter Optimierung durch eine einheitliche Verlustfunktion ermöglicht“, erläuterten die Forscher in ihrer Veröffentlichung. „Das Ergebnis ist ein vielseitiges Vision-Foundation-Modell, das mehrere Aufgaben innerhalb eines einzigen Rahmens handhaben kann und von einem konsistenten Satz von Parametern gesteuert wird. Die Aktivierung der Aufgaben erfolgt durch textuelle Eingabeaufforderungen, ähnlich wie bei großen Sprachmodellen.“

Leistung, die größere Modelle übertrifft

Florence-2 führt ein breites Spektrum an Aufgaben – wie Objekterkennung, Bildbeschriftung, visuelles Verankern und visuelles Fragenbeantworten – effektiv aus, wenn es mit Bild- und Texteingaben versorgt wird. Bemerkenswert ist, dass es Ergebnisse erzielt, die mit vielen größeren Modellen vergleichbar sind oder diese übertreffen.

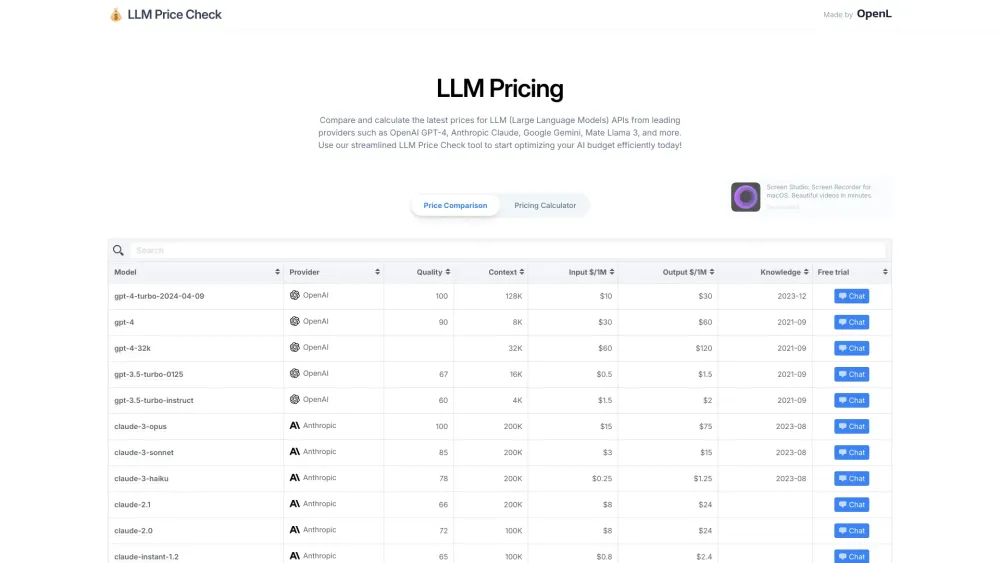

Zum Beispiel übertrafen sowohl die 232M- als auch die 771M-Versionen von Florence-2 in Zero-Shot-Beschriftungstests auf dem COCO-Datensatz das 80B-Parameter-Flamingo-Modell von DeepMind mit Punktzahlen von 133 und 135,6. Sie übertrafen ebenfalls Microsofts eigenes Kosmos-2-Modell, das auf visuelles Verankern spezialisiert ist.

Wenn Florence-2 mit öffentlich annotierten Daten feinabgestimmt wird, konkurriert es eng mit größeren Spezialmodellen in Aufgaben wie visuellem Fragenbeantworten. „Das vortrainierte Backbone von Florence-2 verbessert die Leistung bei nachgelagerten Aufgaben, wie COCO-Objekterkennung und Instanzsegmentierung, und ADE20K-semantische Segmentierung, übertrifft sowohl überwachte als auch selbstüberwachte Modelle“, bemerkten die Forscher. „Im Vergleich zu vortrainierten Modellen auf ImageNet verbessert unseres die Trainingseffizienz um das 4-Fache und steigert die Leistung um 6,9, 5,5 und 5,9 Punkte auf den COCO- und ADE20K-Datensätzen.“

Derzeit sind sowohl vortrainierte als auch feinabgestimmte Versionen von Florence-2 (232M und 771M) unter der MIT-Lizenz auf Hugging Face verfügbar, was uneingeschränkte kommerzielle und private Nutzung ermöglicht. Es wird spannend sein zu sehen, wie Entwickler Florence-2 nutzen, um die Notwendigkeit separater Vision-Modelle für verschiedene Aufgaben zu beseitigen. Diese kompakten, aufgabenagnostischen Modelle können die Entwicklung optimieren und die Rechenkosten erheblich senken.