Nvidias NeMo nutzt generative KI für innovative Design von Halbleiterchips.

Most people like

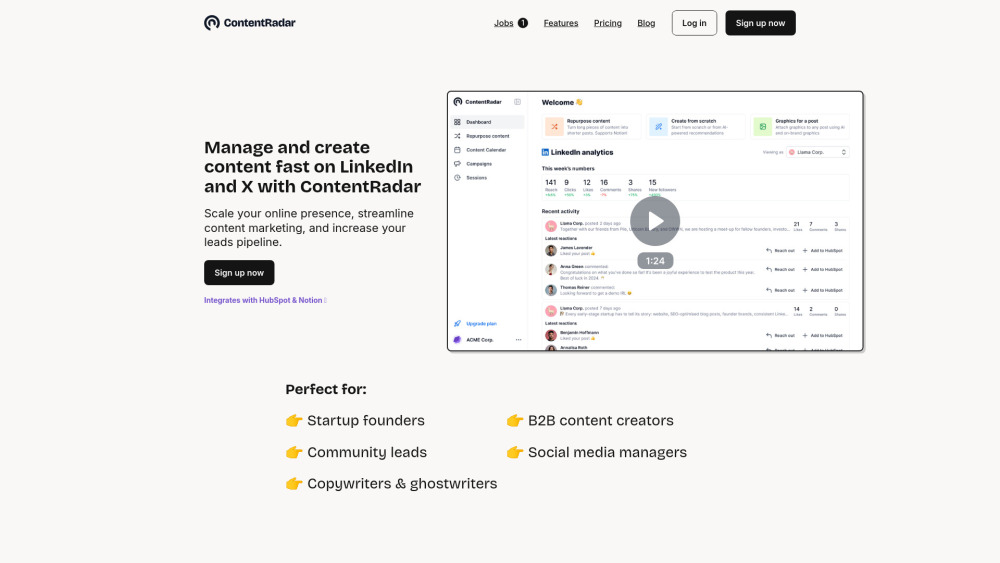

Optimieren Sie Ihre Social-Media-Strategie mit unserem KI-gesteuerten Content-Management-Arbeitsbereich, der speziell für LinkedIn und X entwickelt wurde. Vereinfachen Sie die Erstellung von Beiträgen, steigern Sie die Interaktion mit Ihrem Publikum und optimieren Sie Ihren Content-Planungsprozess – alles mit der Kraft der künstlichen Intelligenz. Verwandeln Sie Ihre Online-Präsenz und maximieren Sie mühelos Ihr Networking-Potenzial!

Ein hochmodernes Sprachmodell, das Texte erstellt, die von menschlichen Schriftstücken nicht zu unterscheiden sind. Diese fortschrittliche Technologie verbessert die Inhaltserstellung und liefert mühelos qualitativ hochwertiges, ansprechendes schriftliches Material.

Präsentation unseres hochmodernen KI-Autors, der plagiatfreie Inhalte erstellt, die unentdeckt bleiben. Erleben Sie die Kraft fortschrittlicher Technologie, die Originalität und Kreativität in jedem Text garantiert und gleichzeitig Ihre einzigartigen Schreibbedürfnisse erfüllt und Ihre Online-Präsenz verbessert. Entdecken Sie, wie unser undetectable KI-Autor Ihre Content-Strategie mühelos aufwerten kann.

In der heutigen schnelllebigen digitalen Landschaft spielt eine Wissensaustauschplattform eine entscheidende Rolle bei der Nutzung kollektiver Intelligenz. Indem sie einen zentralen Raum bieten, in dem Einzelpersonen und Organisationen Ideen und Ressourcen austauschen können, fördern diese Plattformen Zusammenarbeit und Innovation. Dies ermöglicht es den Nutzern nicht nur, auf vielfältige Erkenntnisse zuzugreifen, sondern fördert auch informierte Entscheidungsfindung und effektive Problemlösung. Begleiten Sie uns, während wir erkunden, wie eine robuste Wissensaustauschplattform die kollektive Intelligenz stärken und die Art und Weise, wie wir gemeinsam lernen und arbeiten, transformieren kann.

Find AI tools in YBX

Related Articles

Refresh Articles