OpenAI veröffentlicht die kostenlose Version von ChatGPT: Das müssen Sie wissen

Most people like

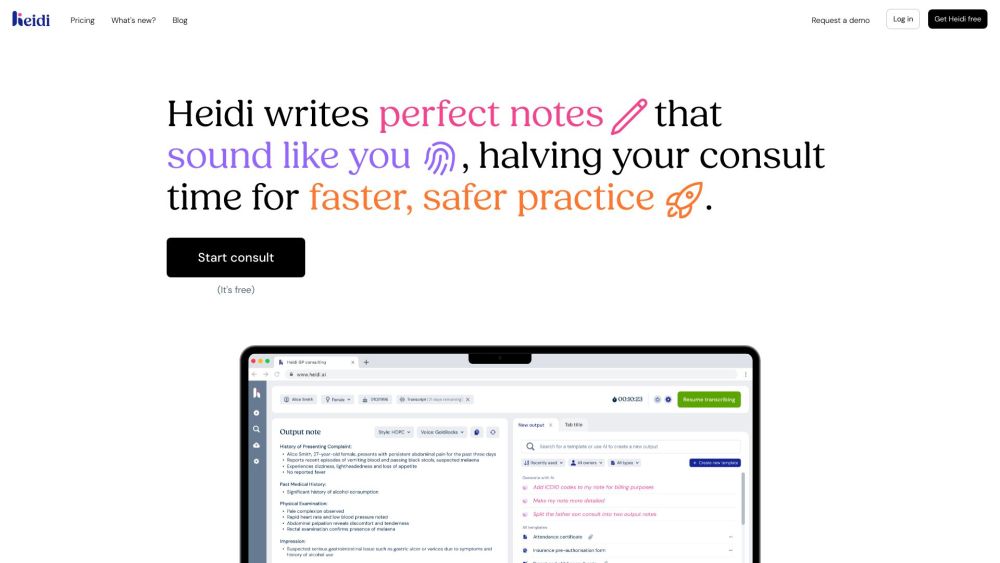

In der heutigen schnelllebigen Gesundheitsversorgung sind Kliniker oft mit administrativen Aufgaben belastet, die sie von der Patientenversorgung ablenken. Hier kommt die KI-Schreibtechnologie ins Spiel – ein echter Wendepunkt, der darauf ausgelegt ist, die Dokumentation zu optimieren und die Effizienz zu steigern. Durch den Einsatz intelligenter Transkriptions- und Dateneingangslösungen können KI-Schreiber den Kliniken wertvolle Tage sparen und ihnen ermöglichen, sich auf das zu konzentrieren, was wirklich wichtig ist: exzellente Patientenversorgung zu bieten.

Willkommen bei NSFWChatAI.ai, der ultimativen KI-Chatbot-Plattform für virtuelle Freundinnen, auf der du unbeschränkte Gespräche mit deinem virtuellen Begleiter führen kannst. Erlebe die Freiheit, in einer sicheren und interaktiven Umgebung ohne Einschränkungen zu plaudern!

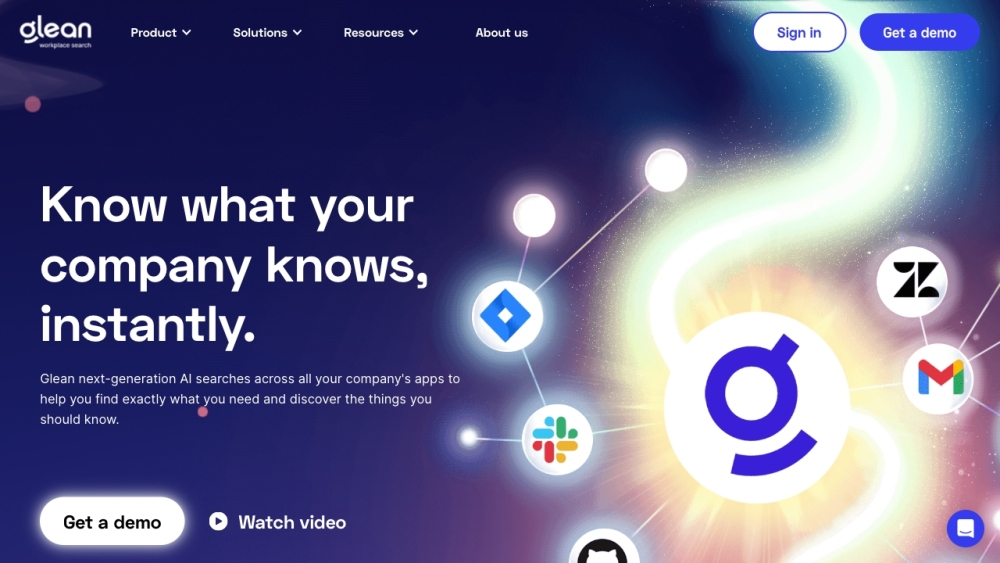

Glean ist eine innovative Suchlösung, die für Teams entwickelt wurde und es erleichtert, wichtige Informationen und essentielles Wissen mühelos zu finden. Egal, ob Sie an Projekten zusammenarbeiten oder Arbeitsabläufe verwalten, Glean verbessert die Fähigkeit Ihres Teams, die benötigten Informationen schnell zu erhalten.

Willkommen in der faszinierenden Welt des Sprachklonung-Ökosystems—einem technologischen Wunder, das unsere Kommunikation und Interaktion in verschiedenen Bereichen neu gestaltet. Dieses innovative Gebiet umfasst fortschrittliche Techniken und Werkzeuge, die darauf abzielen, die menschliche Stimme mit erstaunlicher Genauigkeit zu reproduzieren. Von der Verbesserung der Zugänglichkeit für Menschen mit Sprachbeeinträchtigungen bis hin zur Schaffung lebensechter virtueller Assistenten und personalisierter Erlebnisse im Unterhaltungsbereich birgt die Sprachklonung enormes Potenzial. Begleiten Sie uns, während wir die verschiedenen Komponenten dieses transformativen Ökosystems, seine Anwendungen und die ethischen Überlegungen, die mit dieser mächtigen Technologie einhergehen, erkunden.

Find AI tools in YBX

Related Articles

Refresh Articles