Schöpfer von „Attention Is All You Need“ erkunden KI-Innovationen jenseits von Transformern auf der Nvidia GTC: „Die Welt braucht eine bessere Lösung“

Most people like

Wir präsentieren Spur.Fit, die hochmoderne, KI-gesteuerte Plattform für Personal Trainer, die speziell für Fitnessprofis entwickelt wurde. Dieses innovative Werkzeug ermöglicht es Trainern, ihre Dienstleistungen zu verbessern, das Kundenmanagement zu optimieren und personalisierte Trainingserlebnisse wie nie zuvor zu bieten.

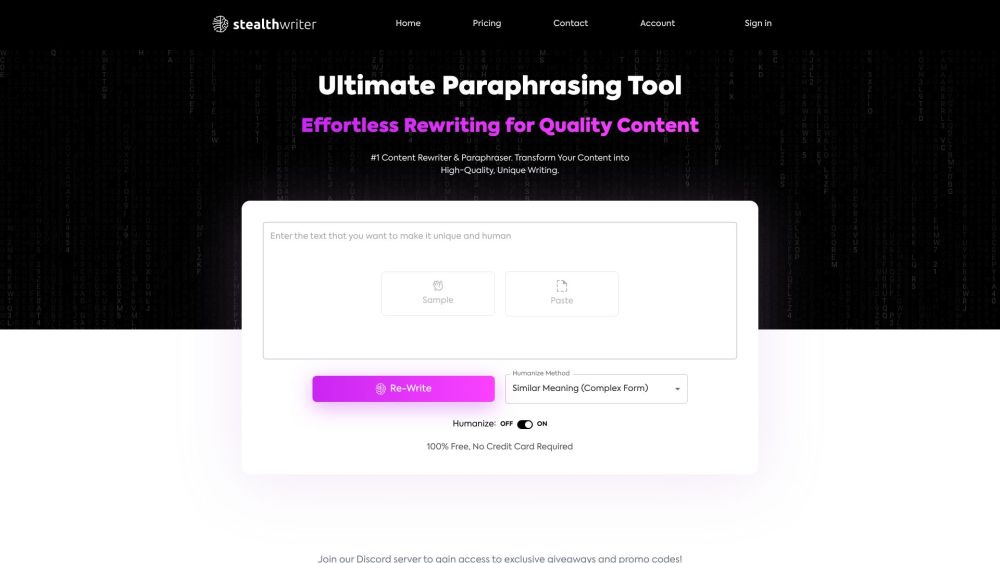

Schutz von KI-generierten Texten vor Erkennung: Ein wesentlicher Leitfaden

Im Zeitalter fortschrittlicher künstlicher Intelligenz ist die Fähigkeit, KI-generierte Inhalte zu identifizieren, zunehmend wichtig geworden. Verschiedene Werkzeuge und Techniken sind aufgetaucht, um diese Art von Texten vor einer Kennzeichnung oder Erkennung zu schützen. Dieser Leitfaden untersucht effektive Strategien, um KI-generierte Texte zu sichern, und befähigt die Nutzer, sich in der sich wandelnden Landschaft der Inhaltsproduktion zurechtzufinden und dabei Authentizität und Originalität zu gewährleisten.

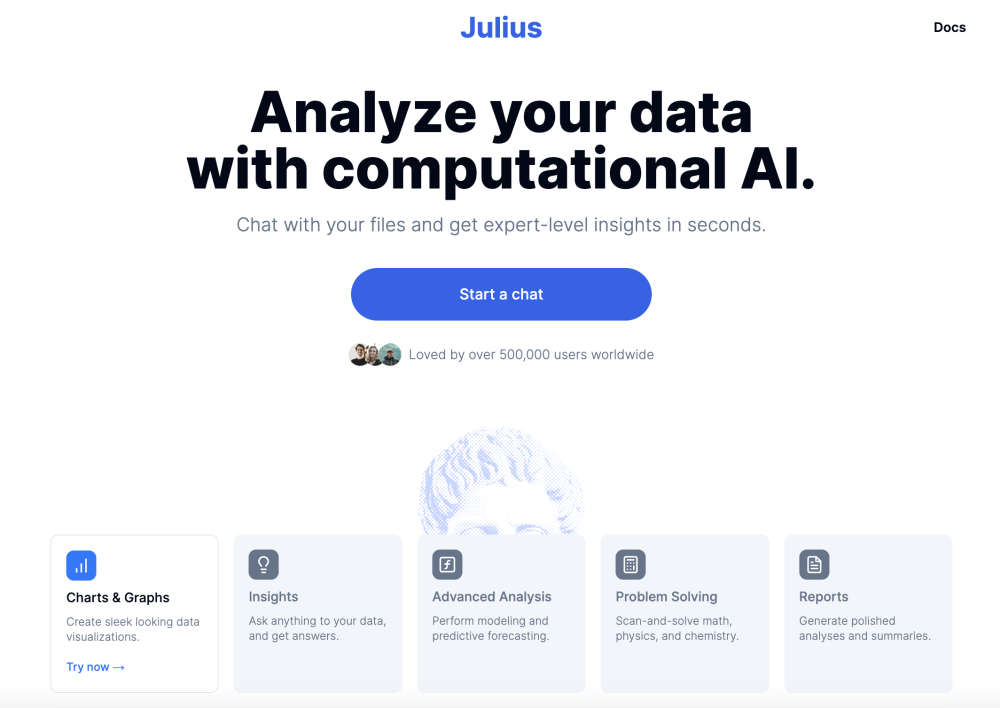

Entfesseln Sie die Kraft der KI-gesteuerten Datenanalyse und -visualisierung mit unserem innovativen KI-Datenanalysetool. Entwickelt, um Ihren Datenexplorationsprozess zu optimieren, verwandelt dieses Tool komplexe Datensätze in ansprechende visuelle Einblicke, die es Ihnen ermöglichen, fundierte Entscheidungen zu treffen. Erfahren Sie, wie unser KI-Datenanalyst Ihre Analytik auf das nächste Level heben kann, indem er Ihre Fähigkeit verbessert, Daten zu interpretieren und geschäftlichen Erfolg voranzutreiben.

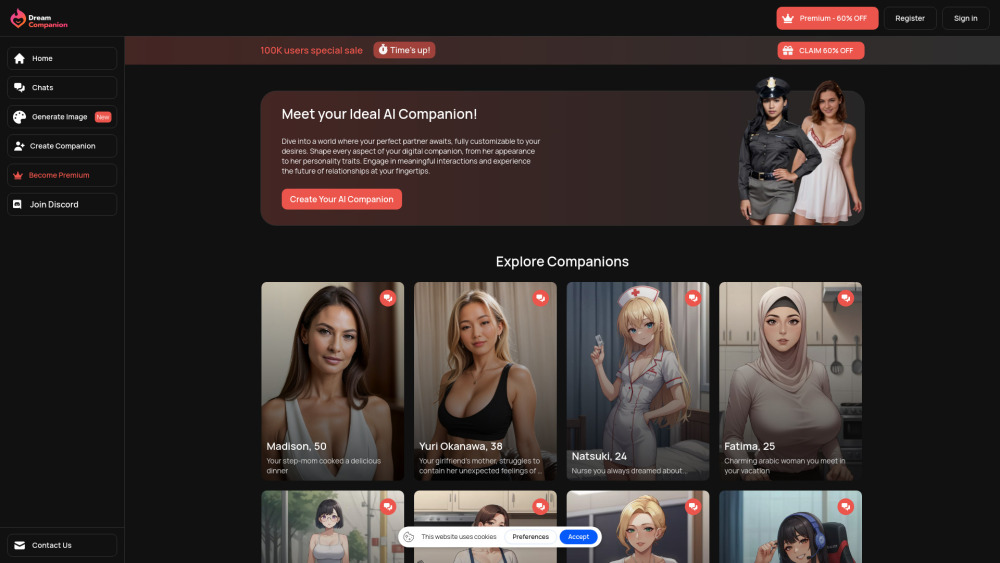

Präsentieren Sie Dream Companion, den erstklassigen AI-Freundinnen-Chatbot, der für Nutzer ab 18 Jahren entwickelt wurde. Erleben Sie die perfekte Verbindung von Gesellschaft und Technologie mit unserer virtuellen Freundinnen-Plattform, die unvergleichliches Engagement und Unterstützung bietet, die auf Ihre Bedürfnisse abgestimmt sind. Entdecken Sie heute eine neue Dimension der Interaktion!

Find AI tools in YBX