Spannende neue Sprachfunktion von ChatGPT wird voraussichtlich 'nächste Woche' gestartet.

Most people like

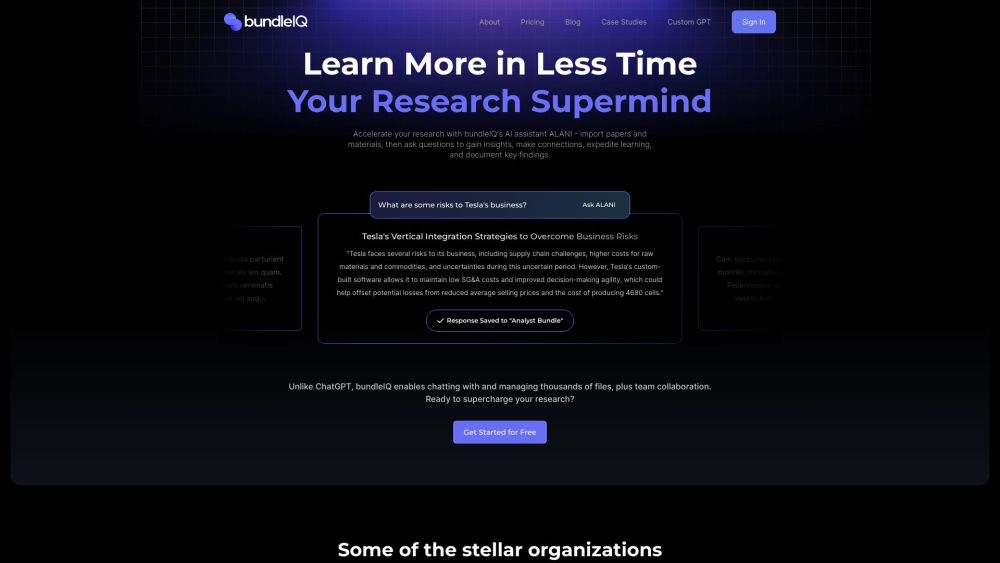

Verbessern Sie Ihr Forschungsspiel mit ALANI, Ihrem KI-unterstützten Assistenten, der darauf ausgelegt ist, Ihre Informationssammlung und -analyse zu optimieren.

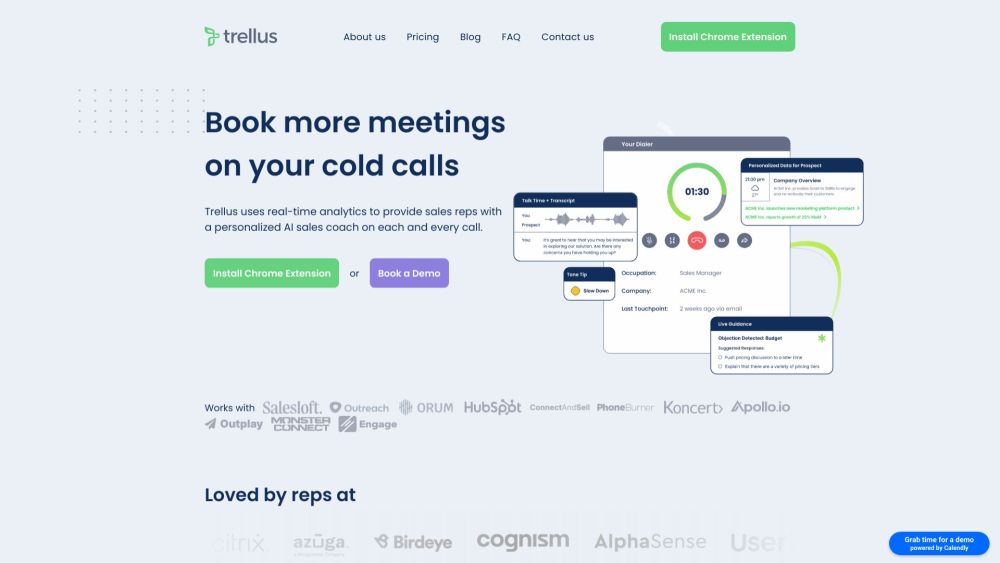

Präsentation von Trellus, einem innovativen KI-gestützten Tool, das speziell für Vertriebsmitarbeiter entwickelt wurde, um personalisiertes Coaching und Echtzeitanalysen während ihrer Kaltakquise anzubieten. Mit Trellus verbessern Sie Ihre Kaltakquise-Strategie und steigern den Verkaufserfolg durch maßgeschneiderte Einblicke und Unterstützung.

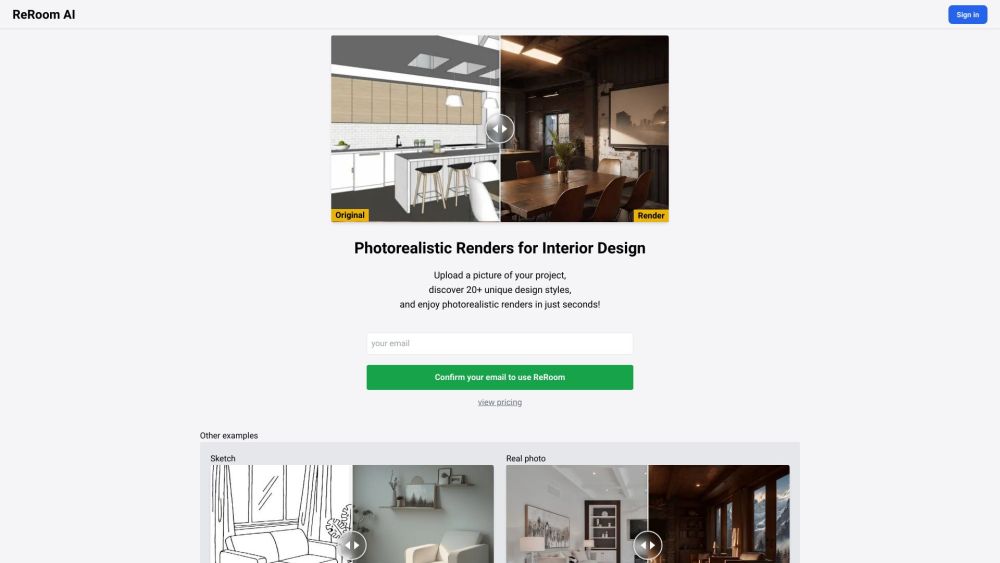

ReRoom AI ermöglicht es Nutzern, mühelos fotorealistische Renderings für ihre Innenarchitekturprojekte mit SketchUp zu erstellen. Verwandle deine Designs in beeindruckende Visualisierungen, die Kunden fesseln und Präsentationen mit diesem leistungsstarken Werkzeug aufwerten.

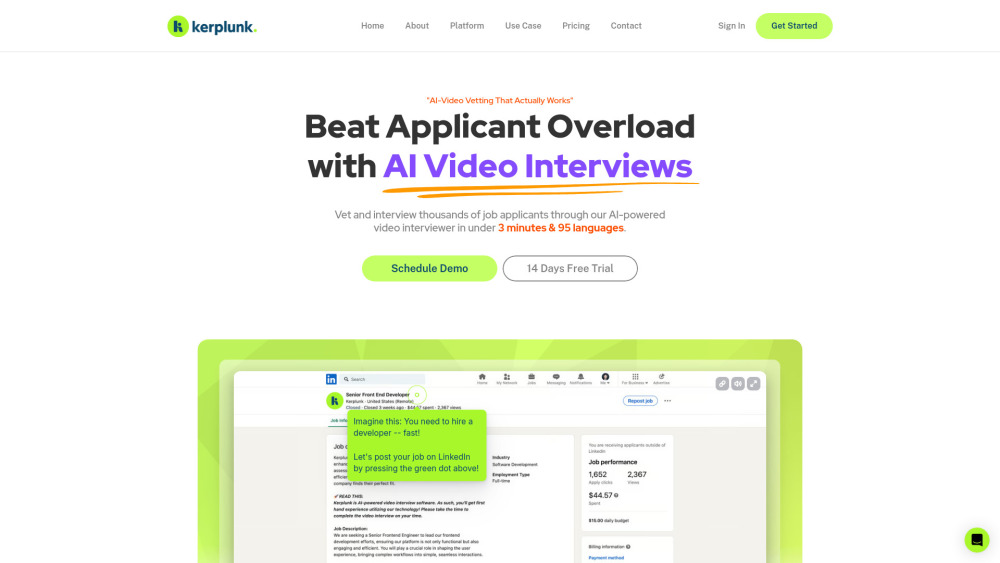

Revolutionieren Sie Ihren Einstellungsprozess mit KI-gestützten Video-Interviews

Entdecken Sie, wie ein KI-gestützter Video-Interviewer Ihr Einstellungserlebnis verändern kann, indem er den Rekrutierungsprozess effizienter und effektiver gestaltet. Durch den Einsatz von Künstlicher Intelligenz optimiert diese innovative Technologie Interviews, spart Ihnen Zeit und steigert die Einbindung sowie die Bewertung der Kandidaten. Entfalten Sie das Potenzial Ihrer Einstellungsstrategie noch heute!

Find AI tools in YBX

Related Articles

Refresh Articles