En un mundo impulsado por la inteligencia artificial, la necesidad de una moderación de juegos efectiva nunca ha sido tan crucial.

Most people like

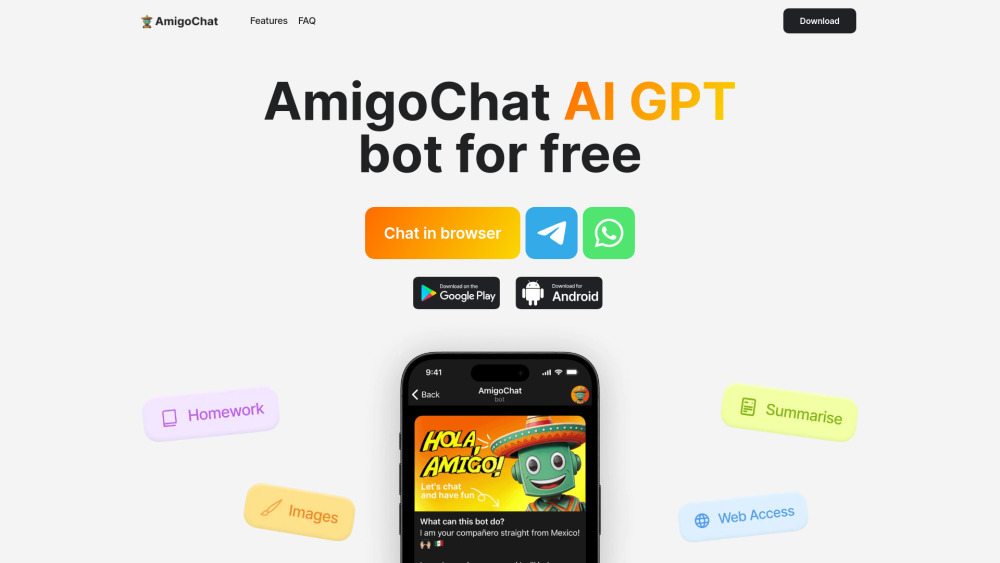

En el mundo acelerado de hoy, un asistente de IA puede revolucionar la forma en que enfrentas las tareas diarias. Desde gestionar horarios hasta ofrecer recomendaciones personalizadas, estas herramientas inteligentes están diseñadas para mejorar tu productividad y optimizar tu flujo de trabajo. Aprovecha el poder de la IA y descubre cómo puede simplificar tu vida mientras enfrentas múltiples responsabilidades. Explora las infinitas posibilidades de un asistente de IA adaptado a tus necesidades.

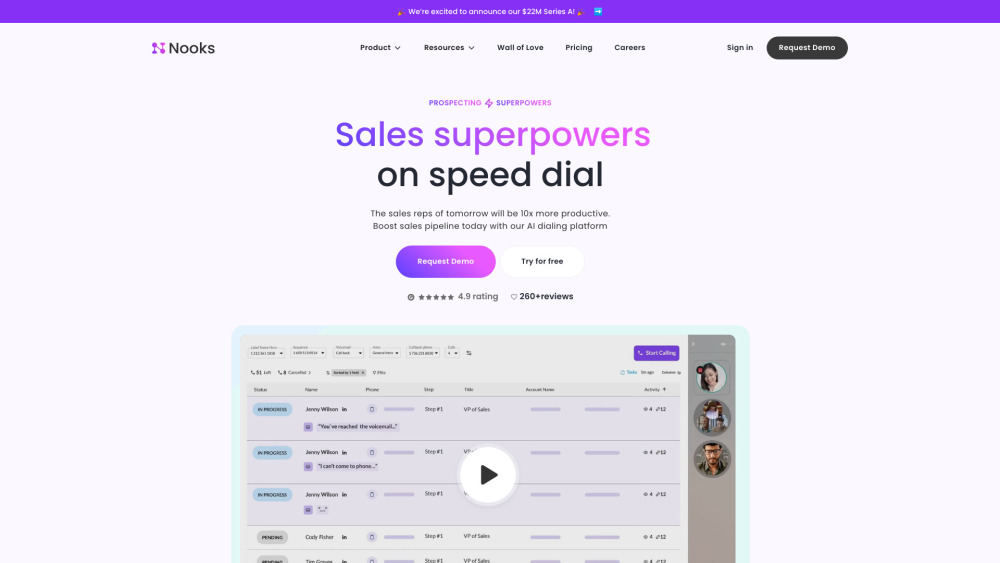

En el acelerado entorno empresarial actual, maximizar la productividad de ventas es esencial para el éxito. Una plataforma de productividad de ventas impulsada por inteligencia artificial aprovecha la tecnología avanzada para optimizar los procesos de ventas, mejorar el rendimiento del equipo y fomentar el crecimiento de ingresos. Al automatizar tareas repetitivas, ofrecer valiosos insights y facilitar un mejor compromiso con los clientes, esta solución innovadora permite a los equipos de ventas concentrarse en lo que mejor saben hacer: cerrar negocios. Acompáñanos a explorar cómo integrar la IA en tu estrategia de ventas puede transformar tu enfoque hacia la productividad y aportar resultados medibles.

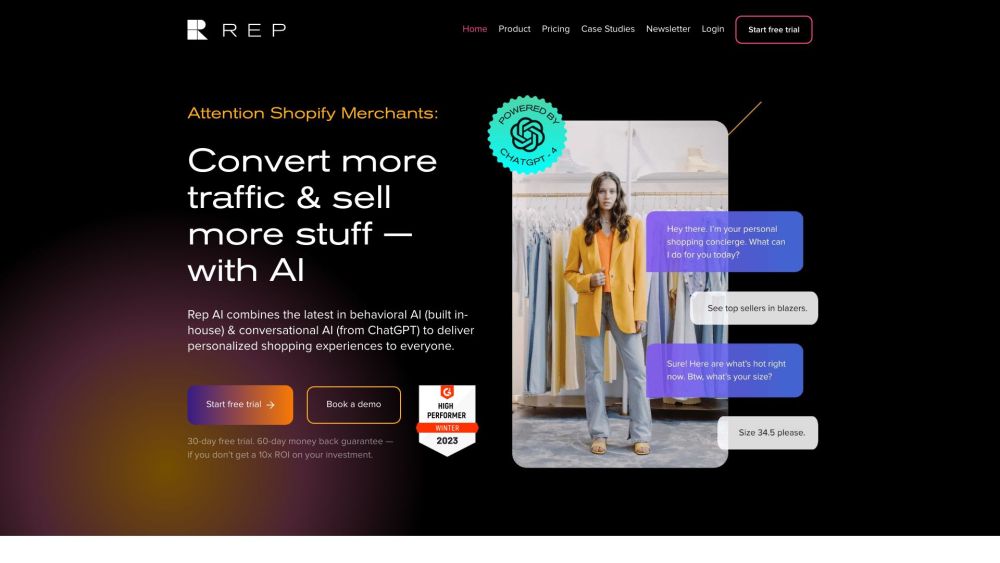

Presentamos Rep AI Home de Shopify: un innovador chatbot de IA diseñado para mejorar tu experiencia de compra en línea. Con su capacidad para ofrecer asistencia personalizada, esta herramienta vanguardista garantiza que los clientes reciban recomendaciones y apoyo adaptados a sus necesidades, haciendo que las compras sean más atractivas y eficientes que nunca.

¡Descubre la mejor aplicación de música gratuita para mejorar tu enfoque y productividad! Con la música adecuada, puedes crear un ambiente ideal para concentrarte, ya sea que estés estudiando, trabajando o simplemente buscando relajarte. Explora nuestras mejores selecciones de aplicaciones de música diseñadas específicamente para ayudarte a mantenerte enfocado y maximizar tu eficiencia. ¡Sumérgete en el mundo de la música que te mantiene comprometido y concentrado!

Find AI tools in YBX

Related Articles

Refresh Articles