Déverrouillez la puissance du machine learning haute performance : Louez des GPU AWS pour vos besoins de formation de modèles.

Most people like

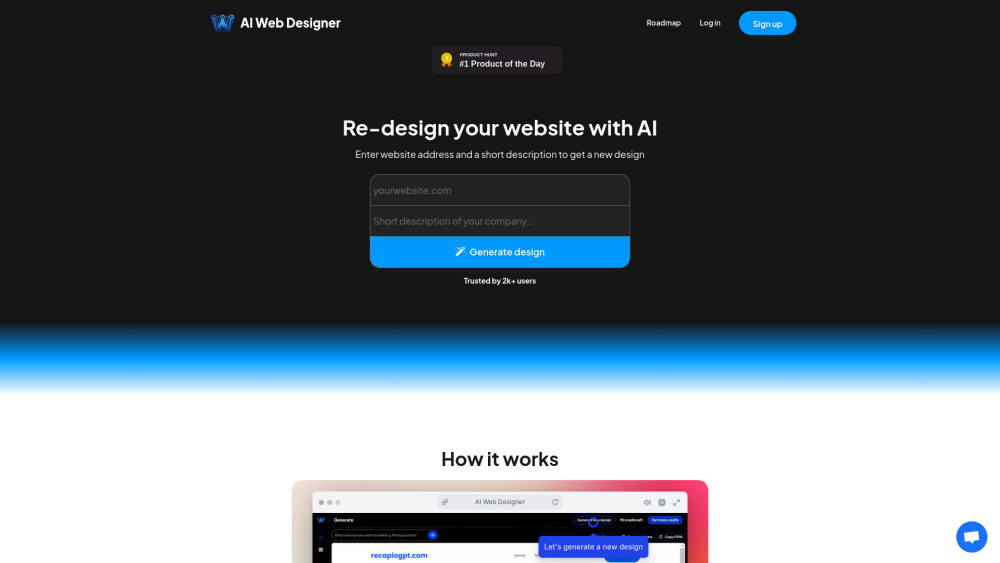

Dans le paysage numérique actuel, garder votre site web frais et engageant est essentiel pour attirer et fidéliser les visiteurs. Notre outil de refonte de site web basé sur l'IA utilise des algorithmes avancés pour analyser le comportement des utilisateurs et les tendances de design, garantissant une expérience en ligne fluide et dynamique. Cette solution innovante permet aux entreprises d'améliorer sans effort leur présence en ligne, d'augmenter l'engagement des utilisateurs et, en fin de compte, de booster les conversions. Découvrez comment notre technologie d'IA peut transformer votre site web en un puissant outil de croissance.

Ce site permet d'utiliser l'IA pour publier et générer des images captivantes. Les utilisateurs peuvent facilement créer et partager des œuvres originales.

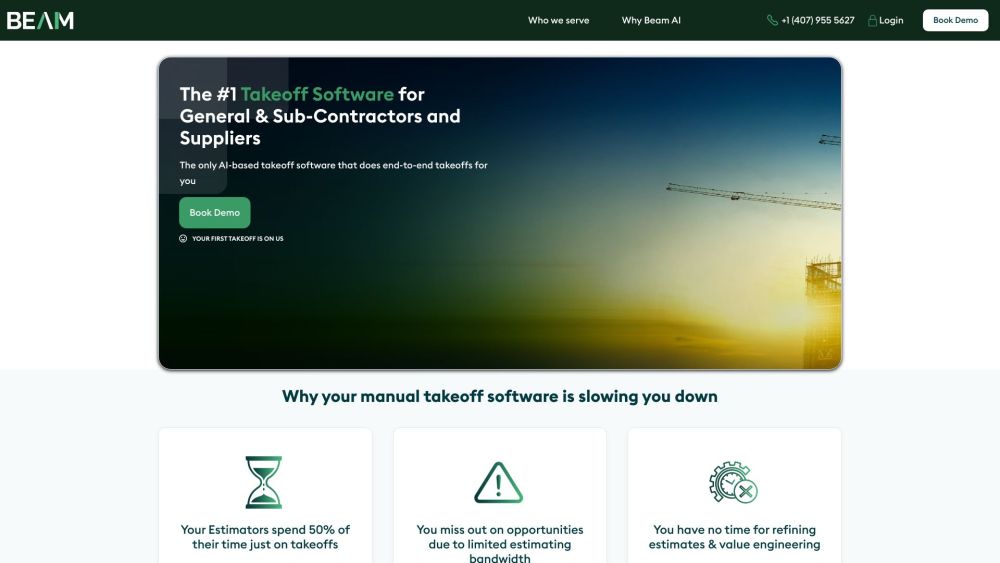

Découvrez un logiciel d'estimation basé sur le cloud, alimenté par l'IA, conçu spécifiquement pour l'industrie de la construction. Cet outil innovant simplifie les estimations, vous faisant économiser jusqu'à 90 % du temps habituellement consacré et vous permettant de gérer 30 % d'estimations supplémentaires de manière efficace. Découvrez l'avenir de l'estimation construction et augmentez dès aujourd'hui votre capacité à gérer vos projets !

Find AI tools in YBX

Related Articles

Refresh Articles