Les leaders des centres de données lancent le groupe Ultra Accelerator Link pour améliorer la connectivité en intelligence artificielle.

Most people like

Outils Excel IA : Découvrez des techniques avancées de visualisation des données et des solutions alimentées par l'IA, conçues pour améliorer vos flux de travail sur Excel et Google Sheets, afin d'accroître votre productivité et votre efficacité.

Créez facilement des résumés concis pour n'importe quel texte avec notre générateur de résumés gratuit. Que vous ayez besoin de condenser des articles longs, des travaux de recherche ou des essais, cet outil simplifie le processus en fournissant des résumés clairs et informatifs en quelques secondes. Améliorez votre productivité et votre compréhension en utilisant notre solution conviviale pour tous vos besoins de résumé.

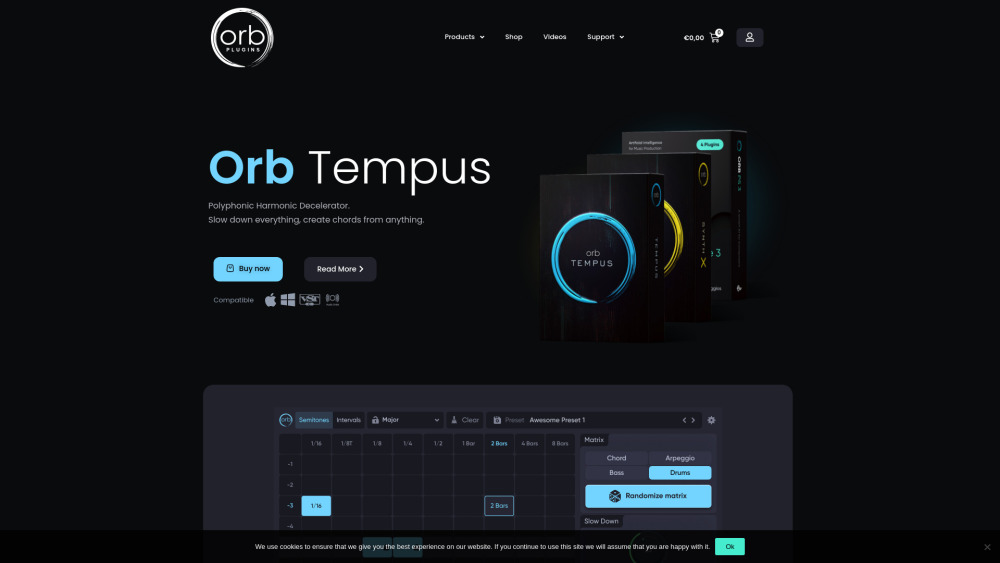

Dans l'industrie musicale en pleine évolution d'aujourd'hui, les outils d'IA transforment la manière dont les compositeurs et les producteurs créent, collaborent et innovent. Ces technologies avancées permettent aux artistes d'améliorer leurs processus créatifs, d'optimiser leurs flux de production et d'explorer de nouvelles possibilités musicales. En s'appuyant sur l'IA, les musiciens peuvent trouver de l'inspiration, générer des sons uniques et optimiser leurs projets comme jamais auparavant. Ce guide présente les meilleurs outils d'IA disponibles pour les professionnels de la musique, mettant en avant comment ils peuvent élever vos compositions et vos efforts de production vers de nouveaux sommets.

Déverrouillez le potentiel de la technologie avancée de reconnaissance d'images avec notre API puissante, conçue pour un marquage efficace, une catégorisation fluide et une reconnaissance faciale précise. Que vous souhaitiez améliorer vos applications ou optimiser votre flux de traitement d'images, notre API vous fournit les outils nécessaires pour rehausser l'expérience utilisateur et améliorer l'efficacité organisationnelle. Transformez la gestion de votre contenu visuel avec des solutions à la pointe de la technologie, adaptées à vos besoins uniques.

Find AI tools in YBX

Related Articles

Refresh Articles