Microsoft : Pourquoi l'IA ne peut pas remplacer l'expertise humaine dans la main-d'œuvre

Most people like

Dans le monde dynamique du commerce en ligne, se démarquer est essentiel pour réussir. Voici un logiciel de personnalisation alimenté par l'intelligence artificielle, conçu pour adapter l'expérience d'achat aux préférences individuelles des clients. En exploitant des algorithmes avancés et des informations basées sur les données, cette solution SaaS améliore l'engagement des clients, stimule les conversions et favorise la fidélité à la marque. Découvrez comment l'intégration de la personnalisation par IA peut révolutionner votre boutique en ligne et améliorer vos performances de vente.

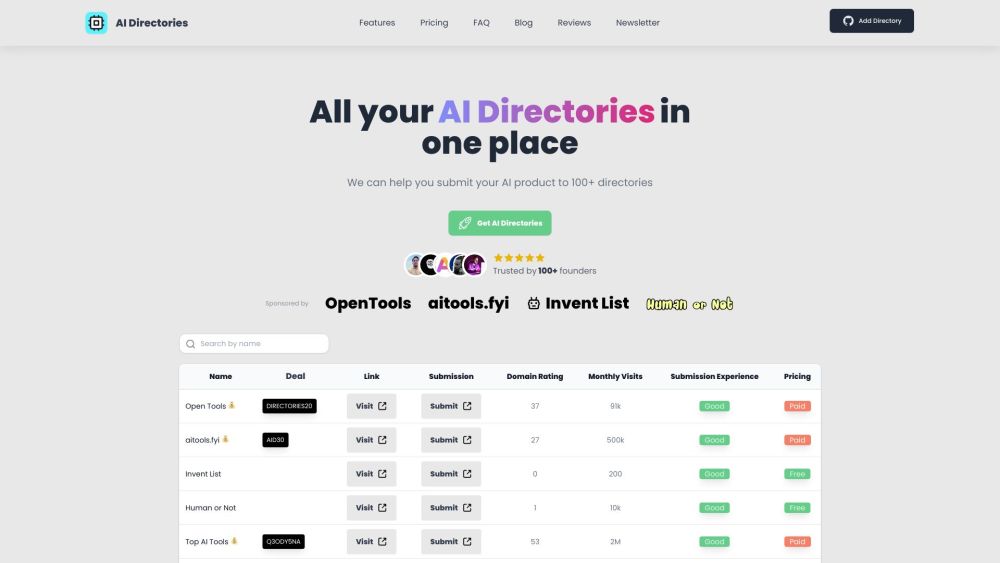

Découvrez notre collection soigneusement élaborée d'outils d'IA à la pointe de la technologie, conçus pour magnifier vos projets et rationaliser vos flux de travail. De la création de contenu à l'analyse de données, ces ressources novatrices vous permettent d'exploiter tout le potentiel de l'intelligence artificielle. Plongez et explorez l'avenir de la technologie avec notre sélection complète des meilleurs outils d'IA !

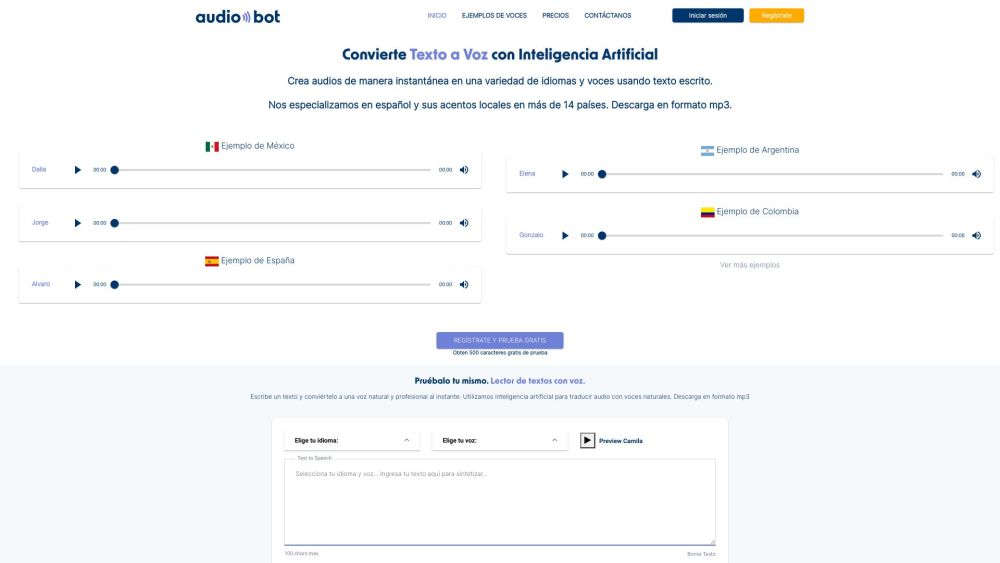

Présentation d'AudioBot : un outil IA avancé qui transforme de manière fluide le texte en voix naturelles et réalistes. Découvrez l'avenir de la synthèse vocale avec AudioBot, où une technologie de pointe donne vie à votre contenu écrit avec clarté et émotion.

Find AI tools in YBX

Related Articles

Refresh Articles