Nvidia, Hugging Face et ServiceNow lancent de nouveaux modèles de langage StarCoder2 pour améliorer les capacités de génération de code.

Most people like

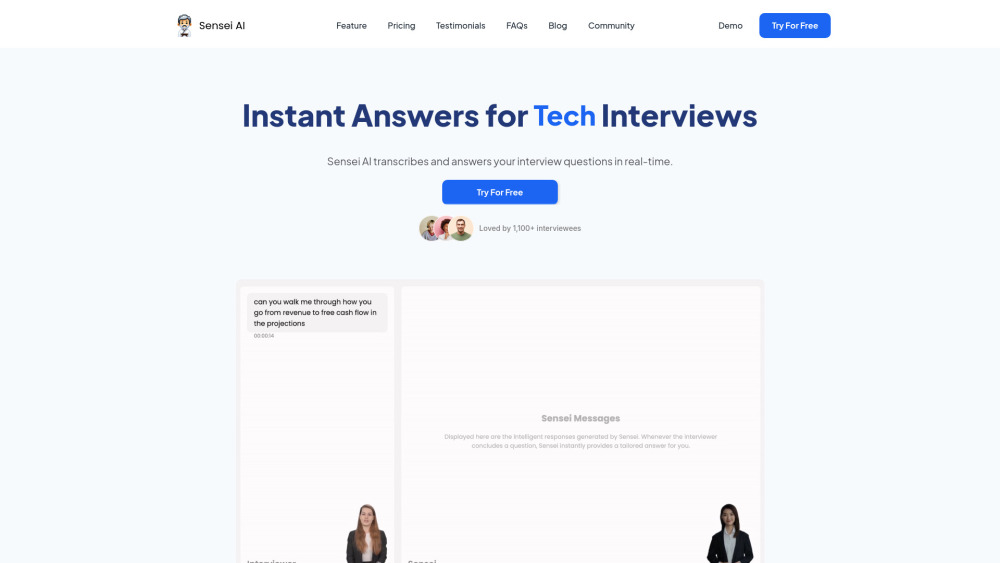

Dans le marché du travail compétitif d'aujourd'hui, se démarquer lors des entretiens est crucial pour décrocher le poste de vos rêves. Découvrez l'Assistant d'Entretien Propulsé par l'IA—un outil révolutionnaire conçu pour améliorer vos compétences en entretien et renforcer votre confiance. Grâce à un coaching personnalisé, des retours en temps réel et des questions d'entraînement adaptées, cette solution innovante aide les candidats à donner le meilleur d'eux-mêmes. Découvrez comment cette technologie peut transformer votre préparation aux entretiens et ouvrir la voie à la réussite professionnelle.

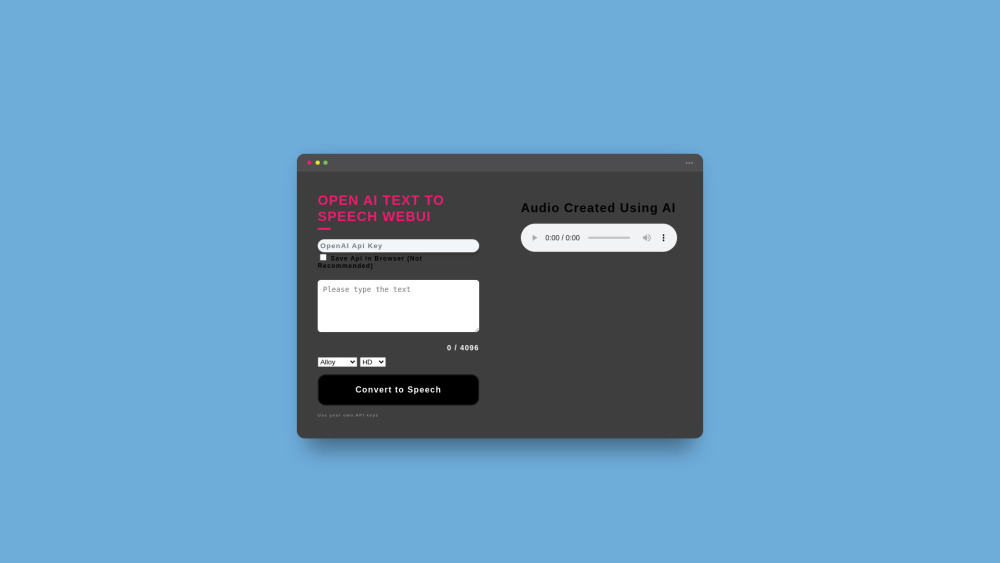

Découvrez un outil en ligne gratuit qui transforme facilement le texte en parole. Cette ressource conviviale vous permet de convertir le contenu écrit en mots prononcés, facilitant ainsi l'accessibilité et l'engagement des apprenants auditifs. Que ce soit pour des projets personnels, des objectifs éducatifs ou des présentations professionnelles, ce puissant convertisseur de texte en parole simplifie vos besoins de communication.

Dans le paysage numérique en constante évolution d'aujourd'hui, l'intersection de l'intelligence artificielle (IA) et des expériences immersives captive un public de plus en plus large. À mesure que la technologie progresse, la communauté de l'IA met à profit des outils innovants pour transformer notre interaction avec notre environnement, enrichissant à la fois le divertissement et l'apprentissage. Explorer cette fusion dynamique met en lumière non seulement le potentiel de l'IA, mais aussi son rôle dans la création d'expériences engageantes et immersives qui résonnent avec les utilisateurs. Rejoignez-nous pour découvrir comment l'IA révolutionne notre compréhension et notre engagement envers le monde qui nous entoure.

Find AI tools in YBX

Related Articles

Refresh Articles