OpenAI Dévoile son 'Cadre de Préparation' pour Surveiller et Réduire les Risques liés à l'IA

Most people like

Découvrez une plateforme de mathématiques en ligne conçue pour un apprentissage personnalisé. Notre approche innovante adapte les expériences éducatives aux besoins de chaque élève, garantissant une manière plus efficace et engageante de maîtriser les concepts mathématiques. Rejoignez-nous pour améliorer vos compétences en mathématiques grâce à des leçons sur mesure, des outils interactifs et des ressources de soutien qui répondent au parcours unique de chaque apprenant. Embrassez l'avenir de l'éducation mathématique dès aujourd'hui !

Présentation d'une plateforme en ligne dédiée à la détection et à la prévention du plagiat. Nos outils avancés permettent aux utilisateurs d'identifier et d'éliminer les cas de plagiat, garantissant l'intégrité et l'originalité de leurs travaux. Que vous soyez étudiant, éducateur ou professionnel, notre service est conçu pour préserver l'éthique académique et encourager la créativité. Rejoignez-nous pour protéger votre contenu et maintenir des normes élevées d'originalité.

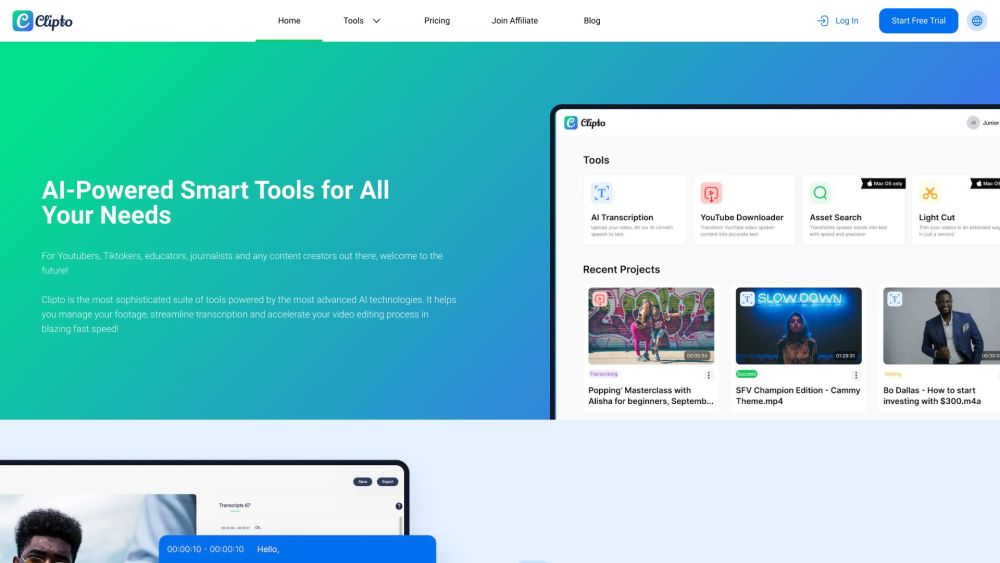

Découvrez notre service de transcription avancé par IA, conçu pour convertir sans effort les fichiers audio, vidéo et YouTube en texte précis. Profitez de l'efficacité et de la précision de la transcription automatisée qui améliore l'accessibilité et renforce l'engagement avec le contenu.

Boostez votre stratégie de génération de leads avec des quiz interactifs. Ces outils engageants non seulement attirent l'attention, mais collectent également des informations précieuses sur votre audience. Découvrez comment l'intégration de quiz dans vos efforts marketing peut améliorer l'engagement des utilisateurs et convertir des prospects en clients fidèles.

Find AI tools in YBX