Présentation de 'Liberated Qwen' : un LLM non censuré conçu pour respecter rigoureusement les consignes système.

Most people like

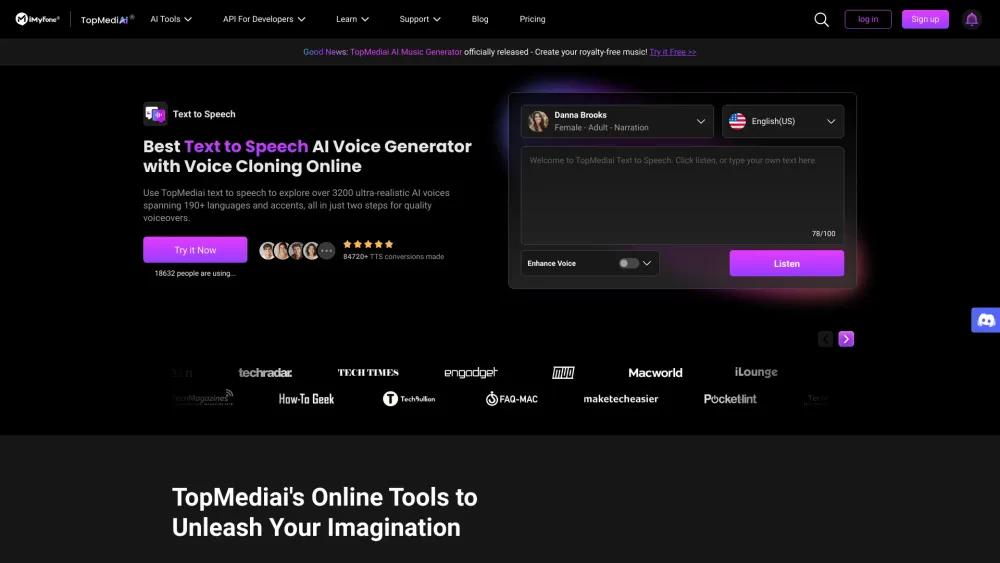

Dans le paysage numérique rapide d'aujourd'hui, les créateurs de contenu recherchent constamment des solutions innovantes pour améliorer leur productivité et leur créativité. Les outils en ligne alimentés par l'IA sont devenus des ressources essentielles, offrant des fonctionnalités de pointe qui simplifient le processus de création. Des aides à l'écriture automatisées aux capacités avancées d'édition d'images, ces outils permettent aux créateurs de produire un contenu de haute qualité plus efficacement. Découvrez comment ces solutions d'IA peuvent transformer votre flux de travail créatif et rehausser votre présence numérique.

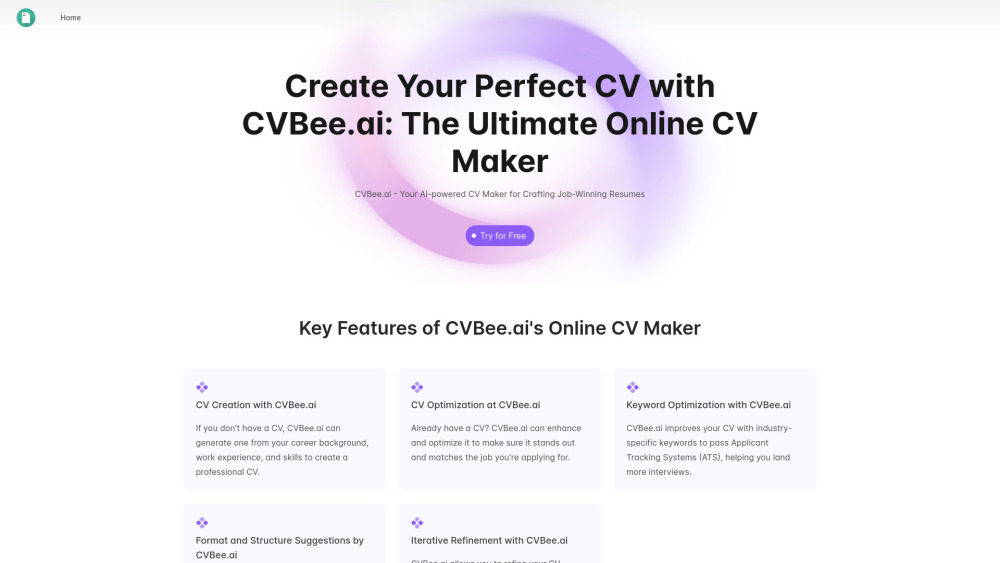

Créez des CV professionnels en toute simplicité avec le générateur de CV alimenté par l'IA de CVBee.ai en quelques minutes. Élevez vos candidatures et améliorez vos perspectives de carrière dès maintenant !

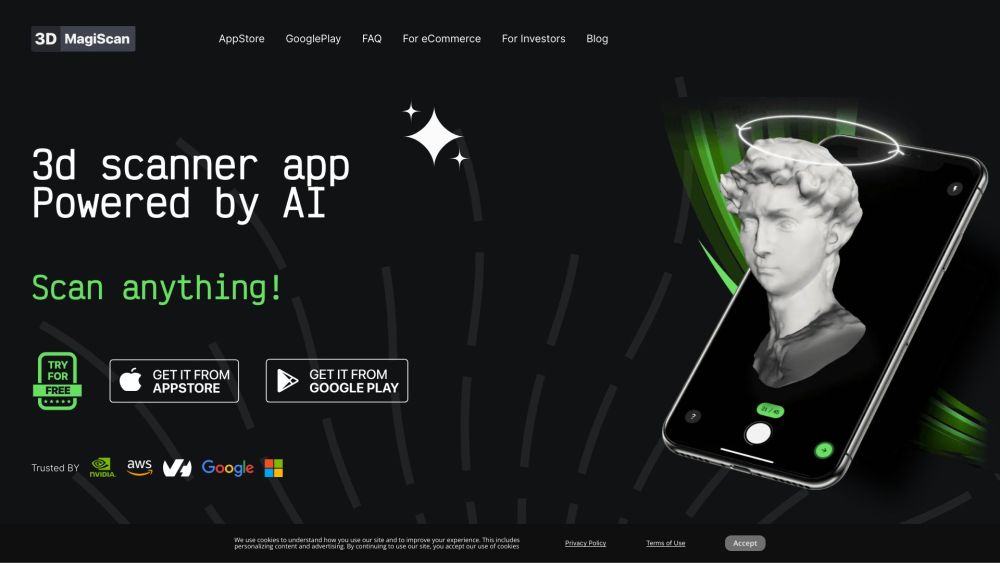

Transformez votre smartphone en un puissant outil de création 3D ! En quelques touches, vous pouvez transformer des objets du quotidien en modèles 3D époustouflants.

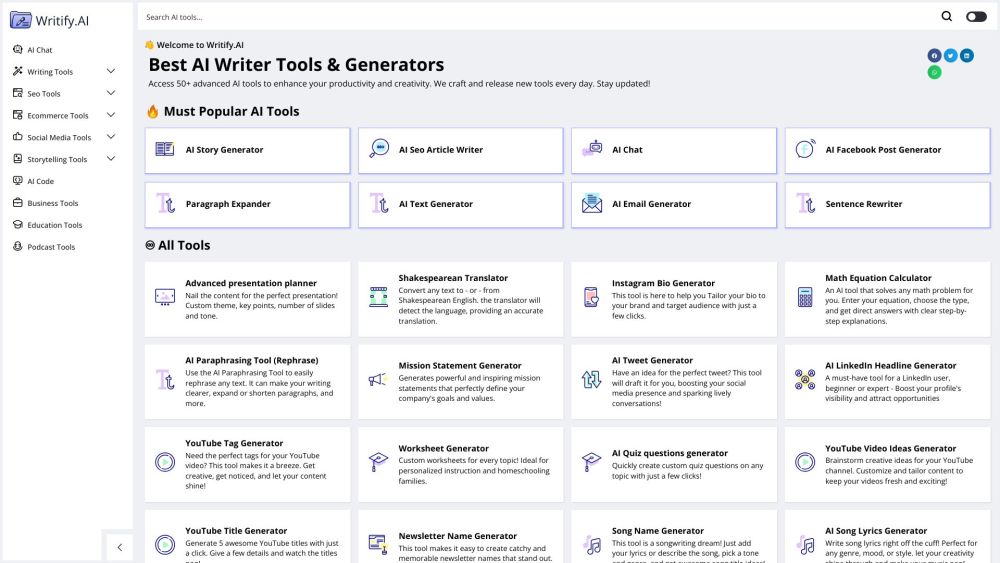

Déverrouillez votre potentiel avec notre gamme d'outils AI pour une productivité et une créativité accrues

Découvrez comment notre suite puissante d'outils AI peut transformer votre flux de travail, augmenter votre productivité et raviver votre créativité. Conçues pour les individus et les équipes, ces solutions innovantes rationalisent les tâches, améliorent la collaboration et inspirent des idées originales. Explorez l'avenir du travail avec des technologies AI de pointe conçues pour maximiser votre efficacité et encourager la créativité dans chaque projet. Adoptez une manière plus intelligente d'atteindre vos objectifs dès aujourd'hui !

Find AI tools in YBX

Related Articles

Refresh Articles