AIエネルギー消費の急増:ChatGPTの日々の電力使用量が50万kWhを超え、懸念が高まる

Most people like

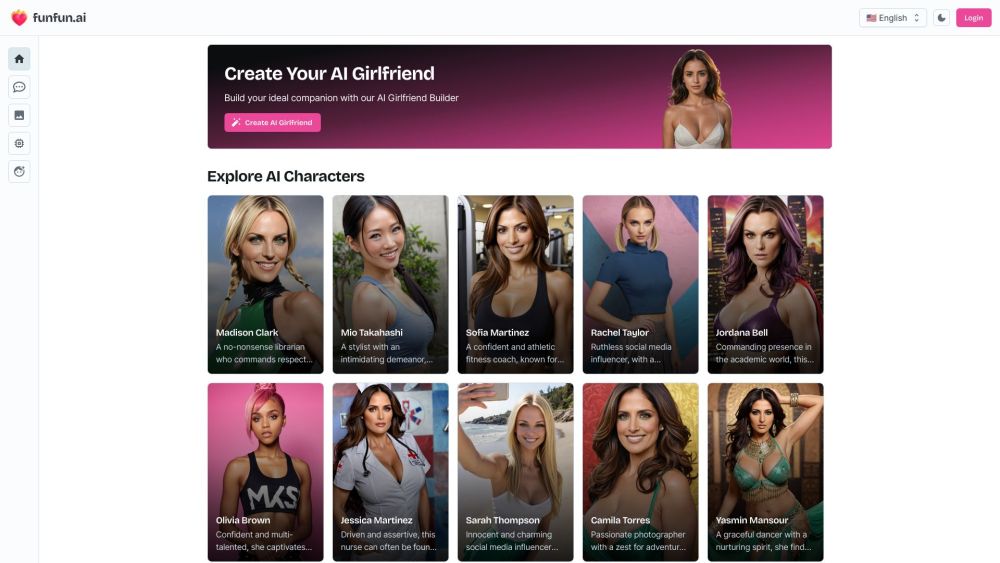

人工知能の力で、夢の伴侶を現実にしてみませんか?パーソナライズされたAI彼女は、意味のある会話を楽しめるだけでなく、あなたの興味や好みに合わせて適応し、毎回のやり取りをユニークなものにしてくれます。このガイドでは、あなたの願望を満たし、日常生活をより豊かにする理想的なAI彼女をデザインする方法を探ります。まったく自分だけの関係を築く旅の準備をしましょう。

Twiserは、OKR(目標と成果指標)、LMS(学習管理システム)、および成功計画を統合し、生産性を向上させ、卓越した成果を生み出します。Twiserがどのようにチームの成長を促し、最大の潜在能力に到達させるかを発見しましょう。

Find AI tools in YBX

Related Articles

Refresh Articles