OpenAI의 AGI 안전 팀원 거의 절반이 AI 보안 문제에 대한 우려가 커지는 가운데 떠났습니다.

Most people like

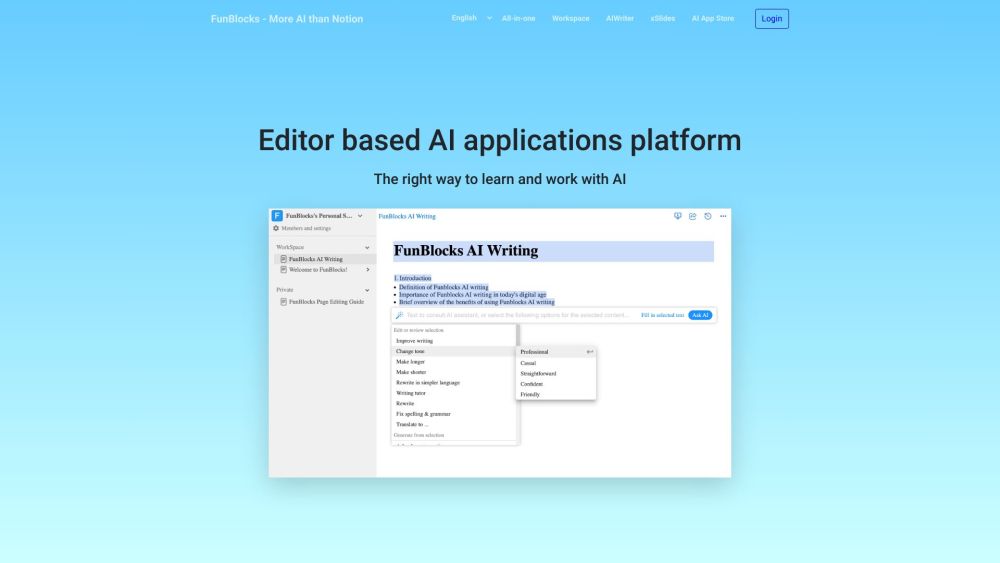

AI의 힘으로 글쓰기 능력을 향상시키고 학습 경험을 풍부하게 하세요. 창의력을 발휘하고 교육 여정을 간소화하는 혁신적인 도구와 기법을 발견해 보세요. 오늘날 글쓰기와 학습의 미래를 만끽하세요!

오늘날 급변하는 직장 환경에서 직원 참여를 촉진하는 것은 조직의 성공에 매우 중요합니다. AI 기반의 직원 참여 플랫폼은 고급 기술을 활용하여 팀 내 동기 부여, 협업 및 전반적인 생산성을 향상시킵니다. 데이터 기반 통찰력과 개인화된 전략을 활용함으로써, 이 혁신적인 솔루션은 비즈니스가 보다 연결되고 동기 부여가 된 인력을 조성하도록 지원하며, 궁극적으로 성과와 유지율을 높입니다. AI 중심의 접근 방식이 귀사의 참여 전략을 어떻게 변화시킬 수 있는지, 그리고 번창하는 직장 문화를 만드는 데 어떻게 기여할 수 있는지 알아보십시오.

Find AI tools in YBX