Manifestantes se Reúnem em Frente ao Escritório da OpenAI Contra o Uso Militar de IA e o Desenvolvimento de AGI

Most people like

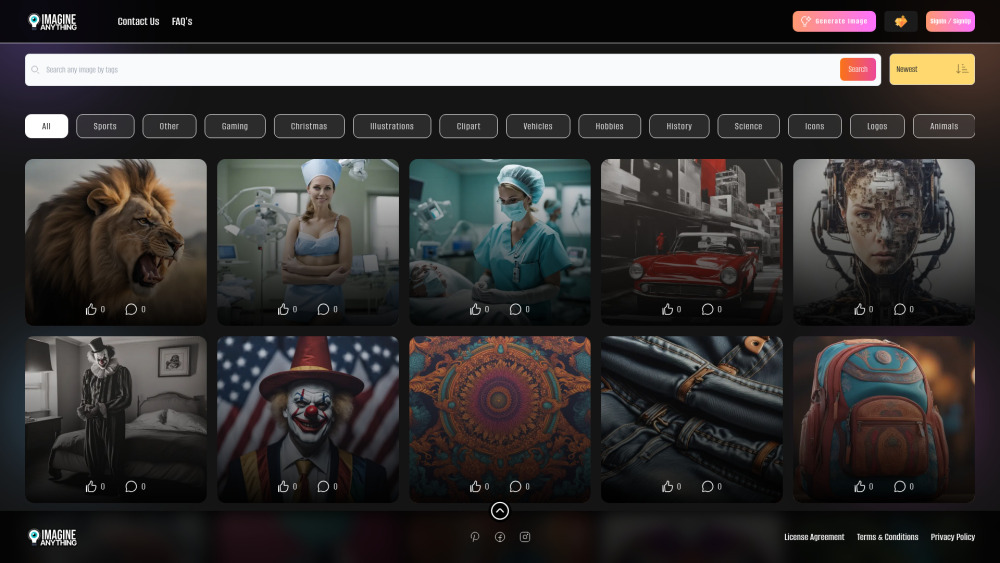

Descubra o poder do nosso gerador de imagens de IA gratuito, projetado para ajudar você a transformar suas ideias em visuais impressionantes com facilidade. Se você é um criador de conteúdo, profissional de marketing ou entusiasta, nossa ferramenta oferece uma maneira simples e intuitiva de gerar imagens únicas usando inteligência artificial avançada. Comece a criar gráficos atraentes hoje e dê vida às suas visões!

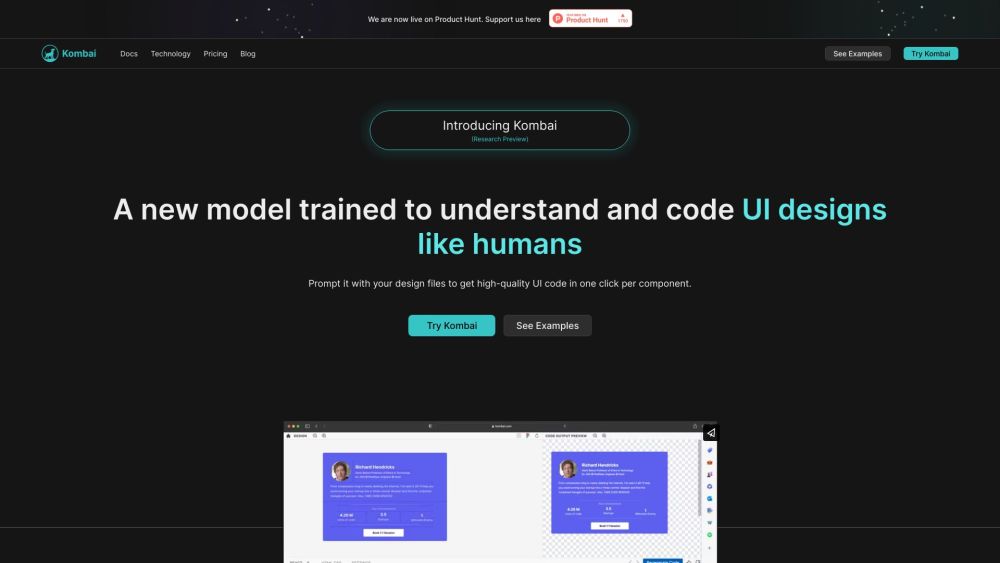

Kombai é uma ferramenta inovadora impulsionada por IA, projetada para transformar de forma impecável os designs do Figma em código front-end preciso. Experimente o futuro da conversão de design para código com precisão e eficiência incomparáveis.

Descubra os melhores produtos de dropshipping com facilidade usando a ferramenta de espionagem de anúncios da WinningHunter. Analise anúncios no Facebook e TikTok, monitore vendas de lojas e crie textos publicitários atraentes com a tecnologia de IA. Eleve seu sucesso em dropshipping com o conjunto robusto de recursos da WinningHunter, projetado para resultados ótimos.

Descubra nossa abrangente ferramenta de edição de fotos online gratuita, alimentada por recursos avançados de IA. Remova fundos facilmente, aprimore imagens, expanda visuais, gere imagens a partir de texto e utilize nosso apagador mágico, tudo em um só lugar. Eleve sua experiência de edição de fotos hoje mesmo!

Find AI tools in YBX

Related Articles

Refresh Articles