Quando deepfakes sexualmente explícitos de Taylor Swift se tornaram virais no X (anteriormente conhecido como Twitter), milhões de seus fãs se mobilizaram sob a hashtag #ProtectTaylorSwift. Embora seus esforços tenham ajudado a abafar o conteúdo ofensivo, o incidente atraiu uma atenção midiática significativa, gerando um importante debate sobre os perigos da tecnologia deepfake. A secretária de imprensa da Casa Branca, Karine Jean-Pierre, inclusive, pediu medidas legislativas para proteger indivíduos de conteúdos gerados por IA prejudiciais.

Embora o incidente com Swift tenha sido chocante, não é um caso isolado. Celebridades e influenciadores têm sido cada vez mais vítimas de deepfakes nos últimos anos, e à medida que a tecnologia de IA avança, o potencial de danos à reputação tende a aumentar.

Agentes de IA e a ascensão dos deepfakes

“Com apenas um breve vídeo de si mesmo, você pode criar um novo clipe com diálogos baseados em um roteiro. Embora isso possa ser divertido, também significa que qualquer um pode gerar conteúdo enganoso, arriscando danos à reputação", explicou Nicos Vekiarides, CEO da Attestiv, uma empresa especializada em ferramentas de validação de fotos e vídeos.

Conforme as ferramentas de IA para criar conteúdo deepfake se tornam mais acessíveis e sofisticadas, a paisagem online está repleta de imagens e vídeos enganosos. Isso levanta uma questão importante: como as pessoas podem discernir a realidade da manipulação?

Entendendo as implicações dos deepfakes

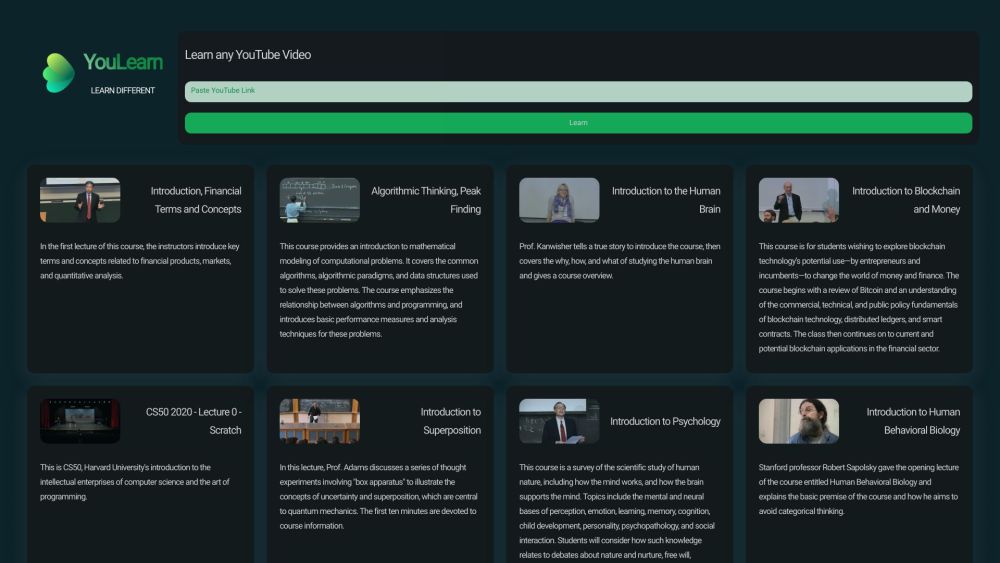

Deepfakes são imagens, vídeos ou áudios artificiais realistas criados com tecnologia de deep learning. Embora essas manipulações existam há vários anos, ganharam notoriedade no final de 2017, quando um usuário do Reddit chamado ‘deepfake’ começou a compartilhar conteúdo pornográfico gerado por IA. Inicialmente dependentes de tecnologia complexa para troca de rostos, os avanços recentes democratizaram essa capacidade, permitindo que quase qualquer pessoa criasse manipulações convincentes de figuras públicas usando plataformas como DALL-E, Midjourney, Adobe Firefly e Stable Diffusion.

A ascensão da IA generativa permitiu que agentes mal-intencionados explorassem até mesmo pequenas falhas na tecnologia; por exemplo, o outlet de tecnologia independente 404 Media descobriu que os deepfakes de Taylor Swift foram produzidos contornando as salvaguardas nas ferramentas de IA da Microsoft. Tecnologias similares foram usadas para criar imagens enganosas do Papa Francisco e áudios imitando figuras políticas como o presidente Biden.

Os perigos do acesso fácil

A acessibilidade da tecnologia deepfake representa riscos severos, podendo danificar reputações de figuras públicas, enganar eleitores e facilitar fraudes financeiras. Steve Grobman, CTO da McAfee, observa uma tendência alarmante na qual golpistas combinam imagens em vídeo autênticas com áudios falsos, usando semelhanças clonadas de celebridades como Swift para enganar o público.

De acordo com o relatório de Fraude de Identidade da Sumsub, o número de deepfakes detectados globalmente aumentou dez vezes em 2023, com o setor de criptomoedas sendo o mais afetado, representando 88% dos incidentes, seguido pelo setor de fintech com 8%.

A crescente preocupação pública

A apreensão pública em relação aos deepfakes é palpável. A pesquisa da McAfee de 2023 revelou que 84% dos americanos estão preocupados com o uso indevido da tecnologia deepfake em 2024, com mais de um terço relatando experiências pessoais relacionadas a fraudes por deepfake.

À medida que a tecnologia de IA continua a evoluir, torna-se cada vez mais difícil distinguir conteúdos reais de mídias manipuladas. Pavel Goldman-Kalaydin, chefe de IA e ML da Sumsub, alerta que os avanços tecnológicos, inicialmente percebidos como benéficos, agora representam ameaças à integridade da informação e à segurança pessoal.

Detectando deepfakes

À medida que governos e organizações buscam combater a proliferação de deepfakes, a capacidade de diferenciar conteúdo genuíno de falso é imperativa. Especialistas sugerem dois métodos principais para detectar deepfakes: analisar o conteúdo em busca de discrepâncias sutis e verificar a autenticidade da fonte.

Atualmente, imagens geradas por IA podem ser assustadoramente realistas, enquanto vídeos gerados por IA estão melhorando rapidamente. No entanto, inconsistências muitas vezes revelam sua natureza artificial, como movimentos de mãos não naturais, fundos distorcidos, iluminação inadequada e artefatos digitais. Vekiarides enfatiza a importância de examinar detalhes como sombras ausentes ou características faciais excessivamente simétricas como potenciais indicativos de manipulação.

Esses métodos de detecção podem se tornar mais difíceis à medida que a tecnologia avança, exigindo uma abordagem vigilante ao interagir com mídias duvidosas. Rouif aconselha que os usuários avaliem a intenção por trás do conteúdo e considerem possíveis vieses da fonte.

Para auxiliar os esforços de verificação, empresas de tecnologia estão desenvolvendo soluções avançadas de detecção. Google, ElevenLabs e McAfee estão explorando métodos para identificar conteúdo gerado por IA, com a McAfee relatando uma taxa de precisão de 90% na detecção de áudios maliciosos.

Em um cenário cada vez mais repleto de mídias enganosas, entender as implicações e riscos dos deepfakes é crucial. Manter-se informado e cético pode capacitar o público a navegar por este desafiador ambiente digital.