Explorando o Novo Modelo de IA 'MM1' da Apple: Recursos, Aplicações e Inovações

Most people like

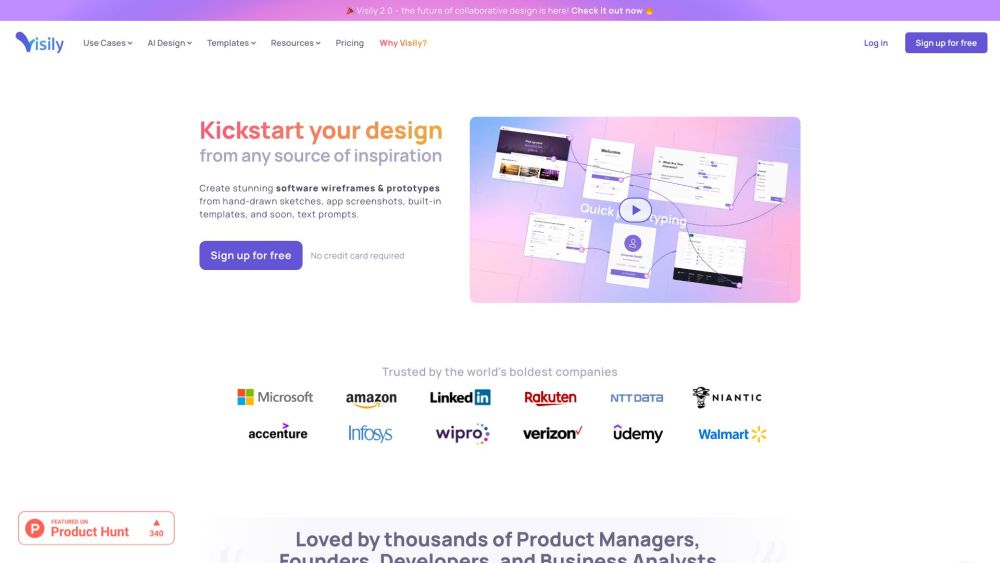

Descubra um lançador ágil e personalizável, criado para aprimorar seu foco ao simplificar a gestão de suas ferramentas. Mantenha-se organizado e aumente sua produtividade com esta solução eficiente!

Transforme seu texto em imagens PNG vibrantes com fundos transparentes. Este guia irá guiá-lo pelos passos simples para converter qualquer texto em gráficos PNG elegantes e de alta qualidade, perfeitos para aprimorar seus designs web ou apresentações. Abrace o poder da transparência e eleve seu conteúdo visual com facilidade!

Find AI tools in YBX

Related Articles

Refresh Articles