Недавний отчет Всемирного форума по защите конфиденциальности раскрыл важные выводы о инструментах управления ИИ, используемых правительствами и многосторонними организациями. Обзор 18 таких инструментов показал, что более одной трети (38%) из них содержат "неисправимые ошибки". Эти инструменты, предназначенные для оценки систем ИИ на предмет справедливости и объяснимости, часто лишены необходимых механизмов обеспечения качества или используют методы измерения, не подходящие для других контекстов.

Многие из этих инструментов были разработаны крупными технологическими компаниями, такими как Microsoft, IBM и Google, которые также создают оцениваемые ими системы ИИ. Например, в отчете упоминается инструмент IBM AI Fairness 360, который был одобрен Управлением бухгалтерии правительства США за внедрение этических принципов в ИИ. Однако основное исследование, на котором основан его алгоритм "Disparate Impact Remover", подверглось значительной критике в академических кругах.

Пэм Диксон, основатель и исполнительный директор Всемирного форума по защите конфиденциальности, отметила: "Большинство используемых в настоящее время инструментов управления ИИ работают без надлежащих стандартов." Она указала на серьезную проблему отсутствия установленных требований к обеспечению качества. Инструменты, предназначенные для одной конкретной ситуации, могут быть неправильно использованы, что приводит к "неправильным" применениям и непредвиденным последствиям.

В отчете инструменты управления ИИ определяются как механизмы для оценки и измерения аспектов систем ИИ, включая инклюзивность, справедливость, объяснимость, конфиденциальность и безопасность. Хотя эти инструменты могут успокаивать регуляторов и общественность, они могут неосознанно создавать ложное чувство уверенности, вызывать непредвиденные проблемы и подрывать потенциал технологий ИИ.

С недавним принятием Закона ЕС о ИИ и Исполнительного указа президента Байдена в сфере ИИ существует актуальная возможность улучшить ландшафт управления ИИ, как отметила Кейт Кэй, заместитель директора Всемирного форума по защите конфиденциальности. "Хотя мы выявили некоторые недостатки, существует значительный потенциал для улучшения экосистемы управления ИИ," — добавила она. "Эти инструменты представляют собой способ, которым правительства реализуют политику в области ИИ, и будут играть ключевую роль в внедрении будущих законов и норм."

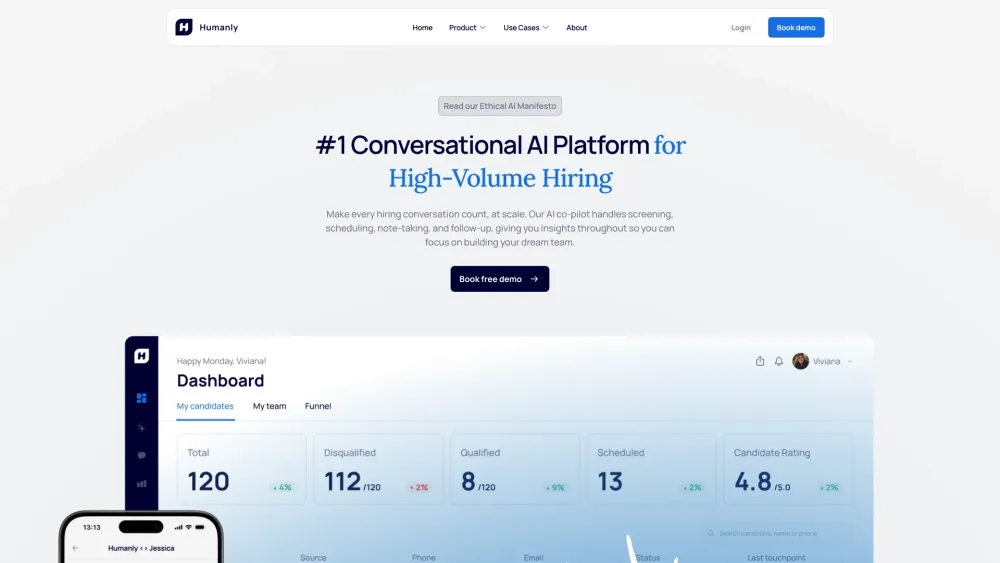

Кэй также привела пример того, как благие намерения могут привести к плохим последствиям: правило четырех пятых (80%) в законодательстве о занятости США неправильно применяется в инструментах управления ИИ по всему миру. Это правило оценивает, приводят ли процессы отбора к негативным последствиям для определенных групп, однако оно было абстрагировано до контекстов, не связанных с трудом, что приводит к неподобающим приложениям.

В условиях давления на внедрение нормативных актов о ИИ Кэй предостерегла от введения ошибочных методологий в политику. Она подчеркнула риск постоянного продления существующих проблем через спешные реализации.

С нетерпением смотря в 2024 год, Диксон и Кэй оптимистично относятся к возможностям развития инструментов управления ИИ. Диксон отметила, что Организация экономического сотрудничества и развития (ОЭСР) готова сотрудничать для улучшения этих инструментов, что сигнализирует о положительном направлении. Национальный институт стандартов и технологий (NIST) также выразил интерес к разработке строгих стандартов на основе доказательств. При сосредоточенных усилиях они верят, что значительные улучшения в ландшафте управления ИИ могут быть достигнуты в течение шести месяцев.