Mistral AI запускает новую модель 'Mixture of Experts' и предоставляет ссылку на торрент для скачивания.

Most people like

Откройте для себя революционную силу нашего ИИ-чат-бота, работающего на технологии ChatGPT. Участвуйте в беседах, которые являются проницательными, динамичными и адаптированными к вашим нуждам. Независимо от того, ищете ли вы информацию, помощь или companionship, это ИИ-решение открывает новые горизонты для взаимодействия и поддержки.

Разблокируйте потенциал контрактов и юридических операций для создания более умных соглашений и повышения эффективности. Узнайте, как интеграция этих элементов может преобразить ваши юридические процессы.

В современном быстром темпе академической среды исследователи постоянно ищут инновационные решения для упрощения своей работы и повышения видимости своих результатов. Инструменты искусственного интеллекта и специализированные услуги публикации революционизируют то, как ученые готовят, публикуют и продвигают свои исследования. Этот гид исследует лучшие инструменты ИИ и ресурсы публикации, доступные для помощи исследователям в максимизации их влияния и эффективности в постоянно меняющемся мире академической публикации.

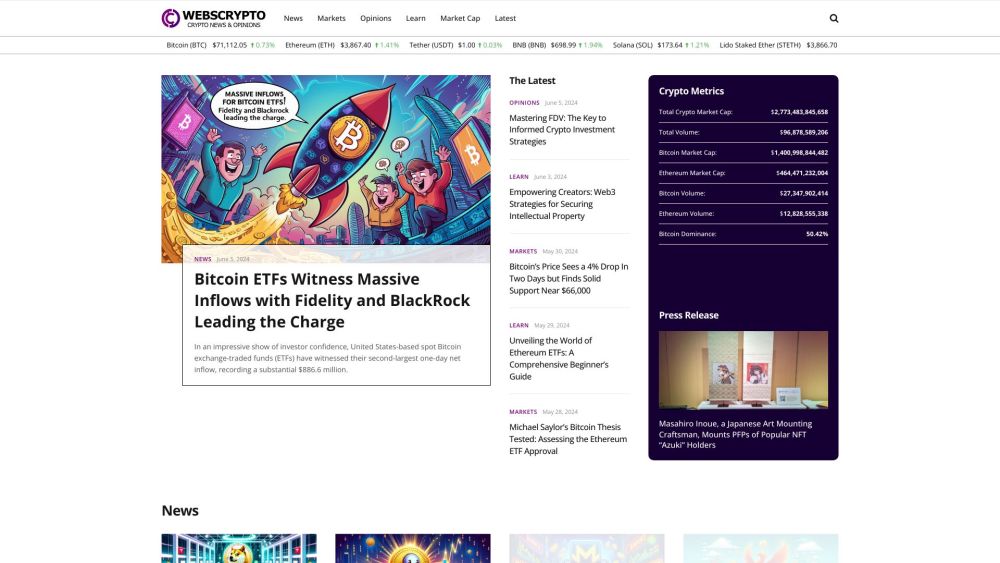

Добро пожаловать в ваш надежный источник свежих новостей о криптовалюте! Оставайтесь в курсе с актуальными обновлениями, экспертными мнениями и глубоким анализом постоянно меняющегося крипто-ландшафта. Независимо от того, являетесь ли вы опытным инвестором или только начинаете, наш центр предлагает ценную информацию, которая поможет вам ориентироваться в динамичном мире цифровых валют. Следите за тенденциями, рыночными движениями и технологическими достижениями, формирующими будущее финансов. Погружайтесь и исследуйте захватывающий мир крипто сегодня!

Find AI tools in YBX

Related Articles

Refresh Articles