Nvidia и Intel установили новые рекорды скорости обучения LLM в результатах бенчмарка MLPerf 3.1.

Most people like

Превратите и улучшите свой мультимедийный контент с помощью нашей бесплатной платформы на основе ИИ. Узнайте, как легко создавать потрясающие визуальные элементы и увлекательный звук совершенно бесплатно!

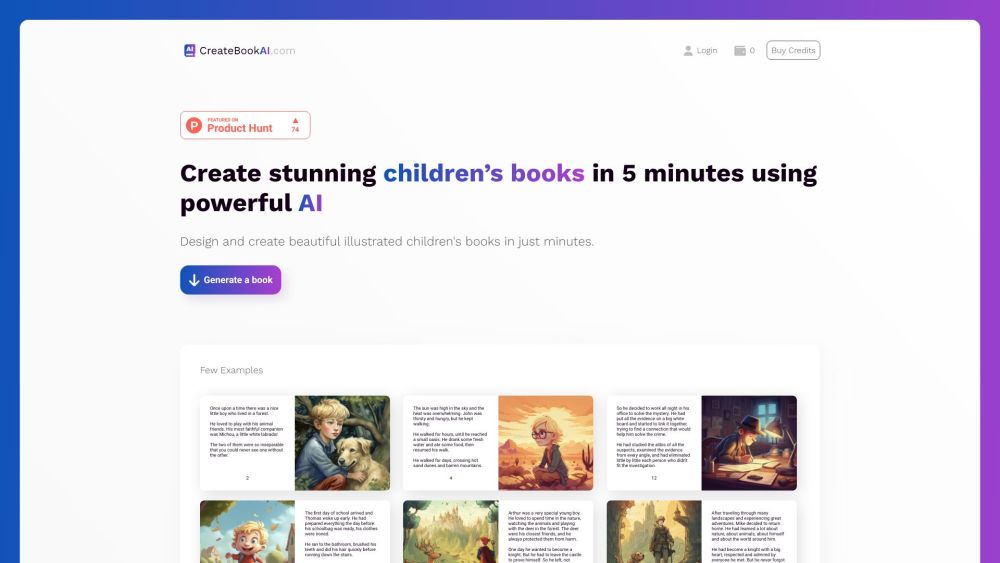

CreateBookAI — это инновационная платформа ИИ, которая позволяет создавать персонализированные детские книги всего за несколько минут, делая storytelling доступным и приятным для семей по всему миру.

В сегодняшнем быстром финансовом мире технологии на основе ИИ революционизируют способы, которыми инвесторы находят возможности и соединяются с предприятиями. Используя продвинутые алгоритмы и анализ данных, эти решения улучшают предсказательные инвестиционные стратегии, позволяя принимать более умные и обоснованные решения. Эта инновация не только упрощает инвестиционный процесс, но и способствует значимым связям между инвесторами и стартапами, открывая путь к росту и успеху на развивающихся рынках. Узнайте, как ИИ трансформирует мир предсказательных инвестиций и сопоставления венчурных проектов, создавая динамическую синергию между капиталом и инновациями.

В стремительно развивающейся области искусственного интеллекта, большие китайские языковые модели для общения находятся на передовом крае инноваций. Эти продвинутые системы созданы для понимания и генерации текстов, схожих с человеческими, что обеспечивает беспрепятственное общение на мандаринском. Поскольку предприятия и отдельные пользователи все чаще ищут эффективные способы взаимодействия и обмена информацией, эта технология трансформирует клиентский сервис, создание контента и многое другое. Узнайте, как эти мощные модели могут улучшить общение и способствовать более глубоким связям в цифровую эпоху.

Find AI tools in YBX

Related Articles

Refresh Articles