國務院支持的報告概述減輕毀滅性人工智慧風險的行動計劃

Most people like

FeedHive是一個創新的人工智慧驅動平台,專為輕鬆創建和管理引人入勝的社交媒體內容而設。無論您是小企業主還是社交媒體經理,FeedHive都能精簡您的內容策略,提升您的在線形象,使您更輕鬆地與受眾建立聯繫。

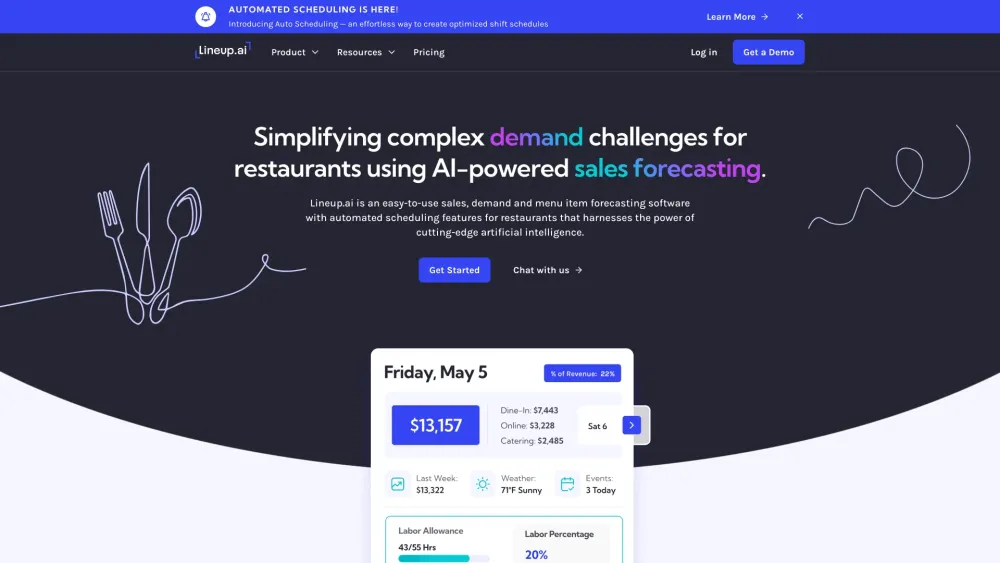

提升您餐廳的效率,運用尖端的人工智慧預測軟體。精簡操作流程、改善庫存管理,並透過人工智慧的力量提升顧客滿意度。探索AI驅動的洞察如何將您的餐飲業務轉變為一台運行順暢的機器,隨時調整以迎合市場趨勢,並增加獲利能力。

在當今這個節奏快速、科技驅動的世界中,全球的企業正積極尋求人工智慧(AI)來提升效率並驅動創新。從自動化日常任務到提供數據驅動的洞察,AI 解決方案使組織能夠保持競爭力,並適應迅速變化的市場。這本指南探索了針對全球企業的各種 AI 技術,展示它們如何轉型業務運作、精簡流程,並最終促進可持續增長。了解實施 AI 如何使您的商業策略革命化,並使您在行業中處於領先地位。

Find AI tools in YBX