Menlo Security 報告:與人工智慧採用相關的網絡安全威脅上升

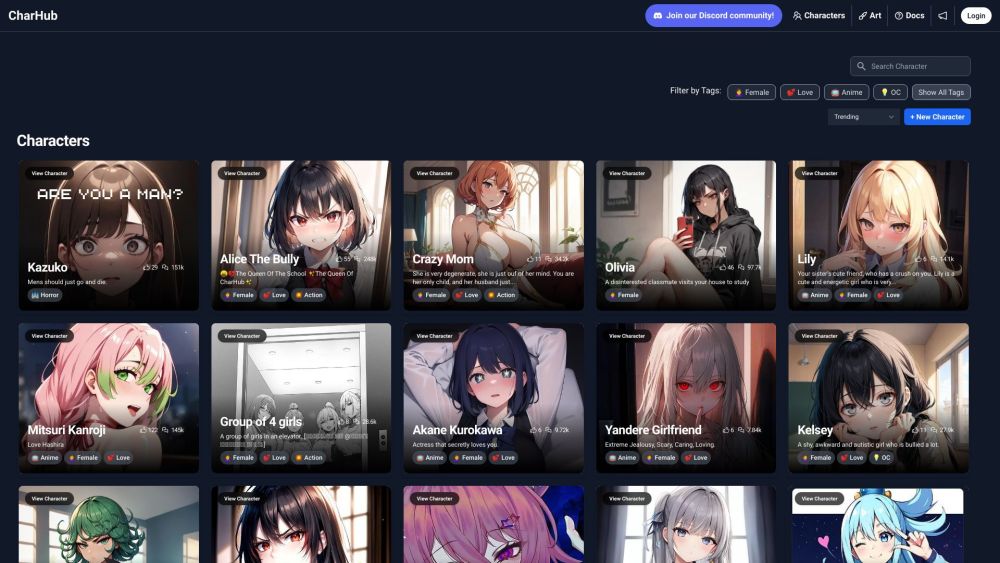

Most people like

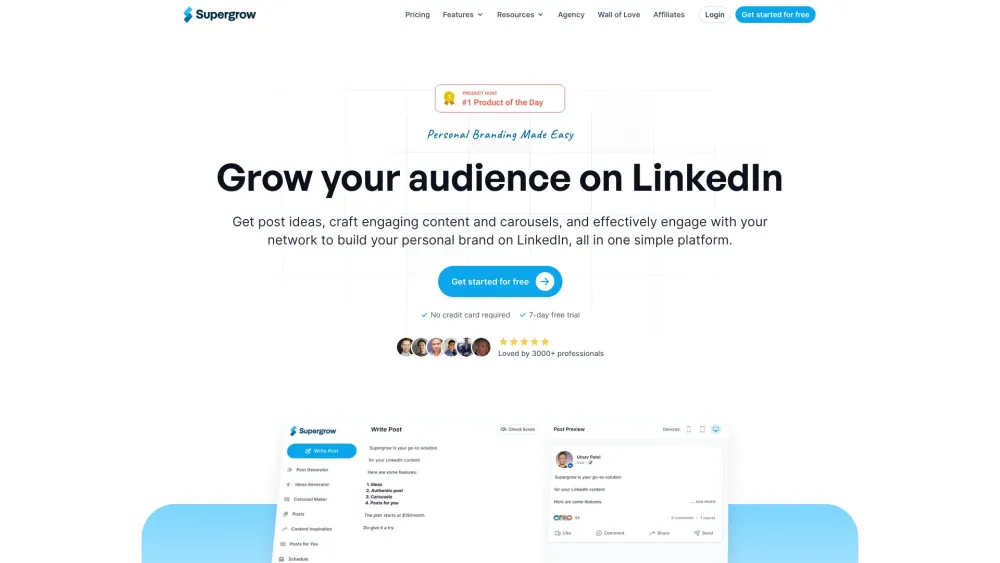

提升您的個人品牌於LinkedIn:成長與成功的策略

利用LinkedIn的力量,有效地建立和擴展您的個人品牌。在當今競爭激烈的職場環境中,建立強大的線上存在感對於把握機會和與行業領袖建立聯繫至關重要。無論您是在尋求新的職業前景,還是希望提升您的可信度,本指南提供切實可行的策略,幫助您在LinkedIn中脫穎而出並蓬勃發展。

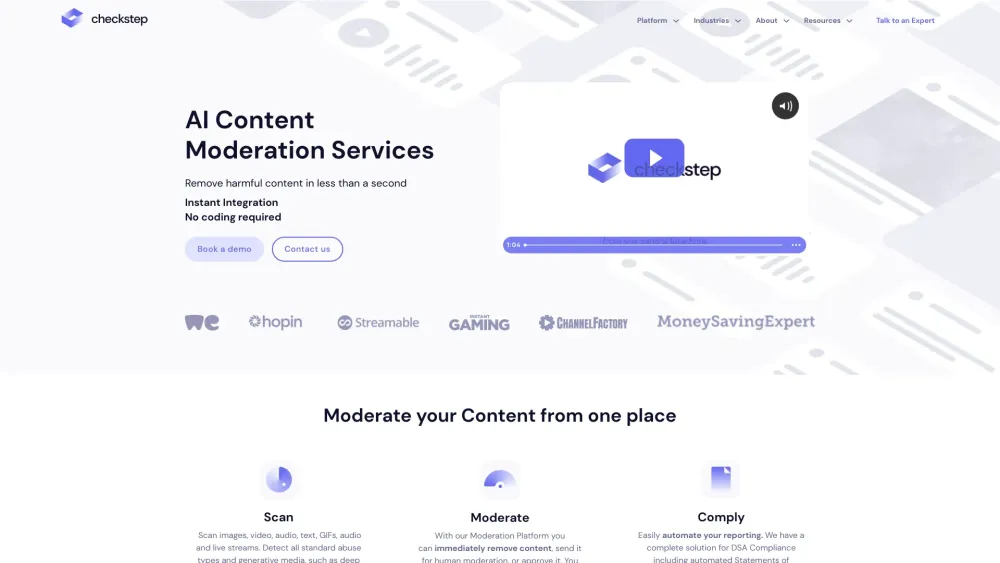

保護您的用戶免受有害內容的侵害

在當前的數位環境中,保護您的用戶免於有害內容比以往任何時候都更為重要。隨著線上互動的增加,接觸不當或危險材料的風險也隨之上升。透過實施強而有力的內容管理策略,您不僅保護了您的受眾,還提升了他們的整體體驗,增強了對您平台的信任與忠誠。今天就優先考慮用戶安全,創造一個安全的線上環境。

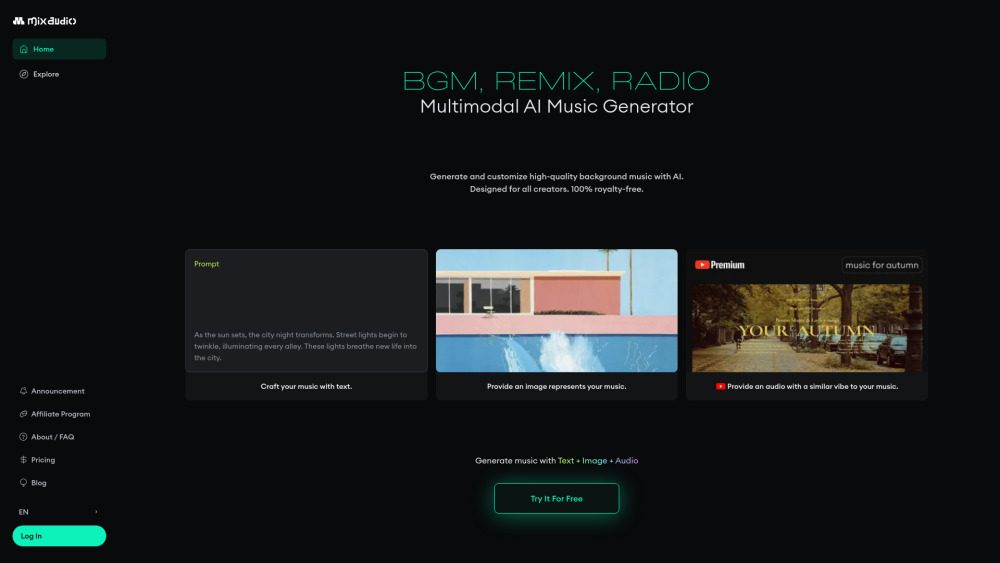

沉浸於令人振奮的音樂創作世界,體驗我們尖端的多模態人工智慧音樂生成器。在短短兩秒鐘內,您可以生成四條獨特的音軌,滿足從新手音樂家到資深專業人士的需求。釋放您的創造潛力,藉助量身定制的創新人工智慧驅動音樂,提升您的項目!

Find AI tools in YBX