NVIDIA與Supermicro:實現成功的關鍵生成AI技術架構

Most people like

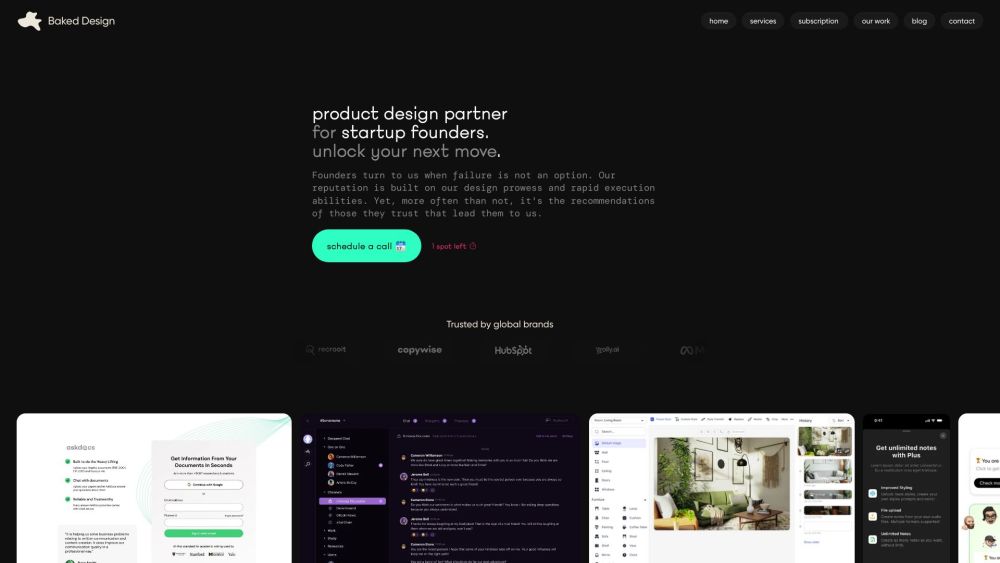

您是一家尋求透過卓越設計提升品牌的新創公司嗎?設計訂閱服務能為您提供持續的專業創意服務,滿足您不斷變化的需求。這種創新方式不僅能節省時間和金錢,還能確保您的品牌在當今快速變化的市場中保持新鮮與競爭力。探索設計訂閱如何成為您新創公司視覺吸引受眾並促進成長的轉捩點。

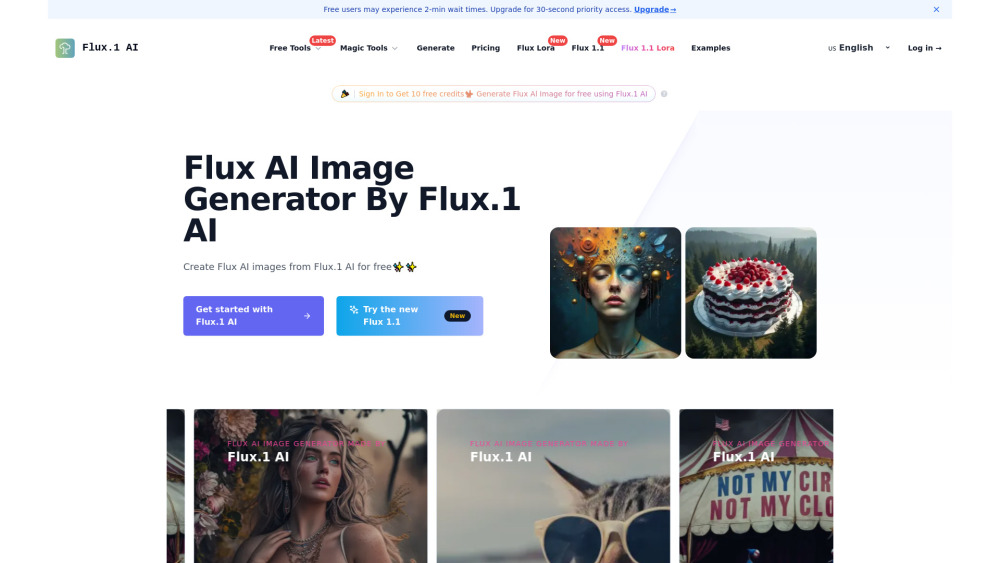

發現一個將文本提示轉化為驚人圖像的 AI 模型的力量。通過利用先進的算法,這個創新的工具使用戶能夠以前所未有的方式視覺化他們的想法和概念。無論你是尋求靈感的藝術家,還是希望增強內容的企業,我們的 AI 驅動圖像生成器為您打開了一個創意實現的世界。激發你的想像力,讓科技為你的文字注入生命!

Find AI tools in YBX

Related Articles

Refresh Articles