Nvidia 執行長黃仁勳親自將首台 DGX H200 系統交付給 OpenAI

Most people like

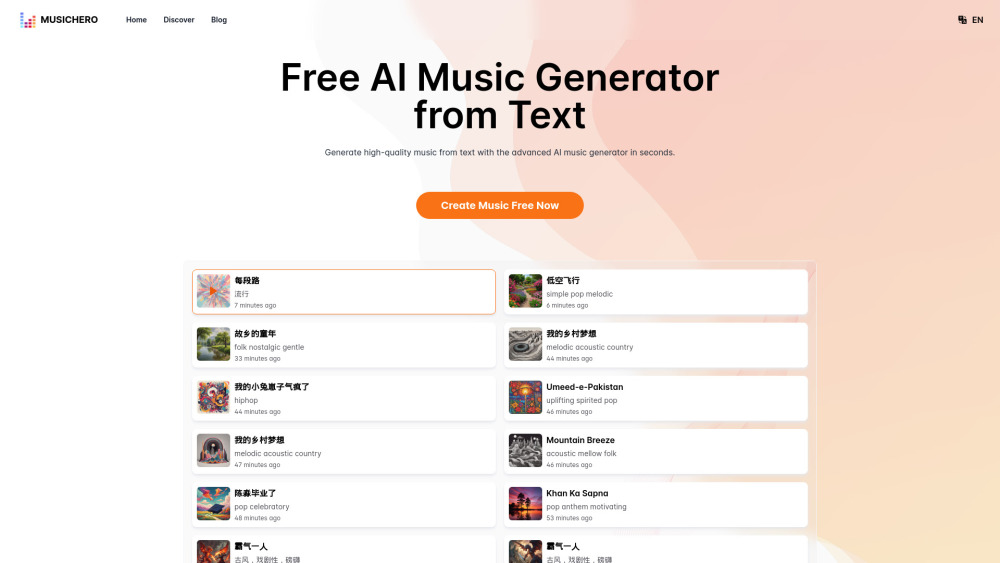

在科技持續重新定義創意的時代,一款將文本轉化為音樂作品的 AI 音樂生成器正在革新音樂產業。這個創新的工具使用戶能夠將書面思想、故事或情感轉化為原創旋律,架起語言與聲音之間的橋樑。無論您是經驗豐富的音樂家還是新興創作者,這款基於 AI 的技術為藝術表達打開了激動人心的新途徑。發現這款強大的 AI 音樂生成器如何激發您的創意,簡化您的工作流程,並提升您的音樂項目。

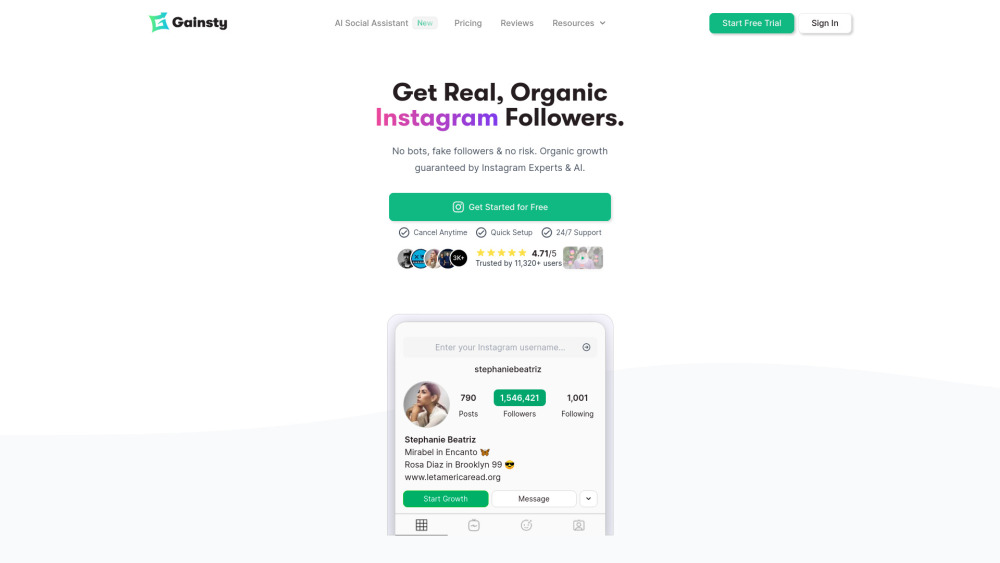

利用我們的人工智慧平台解鎖自然增長的Instagram粉絲。這款創新工具旨在提升您的社交媒體形象,運用先進的算法有效地與目標受眾互動。體驗一個無縫的過程,吸引真正的粉絲,自然擴大您的品牌影響力。立即與我們一起改變您的Instagram策略!

Find AI tools in YBX

Related Articles

Refresh Articles