OpenAI 共同創辦人伊利亞·蘇茲科佛推出新創公司,專注於應對安全超智能的挑戰。

Most people like

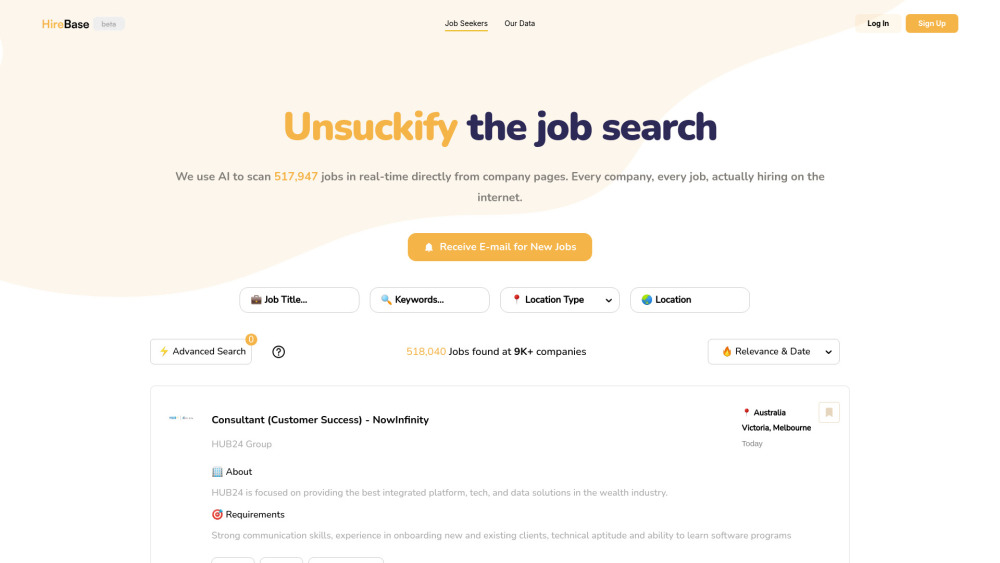

介紹尖端的人工智慧求職引擎,旨在為求職者提供即時的工作索引。我們創新的平台通過提供針對您特定技能和偏好的最新工作列表,簡化了您的求職流程。立即利用我們的人工智慧驅動能力,找到您夢想中的工作!

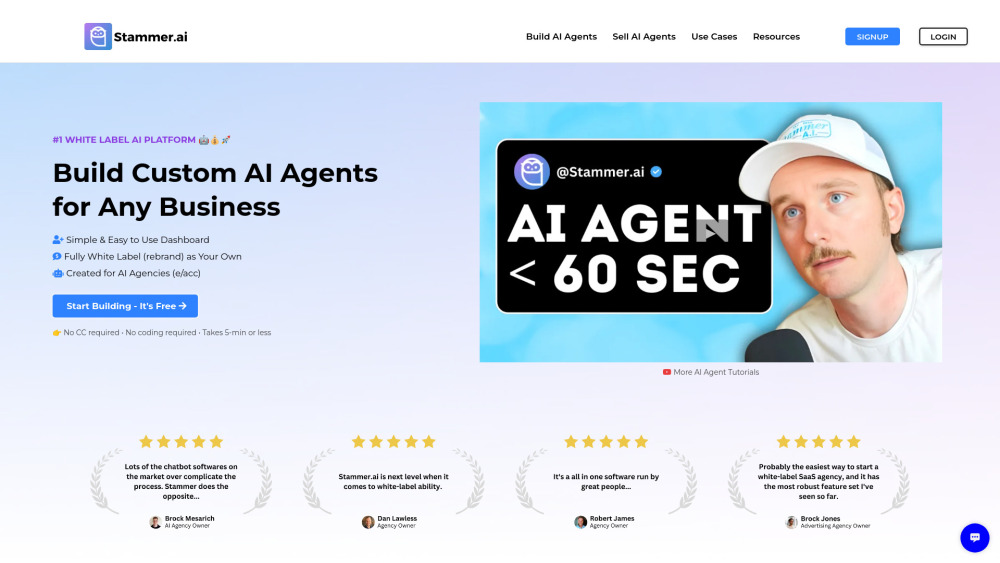

探索專為創建和轉售智能 AI 代理而設計的白標 AI SaaS 解決方案的強大力量。利用我們可定制的平台,轉型您的業務服務,提升客戶體驗,滿足獨特需求。了解我們的創新科技如何提升您的品牌,推動收益增長。

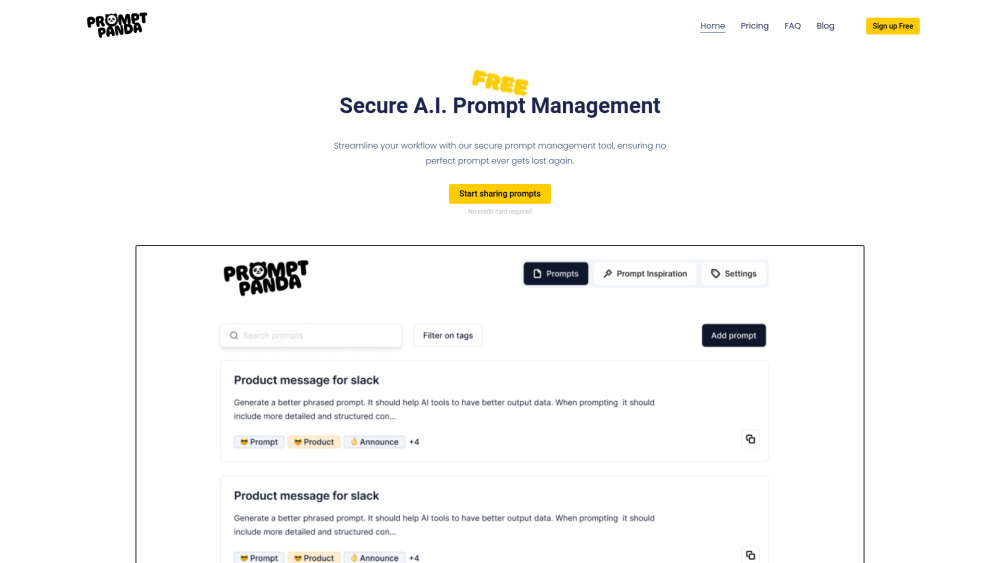

在當今快速變化的數位環境中,有效的人工智慧提示管理對於優化工作流程至關重要。透過運用人工智慧的力量,您可以簡化流程、提升生產力並增強整體效率。本指南將探討關鍵策略和工具,幫助您掌握人工智慧提示管理,確保您的運營順利且高效。

Find AI tools in YBX

Related Articles

Refresh Articles