OpenAI 發布「準備框架」,專注於監測與降低 AI 風險

Most people like

探索AI驅動聊天機器人如何徹底改變客戶服務,提供即時支援、個性化互動及全天候服務. 這些創新工具不僅簡化了溝通,還提高了客戶滿意度與參與度. 探索將AI驅動機器人整合進客戶服務策略的好處,讓您在當今競爭激烈的市場中保持領先.

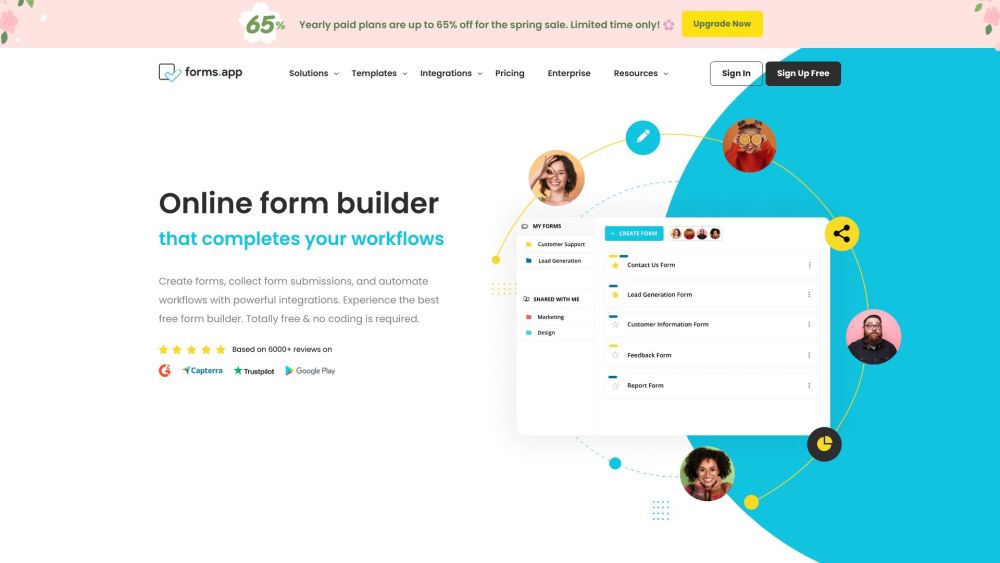

你是否在尋找一個有效且易於使用的解決方案,以低成本創建線上表單?不必再找了!在這本指南中,我們將探討最佳的免費線上表單建構工具,幫助你選擇符合需求的完美工具。無論你需要收集反饋、註冊參加者,還是為研究收集資料,這些高評價的平台都將優化你的流程並提高效率。深入了解,找出最符合你需求的理想表單建構器!

Find AI tools in YBX

Related Articles

Refresh Articles