中國 DeepSeek Coder:首款在性能上超越 GPT-4 Turbo 的開源編碼模型

Most people like

歌曲常常承載著深刻的訊息和情感,邀請聽眾探索其更深層的意義。詮釋歌曲背後的意義,不僅增強了我們對音樂的欣賞,也讓我們與藝術家的意圖及其表達的情感產生聯繫。在本指南中,我們將深入探討各種拆解歌詞和理解其內在故事的技巧。無論你是隨意的聽眾還是音樂愛好者,學習解讀歌曲意義都能豐富你的聆聽體驗,並促進與音樂藝術之間的更深連結。

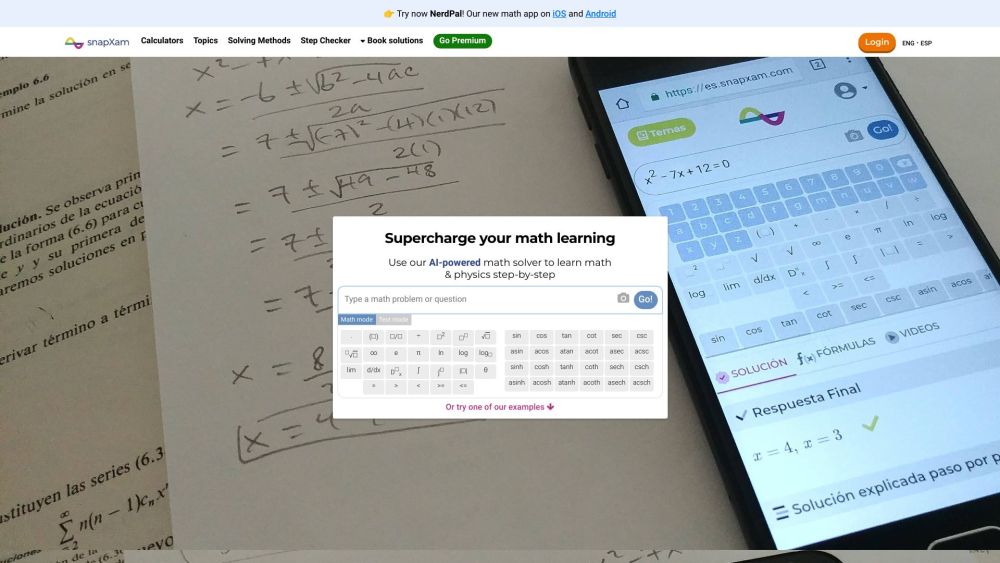

介紹人工智慧驅動的數學和物理輔導器:您終極的學習夥伴

透過我們先進的人工智慧輔導平台,釋放您在數學和物理方面的潛能。這款設計用以提供個性化協助的人工智慧輔導器,會根據您的學習風格進行調整,幫助您掌握挑戰性的概念並在學業上取得優異成績。體驗量身定制的課程、即時反饋,及引人入勝的練習題,讓複雜主題變得易於理解。探索教育的未來,體驗這款改變您學習數學和物理方式的人工智慧輔導器!

Find AI tools in YBX

Related Articles

Refresh Articles