AI2 verbessert das Open-Source OLMo-Modell mit einem vielfältigen Datensatz und einem zweistufigen Curriculum für eine optimierte Leistung.

Most people like

Das Potenzial der KI-gesteuerten Analyse erschließen wir, indem wir die Beziehung zwischen akademischen Abschlüssen und Karriereergebnissen von Absolventen untersuchen. Entdecken Sie, wie fortschrittliche Algorithmen Einblicke in Beschäftigungstrends bieten und angehenden Studierenden helfen können, informierte Entscheidungen über ihren Bildungsweg zu treffen. Begleiten Sie uns auf dieser Reise, um zu verstehen, wie künstliche Intelligenz die Landschaft der Karriereplanung für Absolventen neu gestaltet.

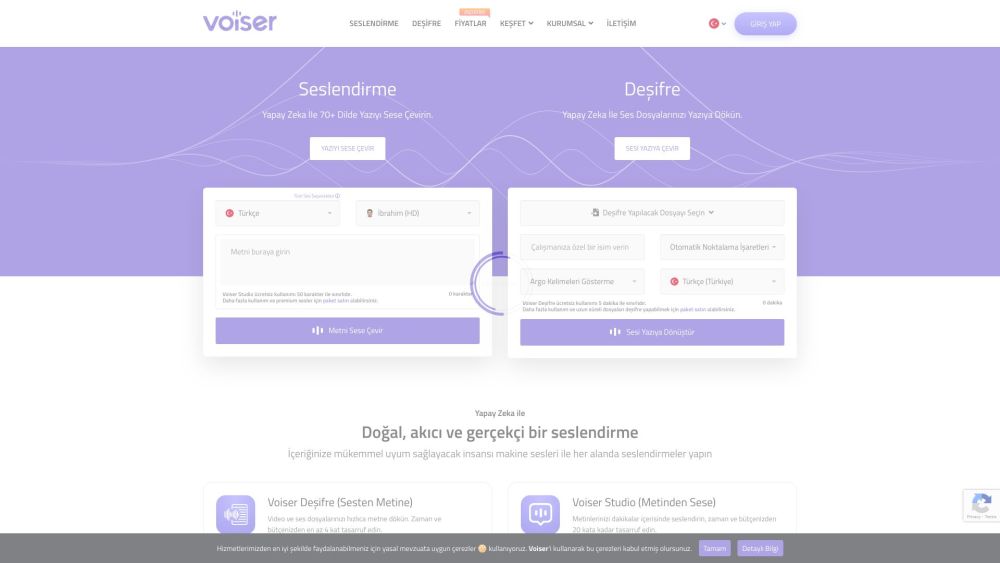

Voiser ist ein fortschrittliches KI-Programm, das Text nahtlos in Sprache und umgekehrt verwandelt und dabei realistische, menschenähnliche Stimmen für eine verbesserte Kommunikation nutzt. Erleben Sie die Leistungsfähigkeit modernster Sprachsynthese- und Spracherkennungstechnologie mit Voiser.

Präsentieren Sie unsere KI-gestützte Plattform, die für umfassende Dokumentenanalysen, interaktive Chats, nahtlose Zusammenarbeit und dynamische Inhaltserstellung konzipiert ist. Steigern Sie Ihre Produktivität und optimieren Sie Ihre Arbeitsabläufe mit modernster Technologie, die speziell für Fachkräfte entwickelt wurde.

Find AI tools in YBX

Related Articles

Refresh Articles