Analyse von Microsofts Copilot KI: Verständnis für unberechenbare Antworten und das Phänomen der PUA-Nutzer

Most people like

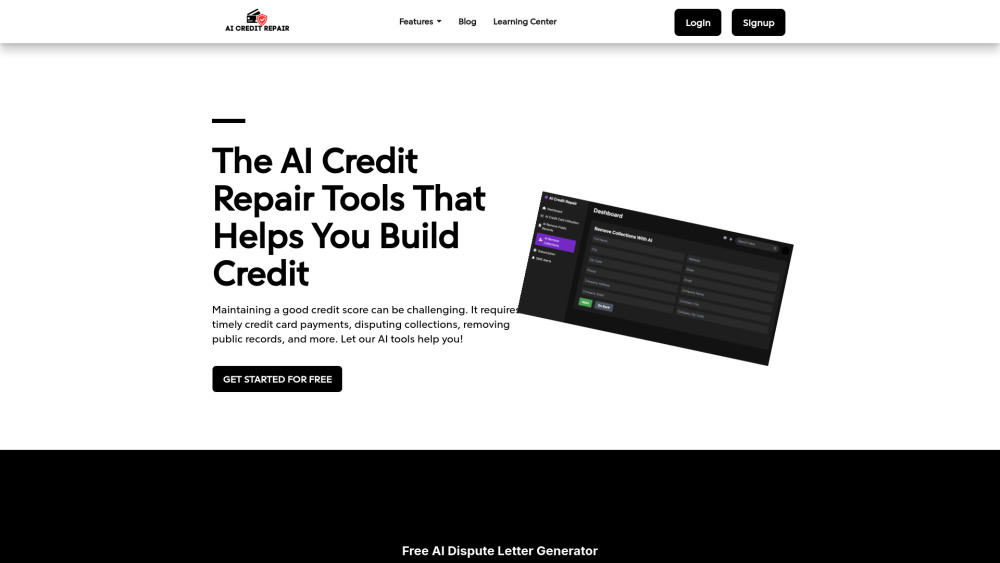

Entdecken Sie innovative KI-Tools, die entwickelt wurden, um Kreditbewertungen effektiv zu verbessern und zu reparieren. Diese fortschrittlichen Technologien bieten maßgeschneiderte Lösungen, um Ihren Kreditbericht zu verstehen, Probleme zu identifizieren und Verbesserungsstrategien umzusetzen. Mit dem Aufstieg der künstlichen Intelligenz war es noch nie so einfach, Ihre Kreditgesundheit zu optimieren. Nutzen Sie das Potenzial dieser KI-gesteuerten Plattformen, um die Kontrolle über Ihre finanzielle Zukunft zu übernehmen.

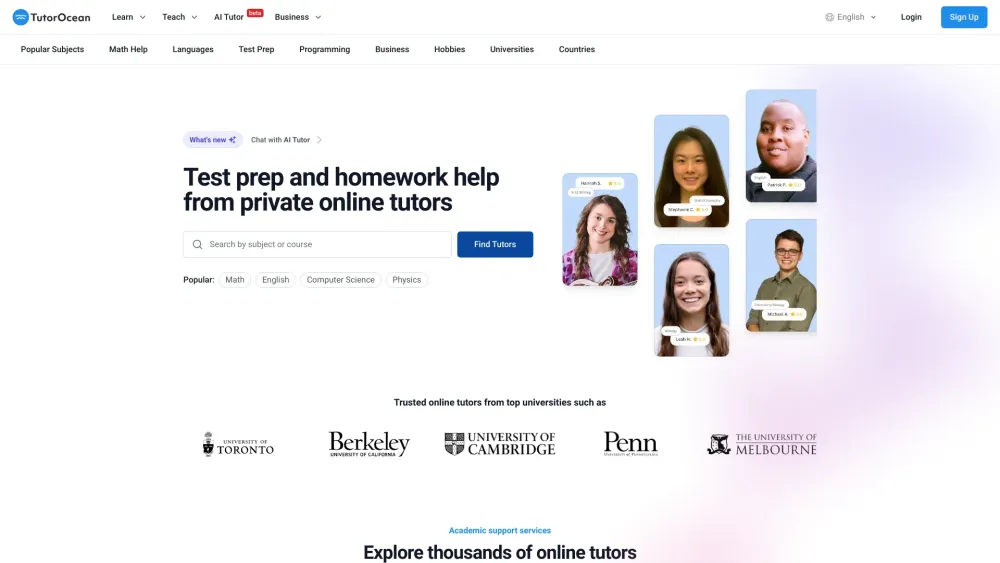

Entdecken Sie erschwingliches privates Online-Tutoring und fachkundige Hausaufgabenhilfe, die auf Ihre Bedürfnisse zugeschnitten ist. Ob Sie Ihre Noten verbessern oder herausfordernde Fächer verstehen möchten, unsere engagierten Tutoren bieten Ihnen individuelle Unterstützung. Entfalten Sie Ihr akademisches Potenzial mit bequemem Online-Lernen noch heute!

Präsentation eines intelligenten Assistenten mit unbegrenzten Speicherfähigkeiten. Dieses fortschrittliche Werkzeug erinnert nicht nur an alles, sondern steigert auch Ihre Produktivität und Effizienz und verändert die Art und Weise, wie Sie Aufgaben und Informationen verwalten. Entdecken Sie, wie diese leistungsstarke Ressource Ihre täglichen Abläufe revolutionieren und Ihr Leben mühelos organisieren kann.

Revolutionieren Sie Ihre Werbestrategie mit unserem modernen KI-Tool, das sofort überzeugende Werbetexte erstellt. Transformieren Sie die Art und Weise, wie Sie Marketinginhalte erzeugen, und stellen Sie sicher, dass Ihre Botschaften bei Ihrem Publikum ankommen, während Sie Zeit und Mühe sparen. Entdecken Sie die Möglichkeiten der künstlichen Intelligenz zur Erstellung effektiver Anzeigen, die die Interaktion fördern und die Konversionen steigern.

Find AI tools in YBX

Related Articles

Refresh Articles