ChatGPT läuft aus dem Ruder: Verwirrendes Kauderwelsch statt klarer Antworten

Most people like

Präsentation unserer KI-Plattform, die speziell für das Schreiben, Bearbeiten und Forschen entwickelt wurde. Dieses innovative Tool nutzt die Leistungsfähigkeit der künstlichen Intelligenz, um Ihr Schreiberlebnis zu verbessern, den Bearbeitungsprozess zu optimieren und umfassende Recherchen zu unterstützen. Ob Sie Student, Fachkraft oder kreativer Denker sind, unsere KI-Plattform steht bereit, um Ihre Inhalte zu optimieren. Entdecken Sie, wie unsere Technologie Ihre Schreibprojekte mit Präzision und Effizienz transformieren kann.

Wir stellen einen optimierten Service vor, der darauf ausgelegt ist, Produktinformationen von Lieferanten zu sammeln, zu organisieren und zu bearbeiten, um sie anschließend nahtlos auf verschiedenen Listing-Plattformen zu verteilen. Diese Lösung vereinfacht Ihren Arbeitsablauf und sorgt dafür, dass Ihre Produktdaten genau und bereit sind, Kunden effektiv zu erreichen.

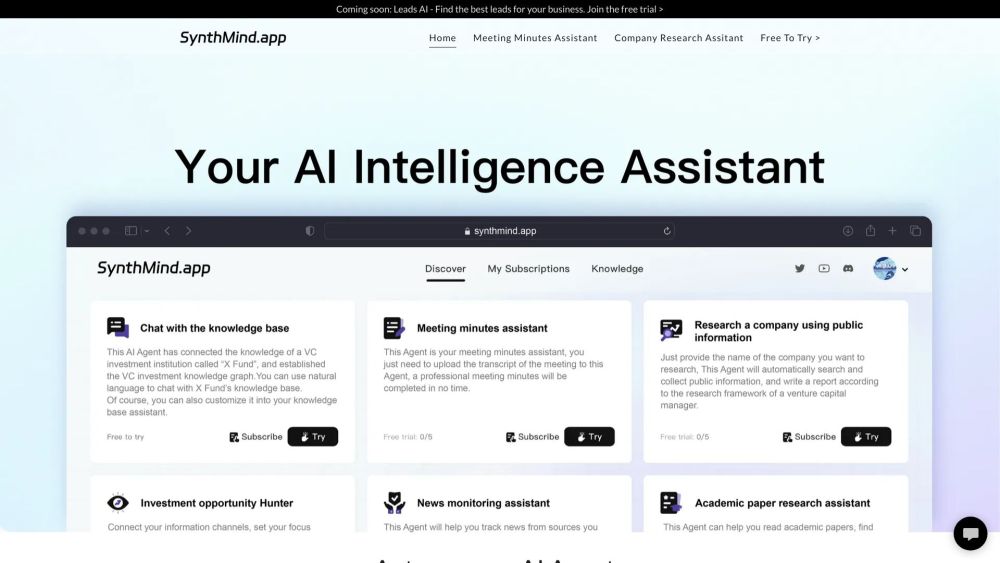

In der heutigen, schnelllebigen Welt ist der Zugang zu zeitnahen und präzisen Informationen entscheidend für fundierte Entscheidungen. Unsere von KI unterstützten Sofortforschungsberichte bieten umfassende Einblicke in Rekordzeit und ermöglichen es Unternehmen und Einzelpersonen, der Konkurrenz einen Schritt voraus zu sein. Durch die Nutzung der Möglichkeiten künstlicher Intelligenz liefern wir maßgeschneiderte Forschung, die Ihr Verständnis komplexer Themen vertieft und es Ihnen ermöglicht, mühelos informierte Entscheidungen zu treffen. Tauchen Sie ein in eine Welt der schnellen Forschung und erleben Sie die Zukunft der Informationsbeschaffung noch heute!

Find AI tools in YBX

Related Articles

Refresh Articles