Chat mit RTX: Erstellen Sie maßgeschneiderte lokale Chatbots für Ihren Nvidia AI-PC.

Most people like

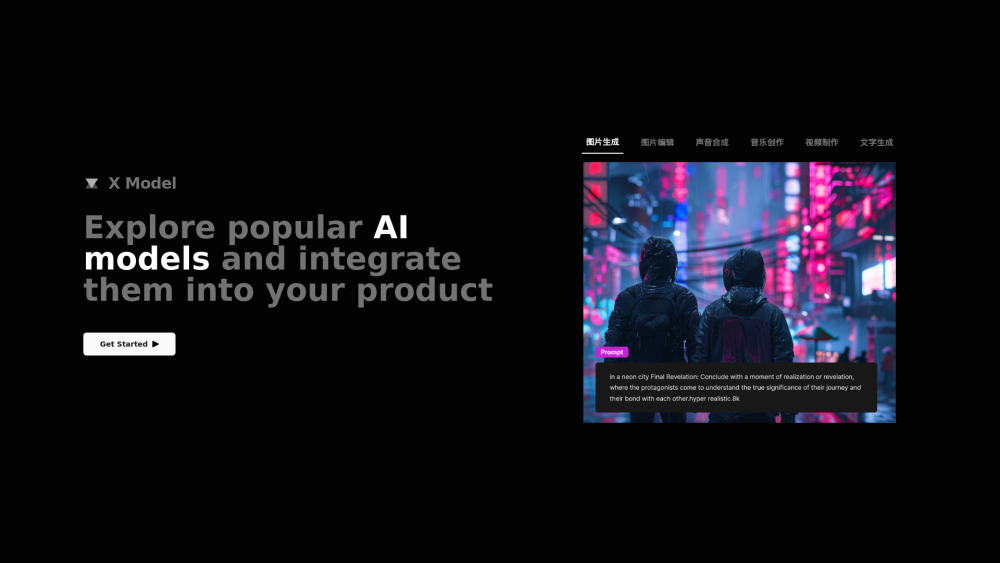

In der heutigen Wettbewerbslandschaft suchen Unternehmen ständig nach innovativen Lösungen zur Verbesserung ihrer Produkte. Hier kommt das AI Model Integration Tool ins Spiel – eine fortschrittliche Plattform, die darauf ausgelegt ist, künstliche Intelligenz nahtlos in Ihren Produktentwicklungsprozess zu integrieren. Durch die Nutzung von KI-Funktionen verbessert dieses Tool die Produktmerkmale, optimiert die Leistung und steigert die Nutzerbindung, wodurch Ihre Marke einen Schritt voraus ist. Entdecken Sie, wie die Integration von KI Ihre Produktangebote revolutionieren und die Kundenzufriedenheit steigern kann.

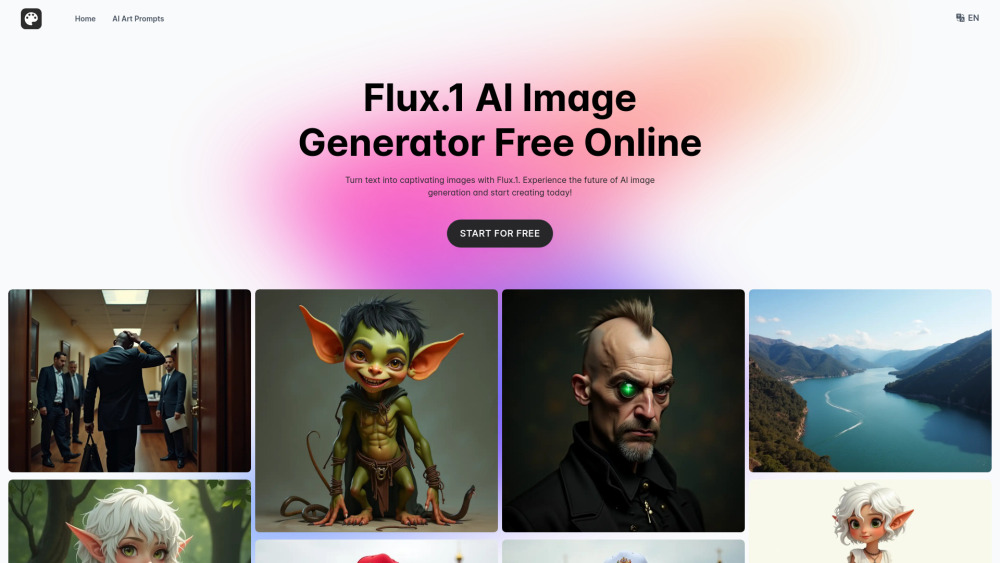

Erstellen Sie atemberaubende, hochwertige Bilder aus Text mit der Kraft der KI. Verwandeln Sie Ihre Worte mühelos in visuell fesselnde Kunst.

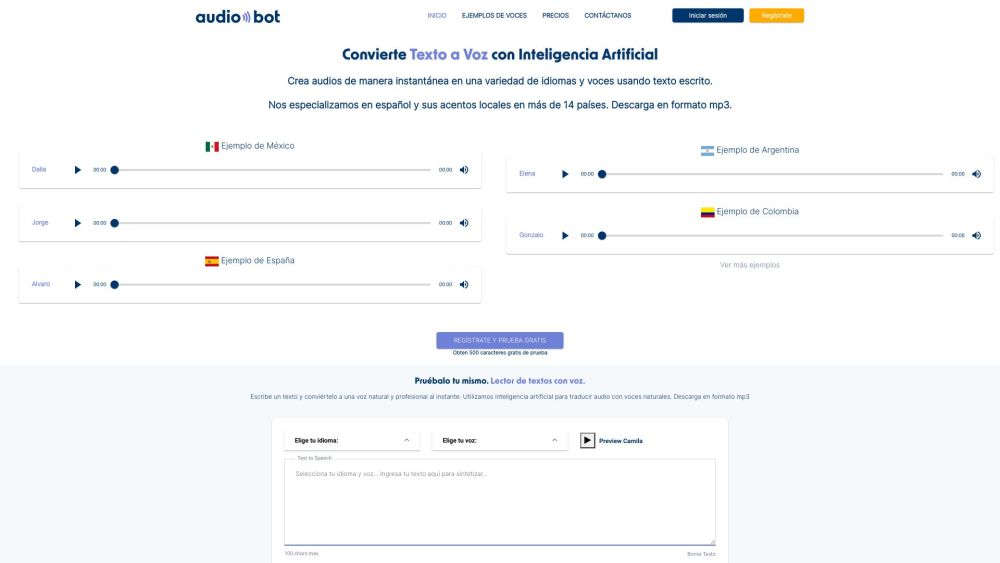

Präsentation von AudioBot: ein fortschrittliches KI-Tool, das nahtlos Text in lebensechte, natürlich klingende Stimmen umwandelt. Erleben Sie die Zukunft der Sprachsynthese mit AudioBot, wo modernste Technologie Ihre geschriebenen Inhalte mit Klarheit und Emotion zum Leben erweckt.

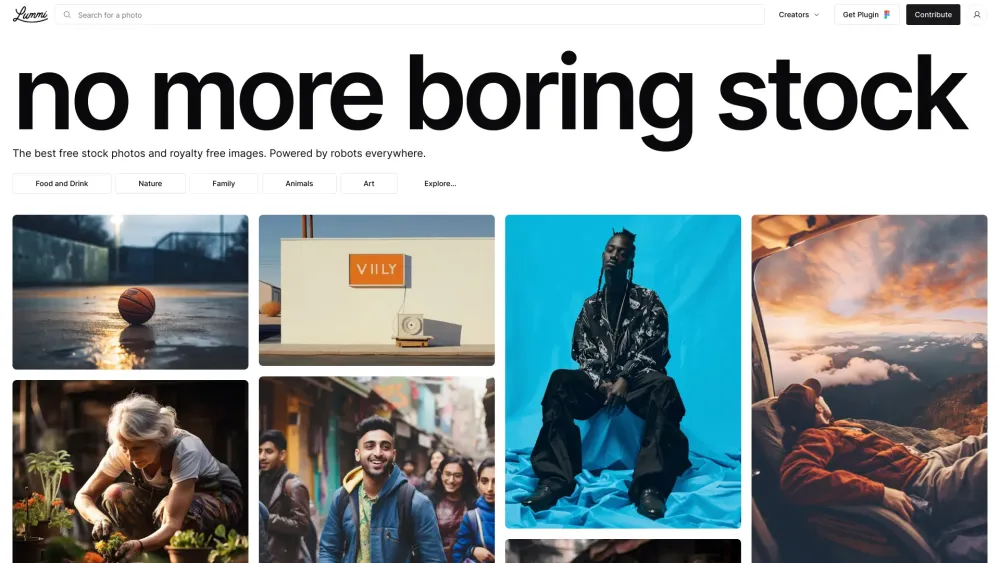

Entdecken Sie die Welt der KI-kuratierten Stockfotos, in der moderne Technologie auf beeindruckende Visuals trifft. Durchstöbern Sie eine umfangreiche Sammlung hochwertiger Bilder, die von künstlicher Intelligenz sorgfältig ausgewählt wurden, um Ihren kreativen Bedürfnissen gerecht zu werden. Ob für Marketingkampagnen, soziale Medien oder persönliche Projekte – unsere KI-gesteuerte Plattform stellt sicher, dass Sie die perfekten Stockfotos finden, die bei Ihrem Publikum ankommen. Tauchen Sie ein in eine neue Ära der Bildsprache und heben Sie Ihre Projekte heute mit auffälligen Visuals hervor!

Find AI tools in YBX

Related Articles

Refresh Articles